Create an experiment

W&B の 実験 を作成します。

2 minute read

数行のコードで 機械学習 の 実験 を追跡します。次に、インタラクティブ ダッシュボードで 結果 を確認するか、Public APIを使用して、プログラムで アクセス できるように データ を Python にエクスポートできます。

PyTorch, Keras, or Scikitのような一般的な フレームワーク を使用する場合は、W&B インテグレーション を活用してください。インテグレーション の完全なリストと、W&B を コード に追加する方法については、インテグレーション ガイドを参照してください。

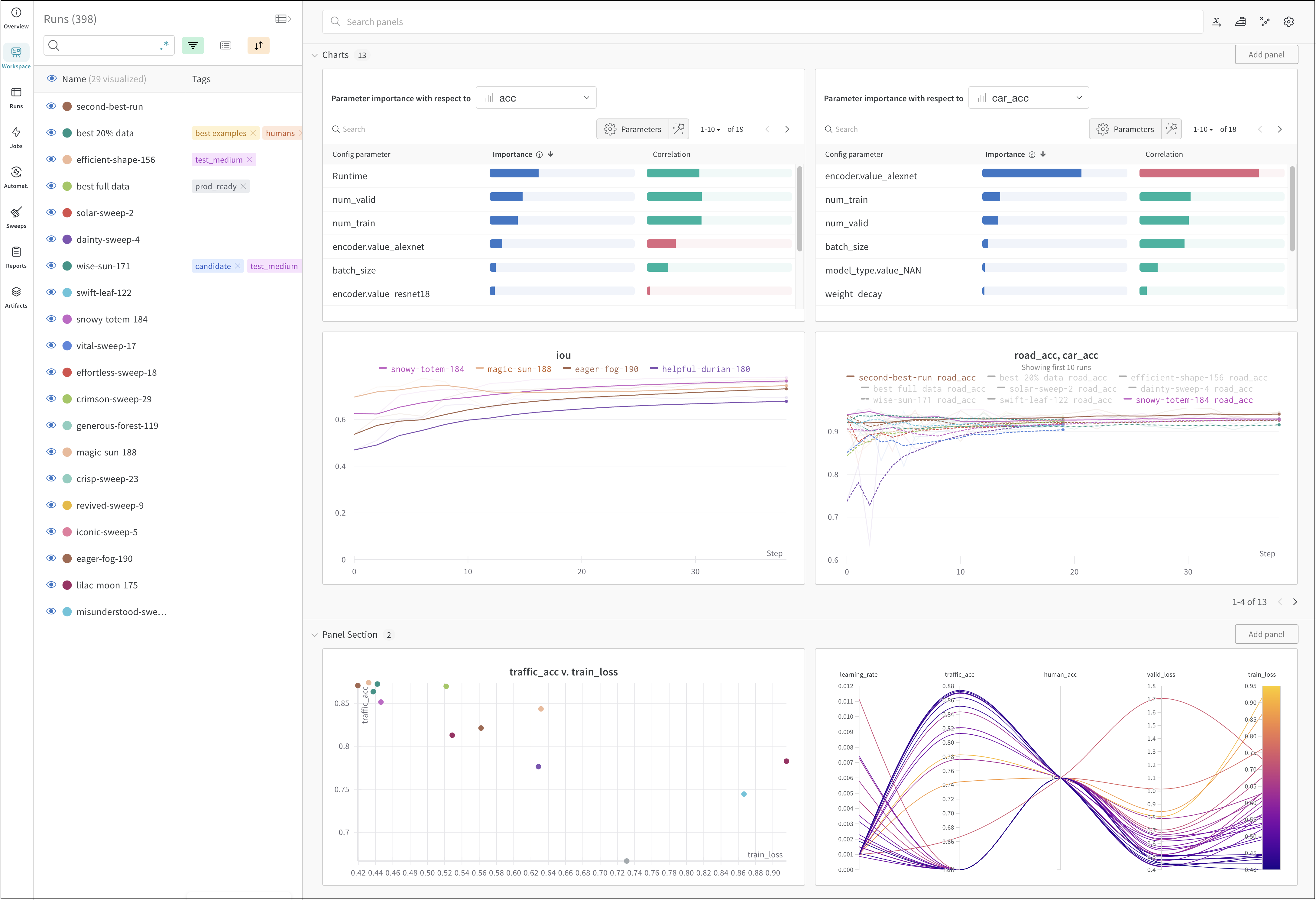

上の図は、複数の runsにわたって メトリクス を表示および比較できる ダッシュボード の例を示しています。

数行の コード で 機械学習 の 実験 を追跡します。

run.config)に保存します。run.log())を ログ に記録します。次の コード は、一般的な W&B の 実験 管理 ワークフロー を示しています。

# Start a run.

#

# When this block exits, it waits for logged data to finish uploading.

# If an exception is raised, the run is marked failed.

with wandb.init(entity="", project="my-project-name") as run:

# Save mode inputs and hyperparameters.

run.config.learning_rate = 0.01

# Run your experiment code.

for epoch in range(num_epochs):

# Do some training...

# Log metrics over time to visualize model performance.

run.log({"loss": loss})

# Upload model outputs as artifacts.

run.log_artifact(model)

ユースケース に応じて、次の リソース を調べて W&B Experiments を開始してください。

実験 と ログ の ベストプラクティス と ヒント については、Best Practices: Experiments and Loggingを参照してください。

W&B の 実験 を作成します。

実験 の 設定 を保存するには、 辞書 のような オブジェクト を使用します

モデルのバージョンを比較し、スクラッチ ワークスペース で結果を調査し、 学び をレポートにエクスポートして、メモと 可視化 を保存します。

インタラクティブな 可視化 で run のデータを探索できるプレイグラウンド

W&B の基本的な構成要素である Runs について学びましょう。

メトリクス 、動画、カスタムプロットなどを追跡

Jupyter で W&B を使用して、 ノートブック から離れることなくインタラクティブな 可視化 を取得できます。

推奨される範囲内で ログ を記録することで、W&B のページをより速く、より応答性の高い状態に保つことができます。

MLFlow から<について>データ をインポートしたり、W&B に保存した<について>データ をエクスポートまたは更新したりします。

W&B の 環境 変数 を設定します。

[i18n] feedback_question

Glad to hear it! Please tell us how we can improve.

Sorry to hear that. Please tell us how we can improve.