Integrations

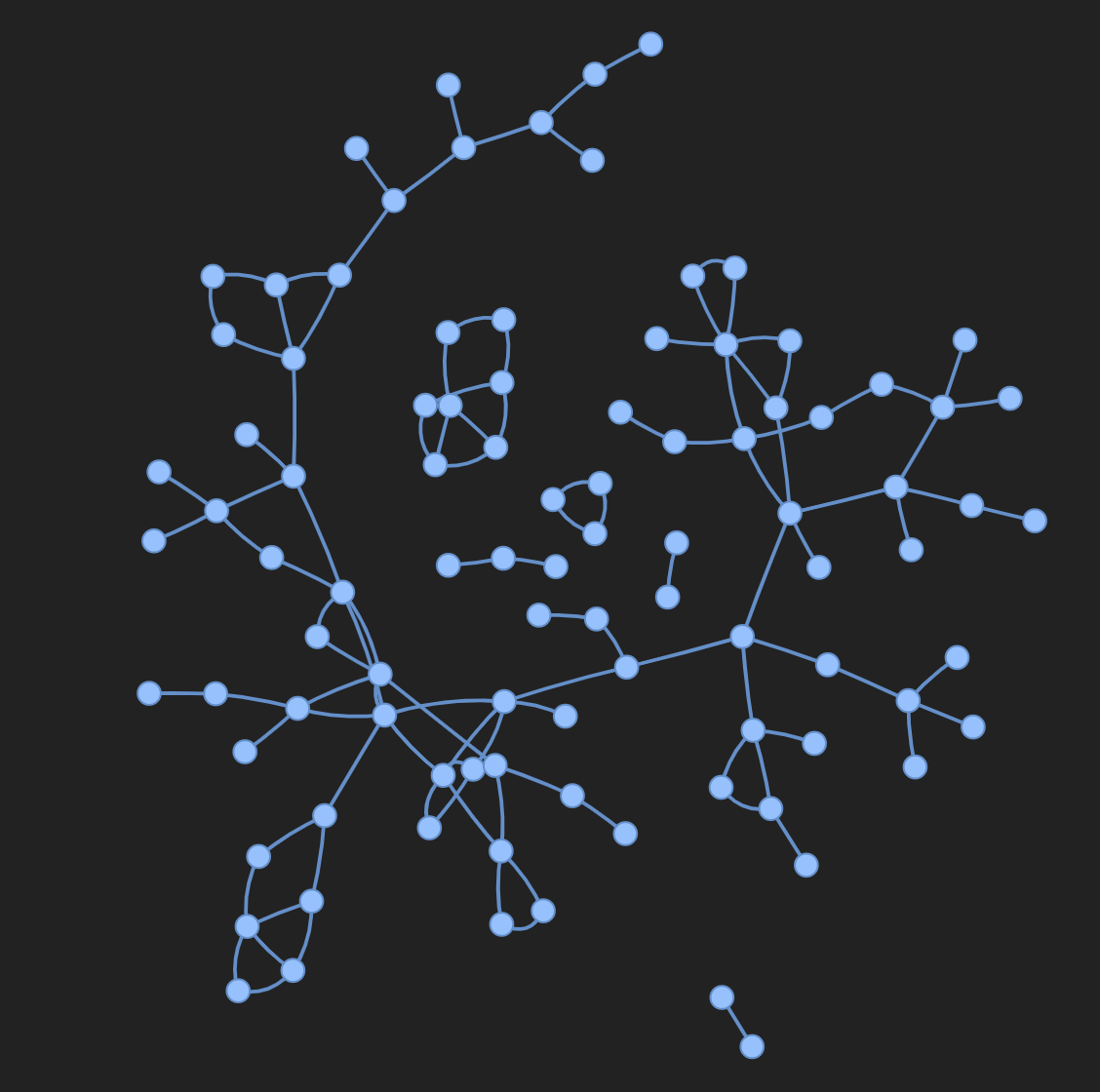

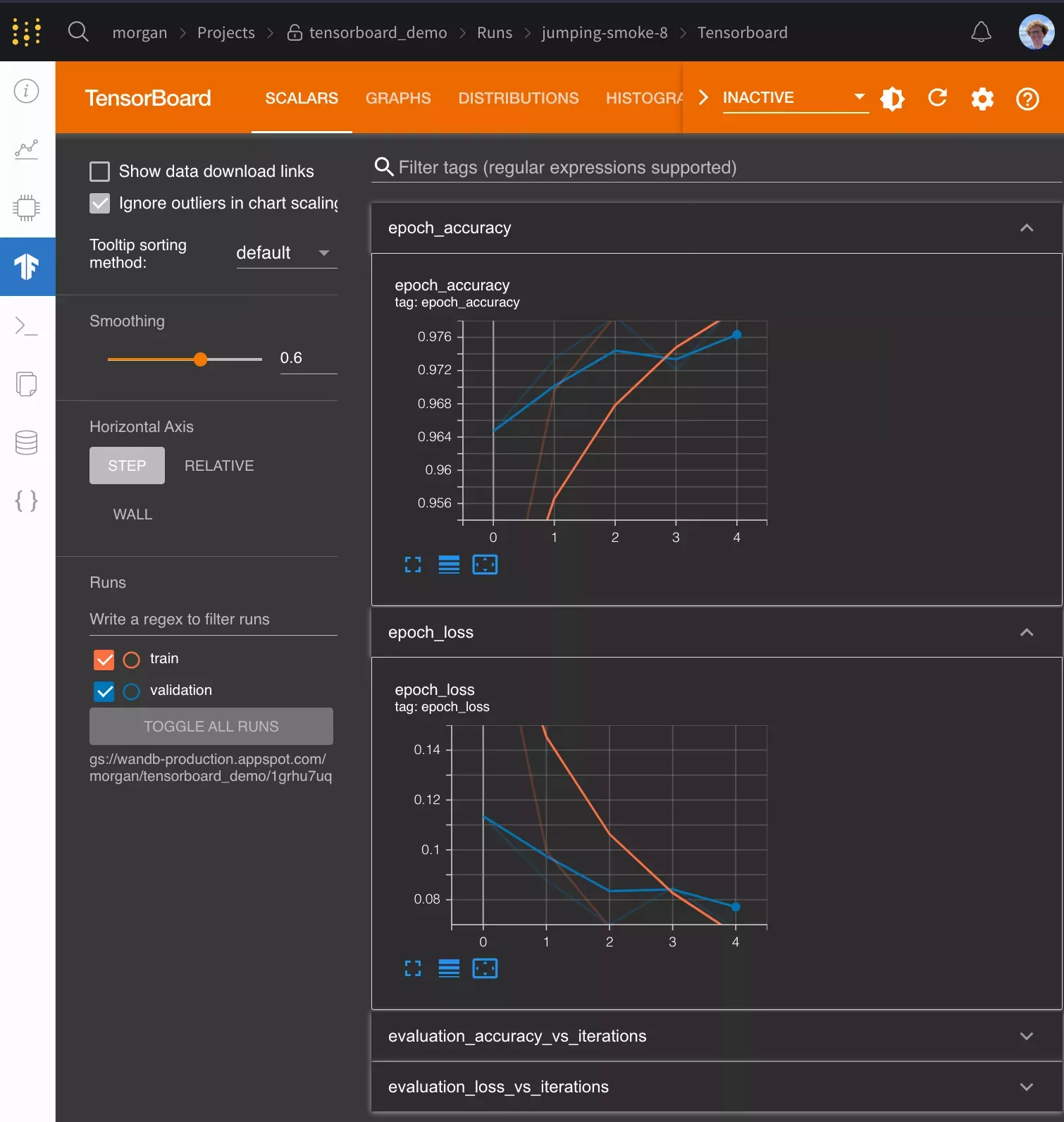

W&B の インテグレーション により、既存の プロジェクト 内で 実験管理 と データ バージョン管理 を迅速かつ簡単にセットアップできます。PyTorch などの ML フレームワーク、Hugging Face などの ML ライブラリ、または Amazon SageMaker などの クラウド サービス向けの インテグレーション をご確認ください。

VIDEO

関連リソース

1 - Add wandb to any library

任意のライブラリに wandb を追加する

このガイドでは、強力な 実験管理 、GPU とシステム監視、モデルチェックポイントなど、独自のライブラリのための機能を W&B と統合するためのベストプラクティスを提供します。

W&B の使用方法をまだ学習中の場合は、先に進む前に、

実験管理 など、これらのドキュメントにある他の W&B ガイドを確認することをお勧めします。

以下では、作業中のコードベースが単一の Python トレーニングスクリプトまたは Jupyter ノートブックよりも複雑な場合の、ベストなヒントとベストプラクティスについて説明します。取り上げるトピックは次のとおりです。

セットアップ要件

ユーザーログイン

wandb の Run の開始

Run の設定の定義

W&B へのログ記録

分散トレーニング

モデルチェックポイントなど

ハイパーパラメータの チューニング

高度な インテグレーション

セットアップ要件

開始する前に、ライブラリの依存関係に W&B を必須にするかどうかを決定します。

インストール時に W&B を必須とする

W&B Python ライブラリ(wandb)を依存関係ファイルに追加します。たとえば、requirements.txt ファイルに追加します。

torch== 1.8.0

...

wandb== 0.13 .*

インストール時に W&B をオプションにする

W&B SDK(wandb)をオプションにするには、2つの方法があります。

A. ユーザーが手動でインストールせずに wandb 機能を使用しようとしたときにエラーを発生させ、適切なエラーメッセージを表示します。

try :

import wandb

except ImportError :

raise ImportError (

"You are trying to use wandb which is not currently installed."

"Please install it using pip install wandb"

)

B. Python パッケージを構築している場合は、wandb をオプションの依存関係として pyproject.toml ファイルに追加します。

[project ]

name = "my_awesome_lib"

version = "0.1.0"

dependencies = [

"torch" ,

"sklearn"

]

[project .optional-dependencies ]

dev = [

"wandb"

]

ユーザーログイン

APIキー を作成する

APIキー は、クライアントまたはマシンを W&B に対して認証します。 APIキー は、ユーザープロフィールから生成できます。

右上隅にあるユーザープロフィールアイコンをクリックします。

[User Settings(ユーザー設定) ]を選択し、[API Keys(APIキー) ]セクションまでスクロールします。

[Reveal(表示) ]をクリックします。表示された APIキー をコピーします。 APIキー を非表示にするには、ページをリロードします。

wandb ライブラリをインストールしてログインするwandb ライブラリをローカルにインストールしてログインするには:

Command Line

Python

Python notebook

WANDB_API_KEY 環境変数 を APIキー に設定します。

export WANDB_API_KEY= <your_api_key>

wandb ライブラリをインストールしてログインします。

pip install wandb

wandb login

import wandb

wandb. login()

!pip install wandb

import wandb

wandb.login()

ユーザーが上記の手順に従わずに初めて wandb を使用する場合、スクリプトが wandb.init を呼び出すと、自動的にログインを求められます。

Run を開始する

W&B Run は、W&B によって記録される計算の単位です。通常、トレーニング実験ごとに単一の W&B Run を関連付けます。

W&B を初期化し、コード内で Run を開始するには:

オプションで、プロジェクトの名前を指定したり、エンティティパラメーターのユーザー名やチーム名(wandb_entity)とともに、コード内の wandb_project などのパラメーターを使用して、ユーザー自身に設定させたりできます。

run = wandb. init(project= wandb_project, entity= wandb_entity)

Run を終了するには、run.finish() を呼び出す必要があります。これがインテグレーションの設計で機能する場合は、Run をコンテキストマネージャーとして使用します。

# When this block exits, it calls run.finish() automatically.

# If it exits due to an exception, it uses run.finish(exit_code=1) which

# marks the run as failed.

with wandb. init() as run:

...

wandb.init をいつ呼び出すか?ライブラリは、W&B Run をできるだけ早く作成する必要があります。これは、エラーメッセージを含むコンソール内のすべての出力が W&B Run の一部として記録されるためです。これにより、デバッグが容易になります。

wandb をオプションの依存関係として使用するユーザーがライブラリを使用する際に wandb をオプションにしたい場合は、次のいずれかの方法があります。

trainer = my_trainer(... , use_wandb= True )

python train.py ... --use-wandb

または、wandb.init で wandb を disabled に設定します。

wandb. init(mode= "disabled" )

export WANDB_MODE= disabled

または

または、wandb をオフラインに設定します。これは、wandb を実行しますが、インターネット経由で W&B に通信しようとはしません。

Environment Variable

Bash

export WANDB_MODE= offline

または

os. environ['WANDB_MODE' ] = 'offline'

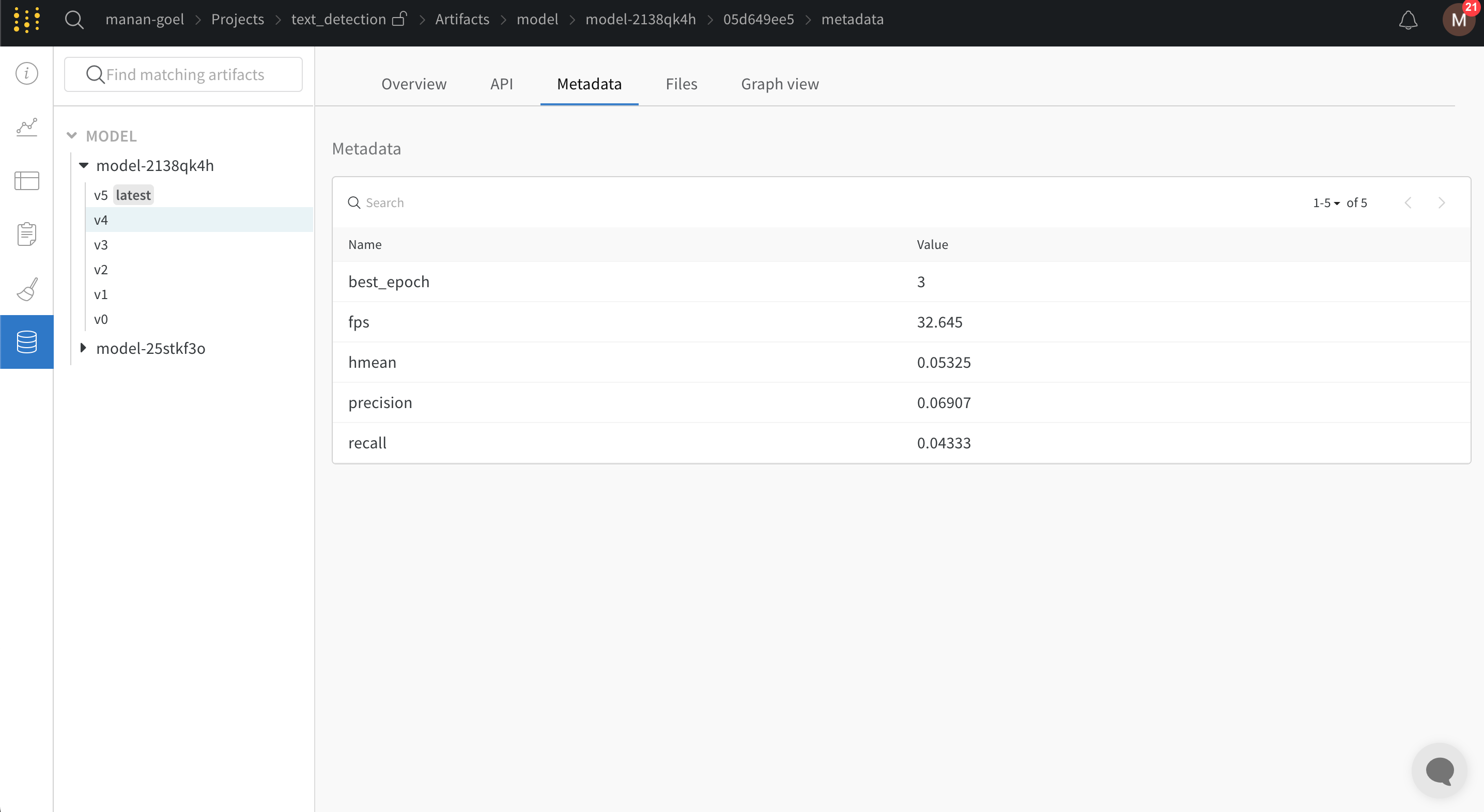

Run の設定を定義する

wandb の Run の設定を使用すると、W&B Run の作成時にモデル、データセットなどに関するメタデータを提供できます。この情報を使用して、さまざまな実験を比較し、主な違いをすばやく理解できます。

ログに記録できる一般的な設定パラメーターは次のとおりです。

モデル名、バージョン、アーキテクチャー パラメーターなど。

データセット名、バージョン、トレーニング/検証の例の数など。

学習率、 バッチサイズ 、 オプティマイザー などのトレーニングパラメーター。

次のコードスニペットは、設定をログに記録する方法を示しています。

config = {"batch_size" : 32 , ... }

wandb. init(... , config= config)

Run の設定を更新する

設定を更新するには、run.config.update を使用します。パラメーターが辞書の定義後に取得される場合に、設定辞書を更新すると便利です。たとえば、モデルのインスタンス化後にモデルのパラメーターを追加する場合があります。

run. config. update({"model_parameters" : 3500 })

設定ファイルの定義方法の詳細については、実験の設定 を参照してください。

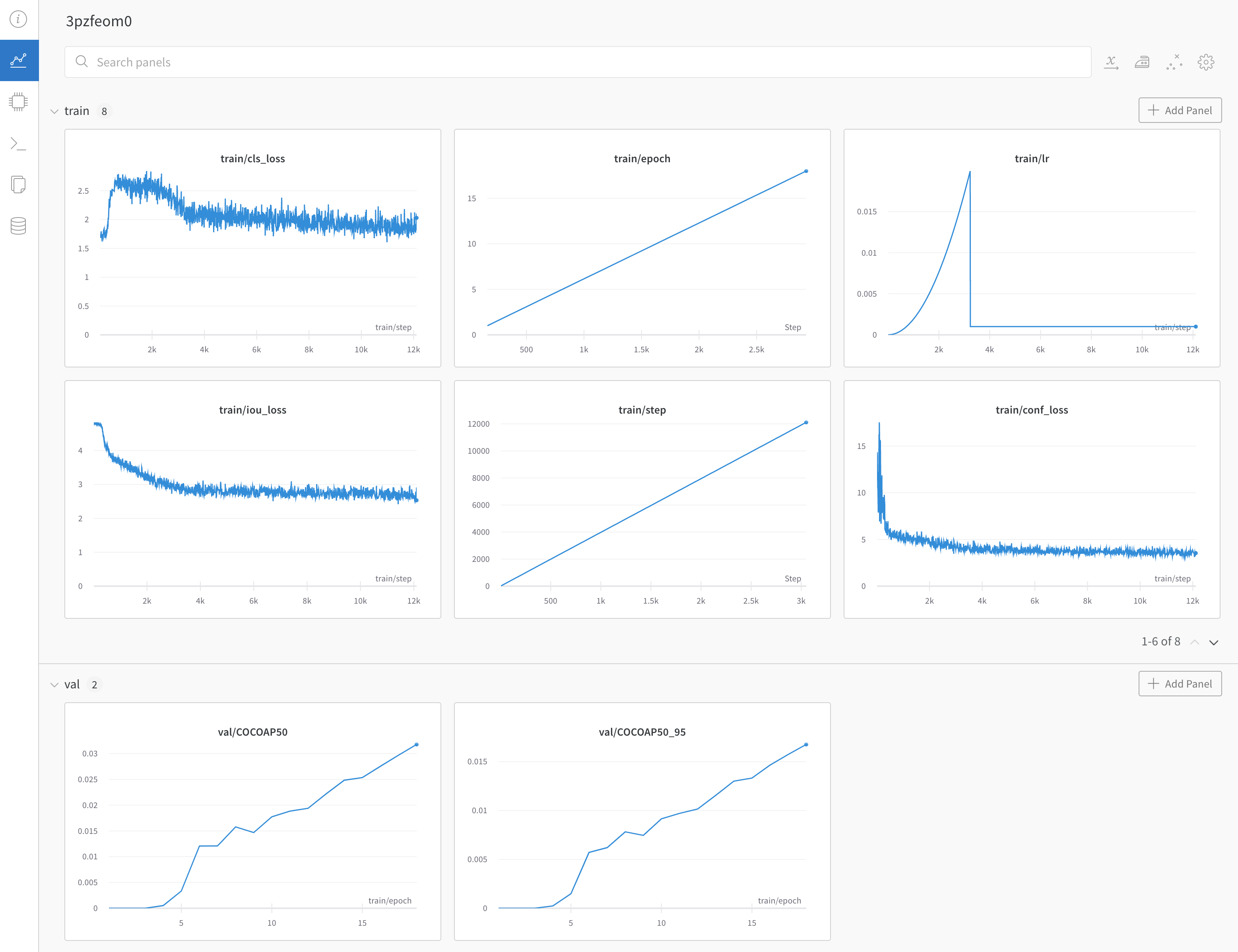

W&B にログを記録する

メトリクス を記録する

キーの値が メトリクス の名前である辞書を作成します。この辞書オブジェクトをrun.log

for epoch in range(NUM_EPOCHS):

for input, ground_truth in data:

prediction = model(input)

loss = loss_fn(prediction, ground_truth)

metrics = { "loss" : loss }

run. log(metrics)

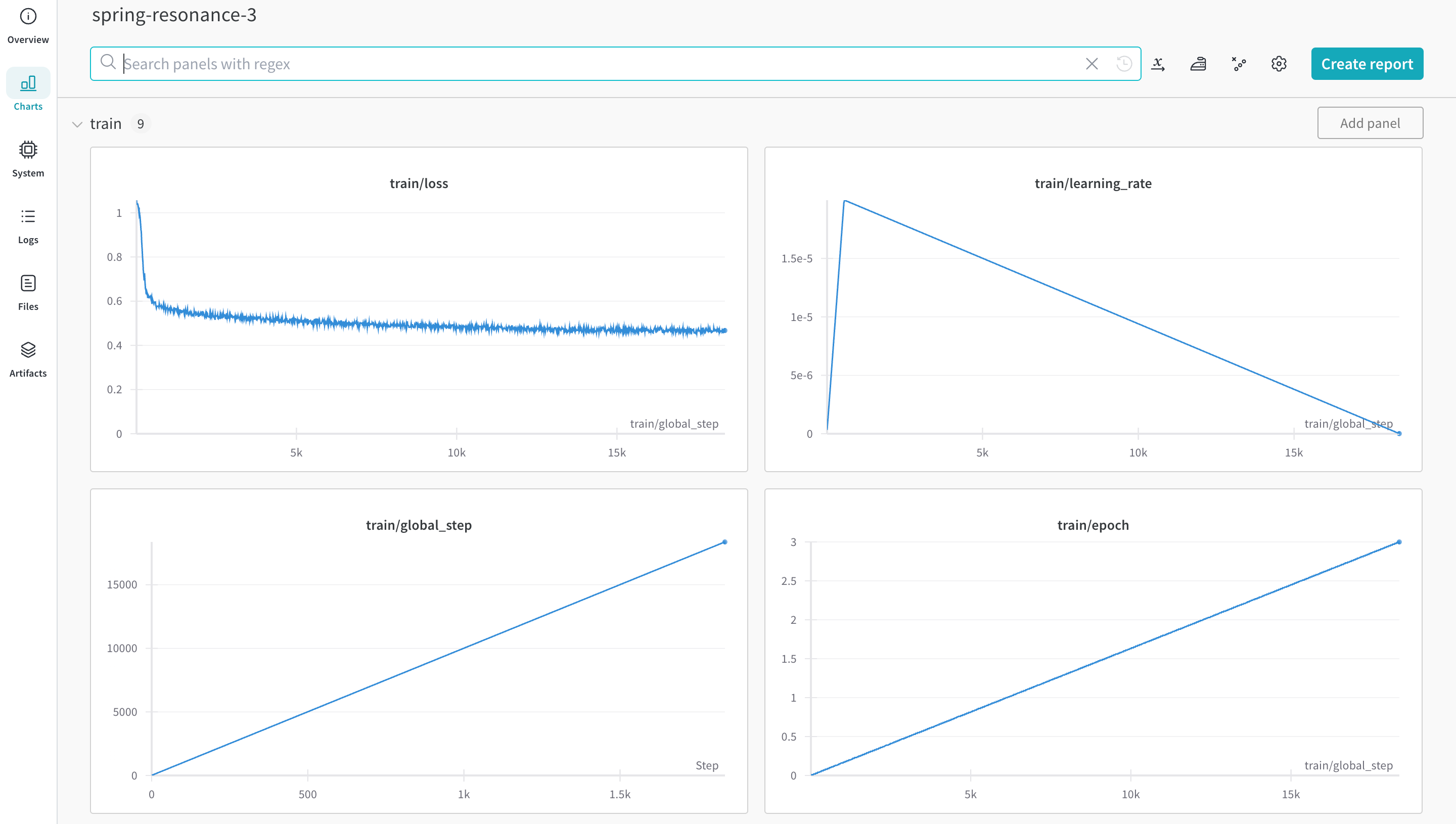

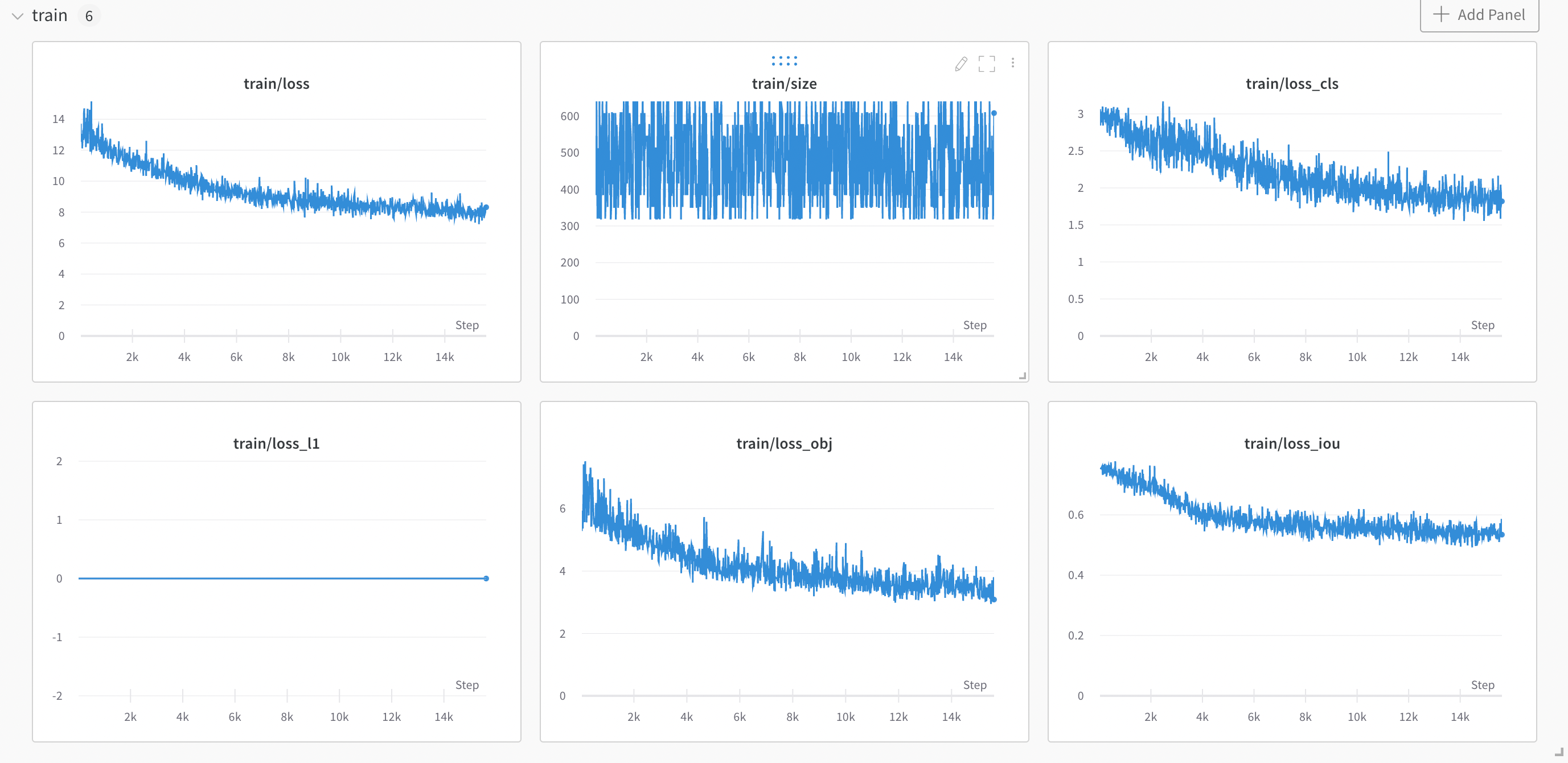

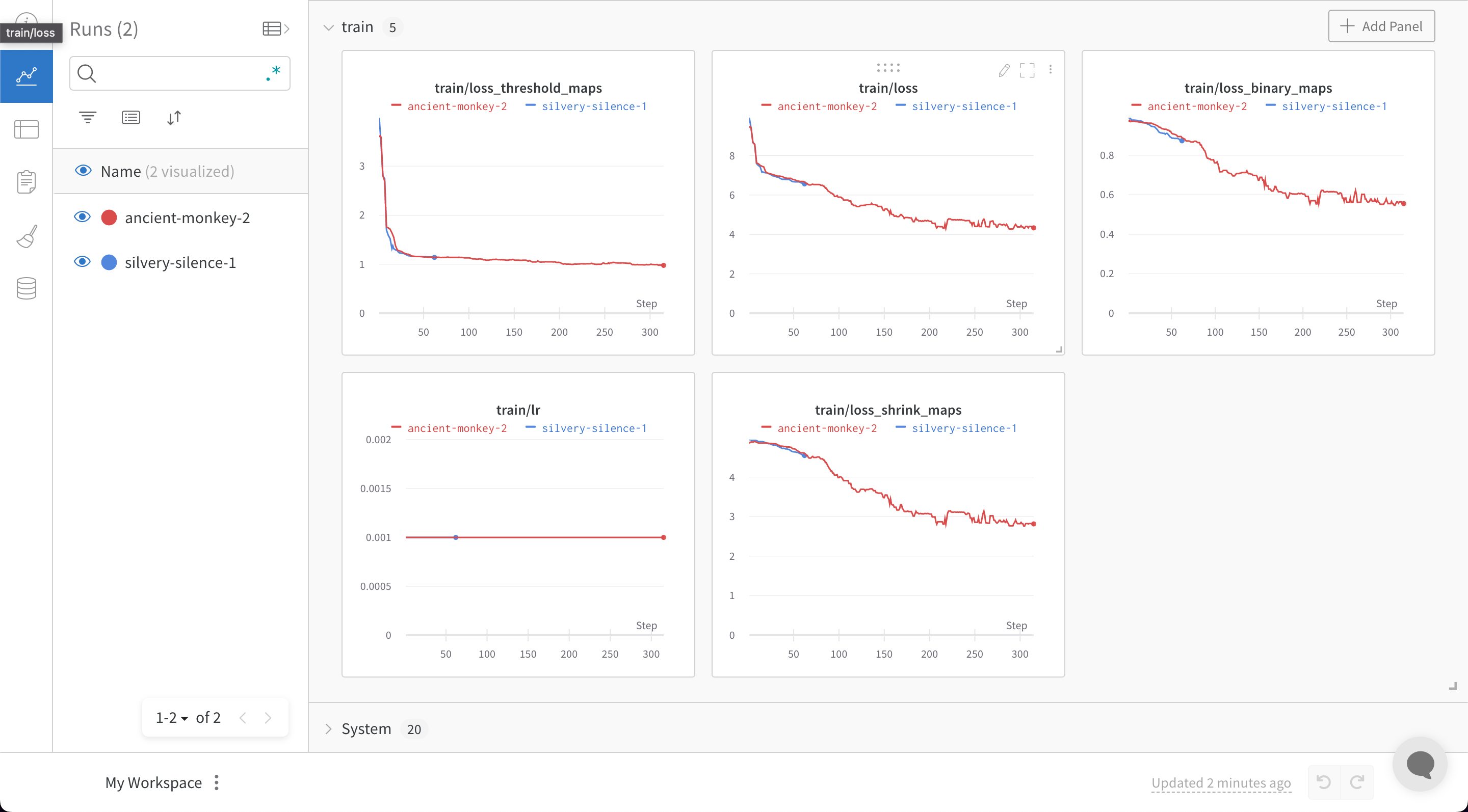

メトリクス がたくさんある場合は、train/... や val/... などの メトリクス 名にプレフィックスを使用することで、UI で自動的にグループ化できます。これにより、トレーニングと検証の メトリクス 、または分離したいその他の メトリクス タイプ用に、W&B Workspace に個別のセクションが作成されます。

metrics = {

"train/loss" : 0.4 ,

"train/learning_rate" : 0.4 ,

"val/loss" : 0.5 ,

"val/accuracy" : 0.7

}

run. log(metrics)

run.log の詳細を見る

X軸のずれを防ぐ

同じトレーニングステップに対して run.log を複数回呼び出すと、wandb SDK は run.log を呼び出すたびに内部ステップカウンターをインクリメントします。このカウンターは、トレーニングループのトレーニングステップと一致しない場合があります。

この状況を回避するには、run.define_metric で X軸ステップを明示的に定義します。wandb.init を呼び出した直後に1回定義します。

with wandb. init(... ) as run:

run. define_metric("*" , step_metric= "global_step" )

グロブパターン * は、すべての メトリクス がチャートで global_step を X軸として使用することを意味します。特定の メトリクス のみを global_step に対してログに記録する場合は、代わりにそれらを指定できます。

run. define_metric("train/loss" , step_metric= "global_step" )

次に、run.log を呼び出すたびに、 メトリクス 、step メトリクス 、および global_step をログに記録します。

for step, (input, ground_truth) in enumerate(data):

...

run. log({"global_step" : step, "train/loss" : 0.1 })

run. log({"global_step" : step, "eval/loss" : 0.2 })

たとえば、検証ループ中に「global_step」が利用できないなど、独立したステップ変数にアクセスできない場合、「global_step」の以前にログに記録された値が wandb によって自動的に使用されます。この場合、メトリクス に必要なときに定義されるように、 メトリクス の初期値をログに記録してください。

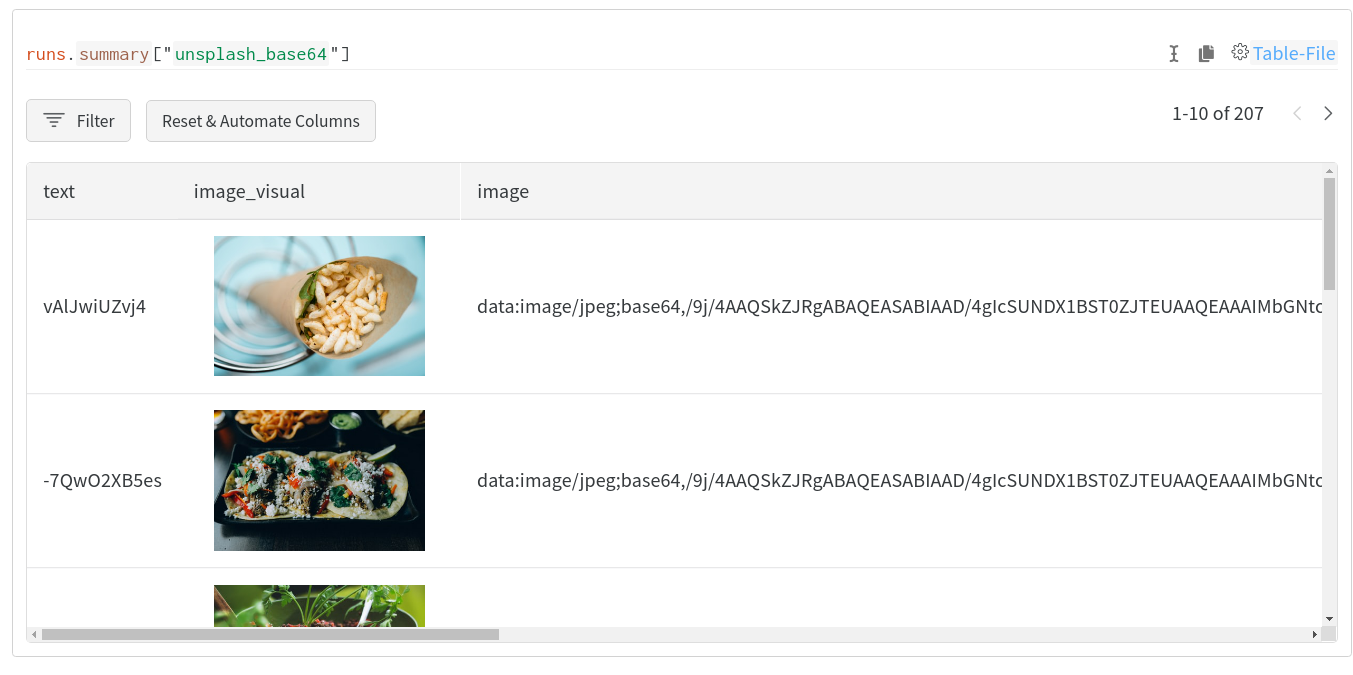

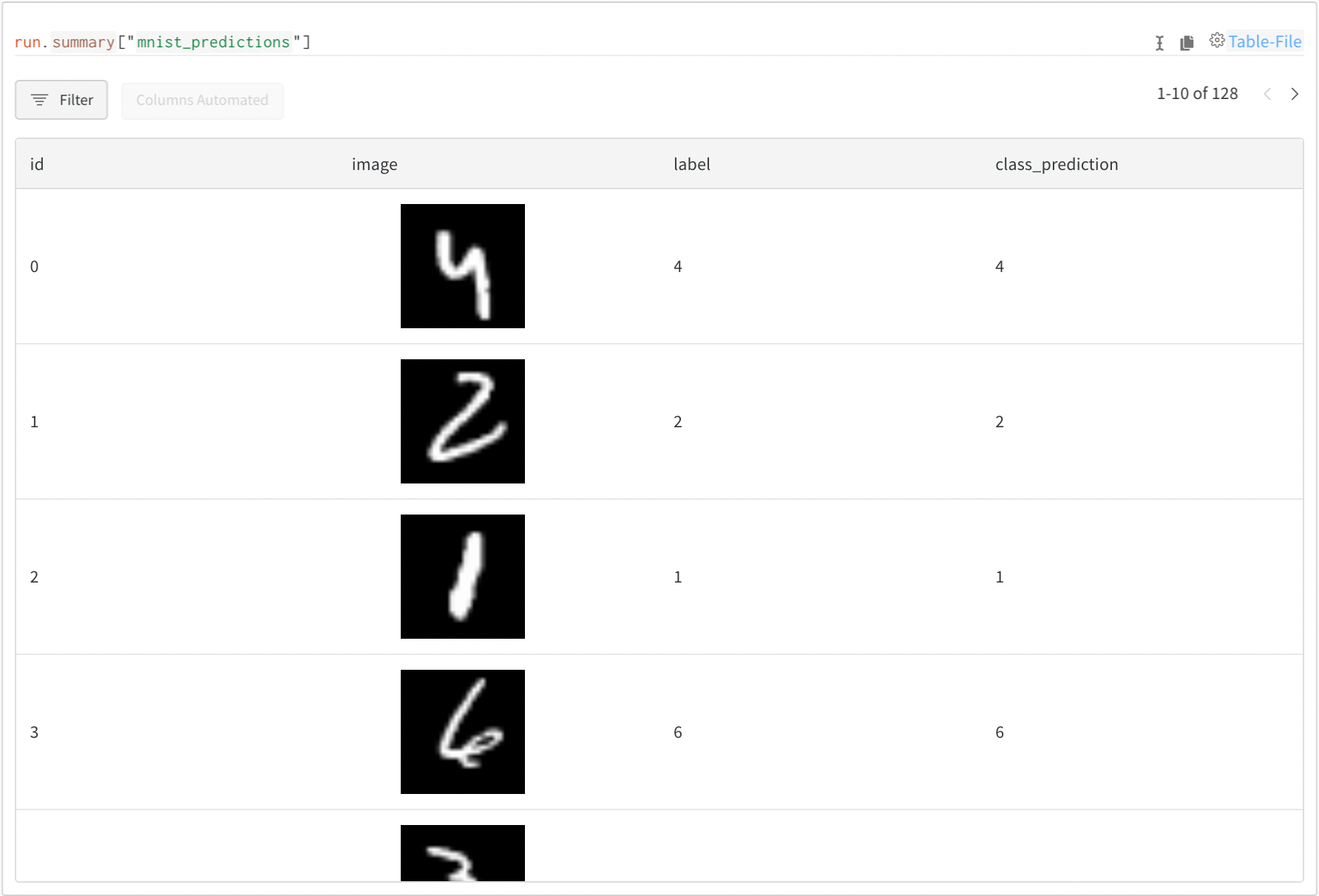

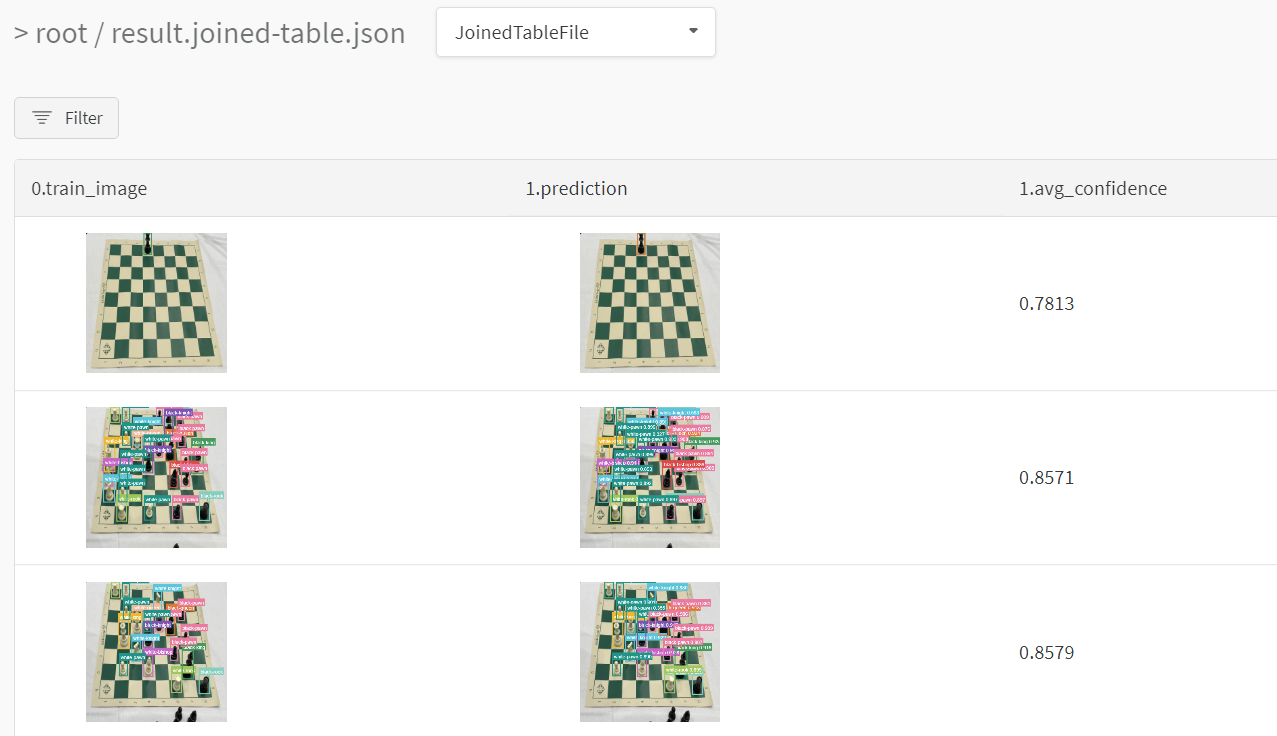

画像、テーブル、音声などをログに記録する

メトリクス に加えて、プロット、ヒストグラム、テーブル、テキスト、および画像、ビデオ、オーディオ、3D などのメディアをログに記録できます。

データをログに記録する際の考慮事項は次のとおりです。

メトリクス をログに記録する頻度はどのくらいですか? オプションにする必要がありますか?

視覚化に役立つデータの種類は何ですか?

画像の場合は、サンプル予測、セグメンテーションマスクなどをログに記録して、時間の経過に伴う変化を確認できます。

テキストの場合は、サンプル予測のテーブルをログに記録して、後で調べることができます。

メディア、オブジェクト、プロットなどのログ記録の詳細 をご覧ください。

分散トレーニング

分散環境をサポートするフレームワークの場合は、次のいずれかの ワークフロー を採用できます。

どの プロセス が「メイン」 プロセス であるかを検出し、そこで wandb のみを使用します。他の プロセス からの必要なデータは、最初にメイン プロセス にルーティングする必要があります(この ワークフロー を推奨します)。

すべての プロセス で wandb を呼び出し、すべてに同じ一意の group 名を付けて自動的にグループ化します。

詳細については、分散トレーニング実験のログを記録する を参照してください。

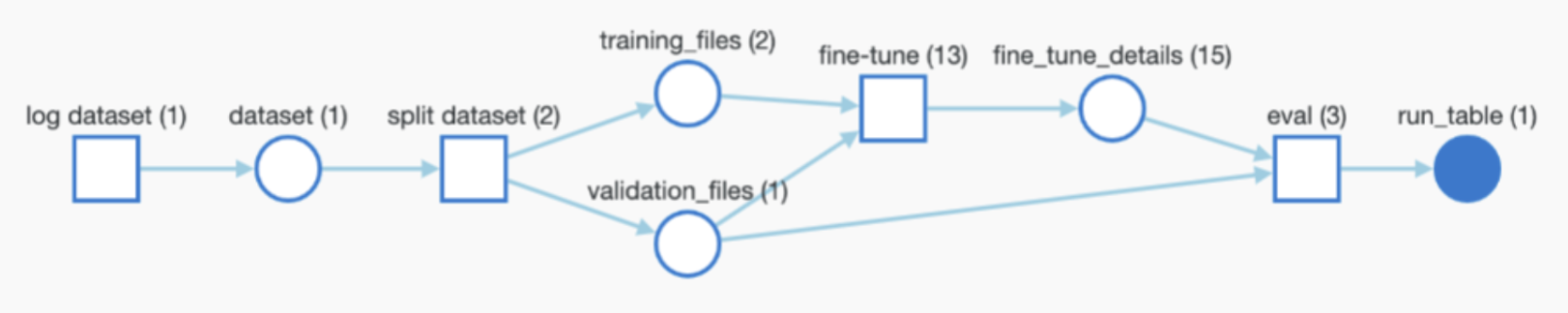

モデルチェックポイントなどを記録する

フレームワークがモデルまたはデータセットを使用または生成する場合は、それらをログに記録して完全なトレーサビリティを実現し、W&B Artifacts を介して パイプライン 全体を wandb で自動的に監視できます。

Artifacts を使用する場合、ユーザーに次のことを定義させることは役立つかもしれませんが、必須ではありません。

モデルチェックポイントまたはデータセットをログに記録する機能(オプションにする場合)。

入力として使用される Artifact のパス/参照(ある場合)。たとえば、user/project/artifact です。

Artifacts をログに記録する頻度。

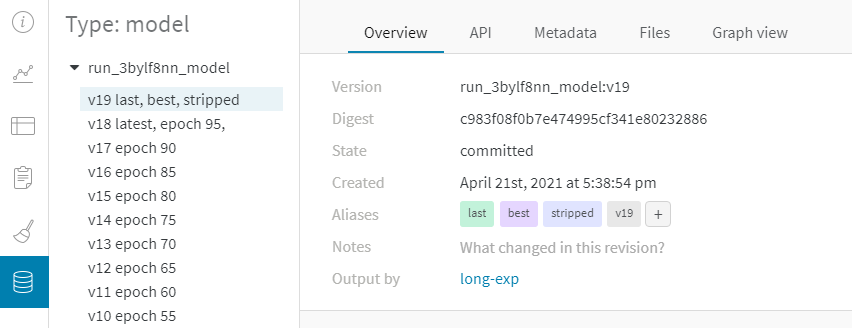

モデルチェックポイント を記録する

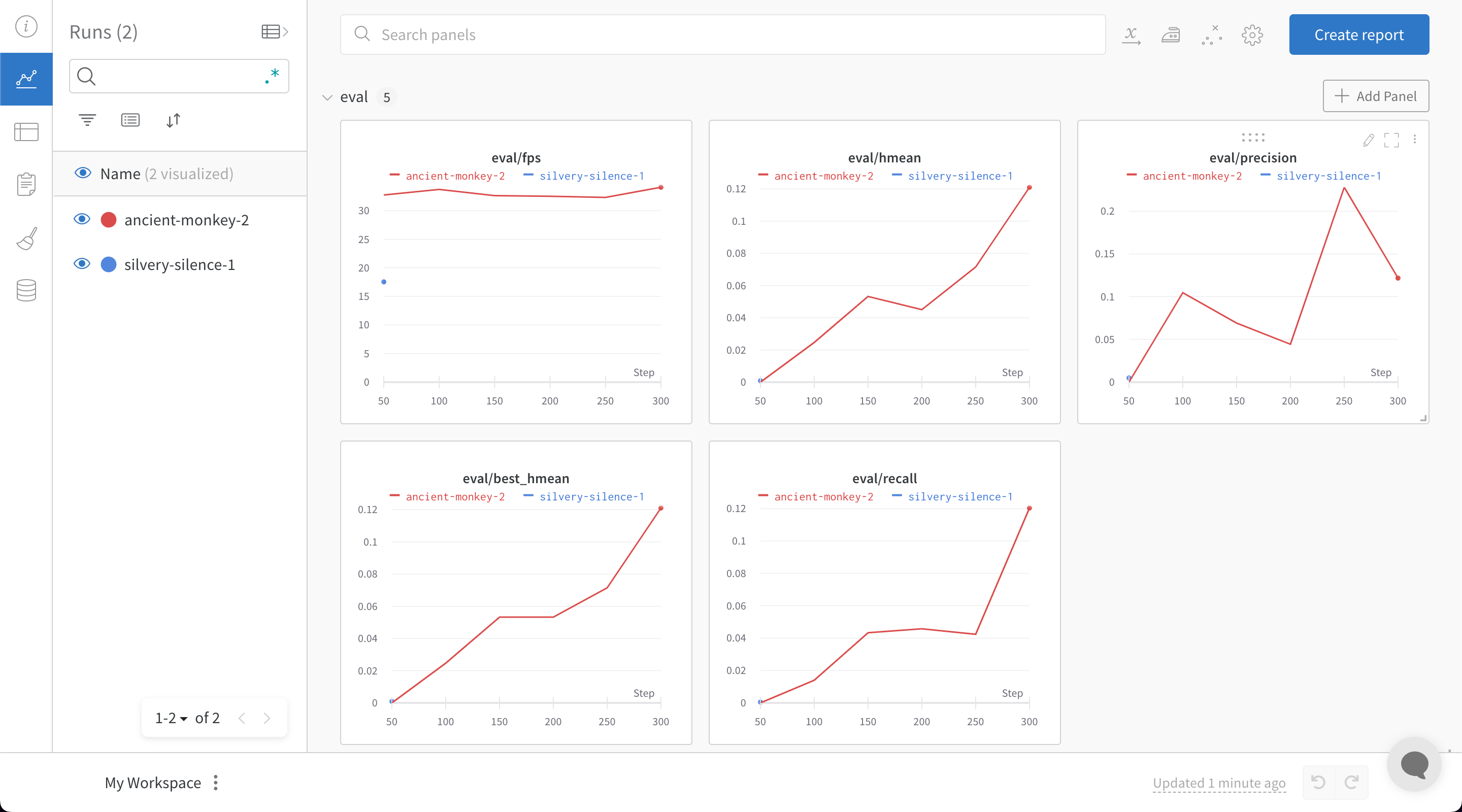

モデルチェックポイント を W&B にログを記録できます。一意の wandb Run ID を利用して出力 モデルチェックポイント に名前を付け、Run 間で区別すると便利です。また、有用な メタデータ を追加することもできます。さらに、以下に示すように、各モデルに エイリアス を追加することもできます。

metadata = {"eval/accuracy" : 0.8 , "train/steps" : 800 }

artifact = wandb. Artifact(

name= f "model- { run. id} " ,

metadata= metadata,

type= "model"

)

artifact. add_dir("output_model" ) # local directory where the model weights are stored

aliases = ["best" , "epoch_10" ]

run. log_artifact(artifact, aliases= aliases)

カスタム エイリアス の作成方法については、カスタム エイリアス を作成する を参照してください。

出力 Artifacts は、任意の頻度(たとえば、エポックごと、500ステップごとなど)でログに記録でき、自動的に バージョン 管理されます。

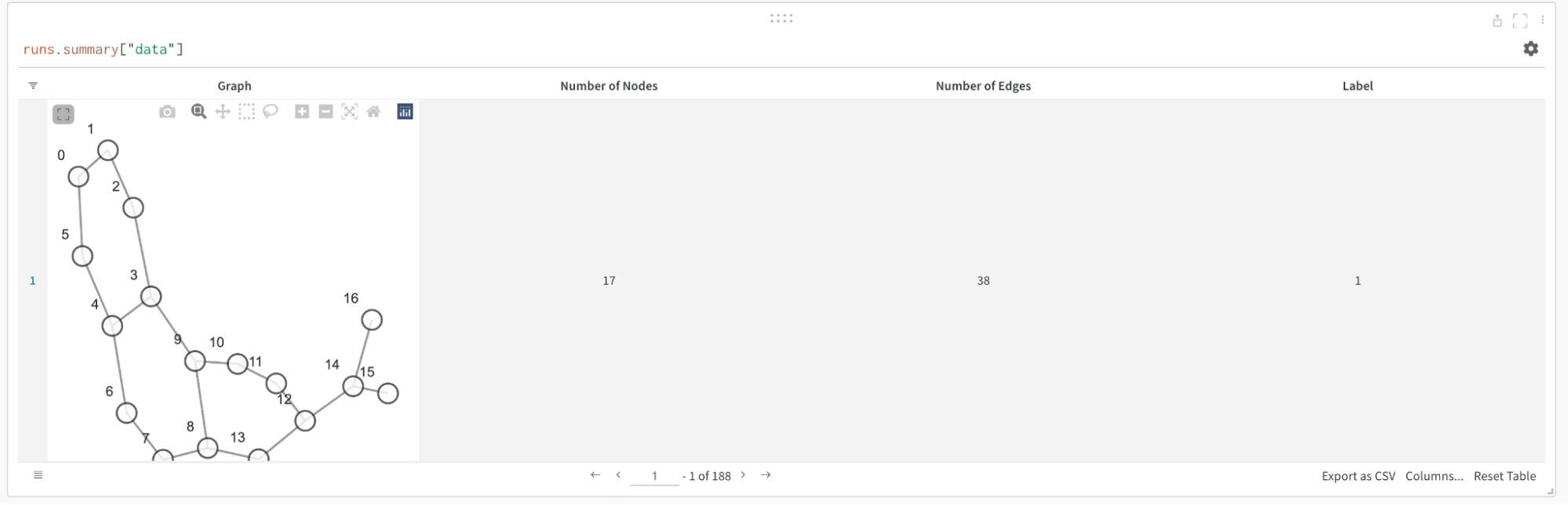

学習済み モデル または データセット をログに記録および追跡する

学習済み モデル や データセット など、トレーニングへの入力として使用される Artifacts をログに記録できます。次のスニペットは、Artifact をログに記録し、上記のグラフに示すように、実行中の Run に入力として追加する方法を示しています。

artifact_input_data = wandb. Artifact(name= "flowers" , type= "dataset" )

artifact_input_data. add_file("flowers.npy" )

run. use_artifact(artifact_input_data)

Artifact をダウンロードする

Artifact(データセット、モデルなど)を再利用すると、wandb はローカルにコピーをダウンロード(およびキャッシュ)します。

artifact = run. use_artifact("user/project/artifact:latest" )

local_path = artifact. download("./tmp" )

Artifacts は W&B の Artifacts セクションにあり、自動的に生成される エイリアス (latest、v2、v3)またはログ記録時に手動で生成される エイリアス (best_accuracy など)で参照できます。

(wandb.init を介して)wandb Run を作成せずに Artifact をダウンロードするには(たとえば、分散環境または単純な推論の場合)、代わりにwandb API で Artifact を参照できます。

artifact = wandb. Api(). artifact("user/project/artifact:latest" )

local_path = artifact. download()

詳細については、Artifacts のダウンロードと使用 を参照してください。

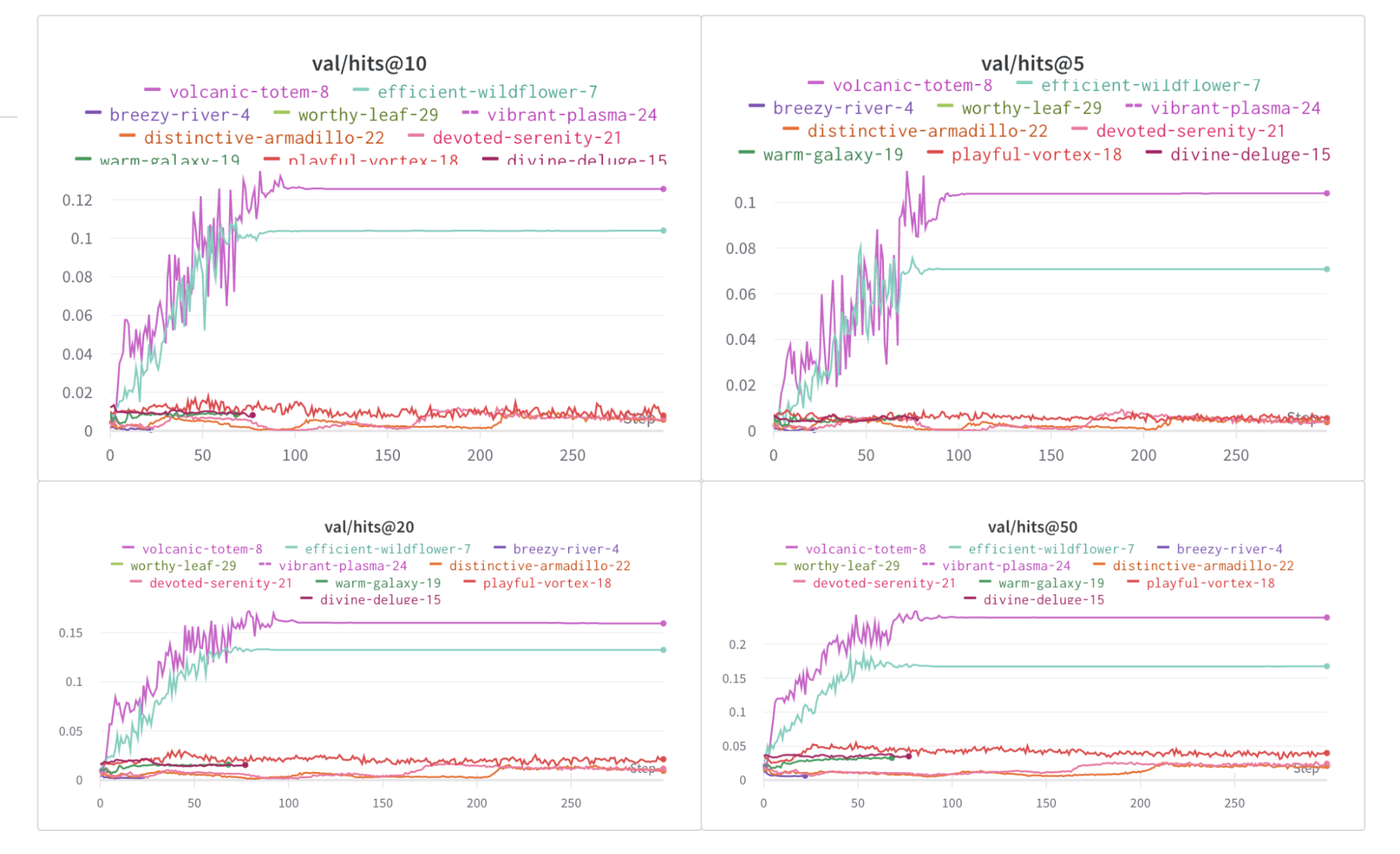

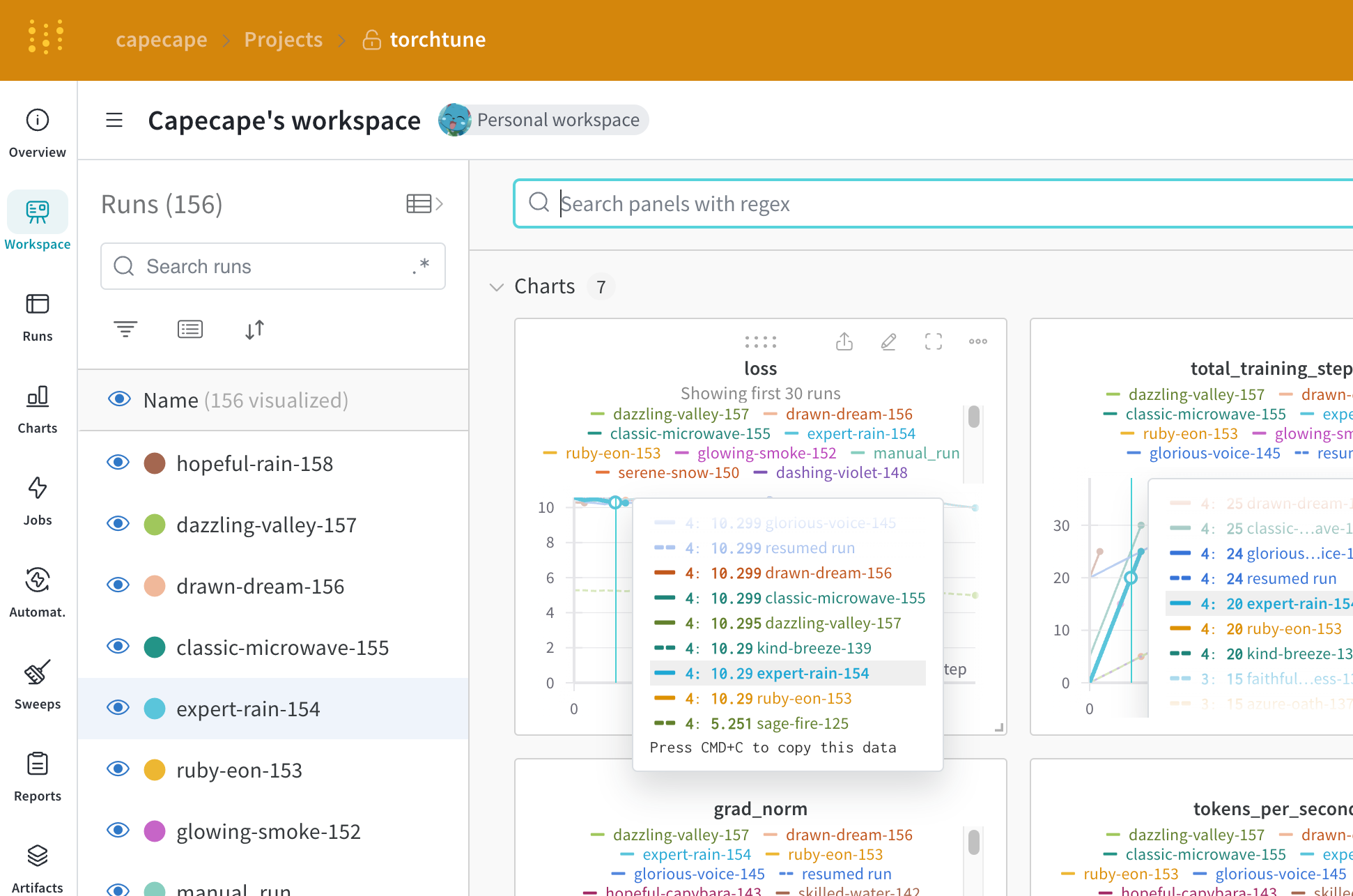

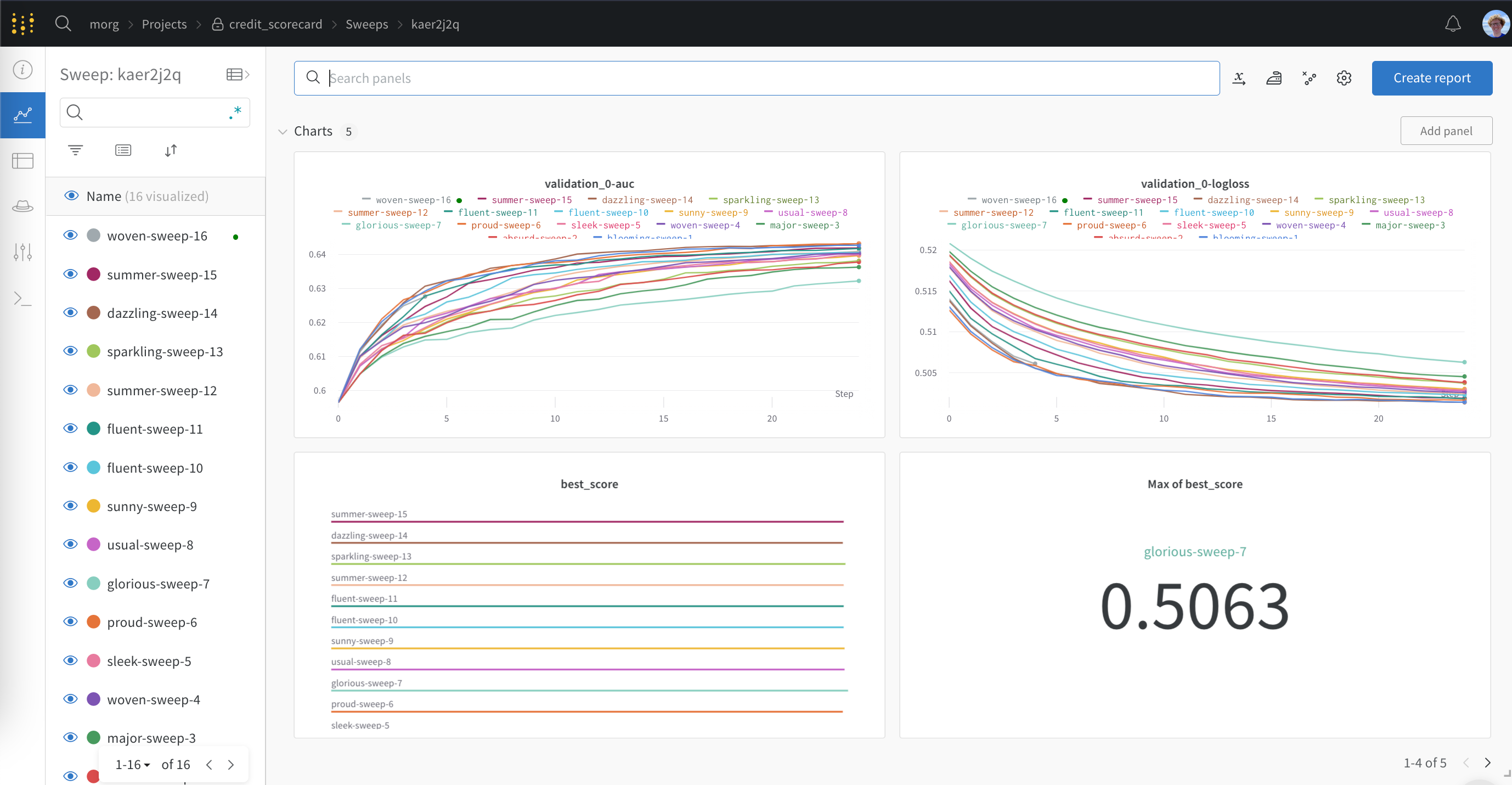

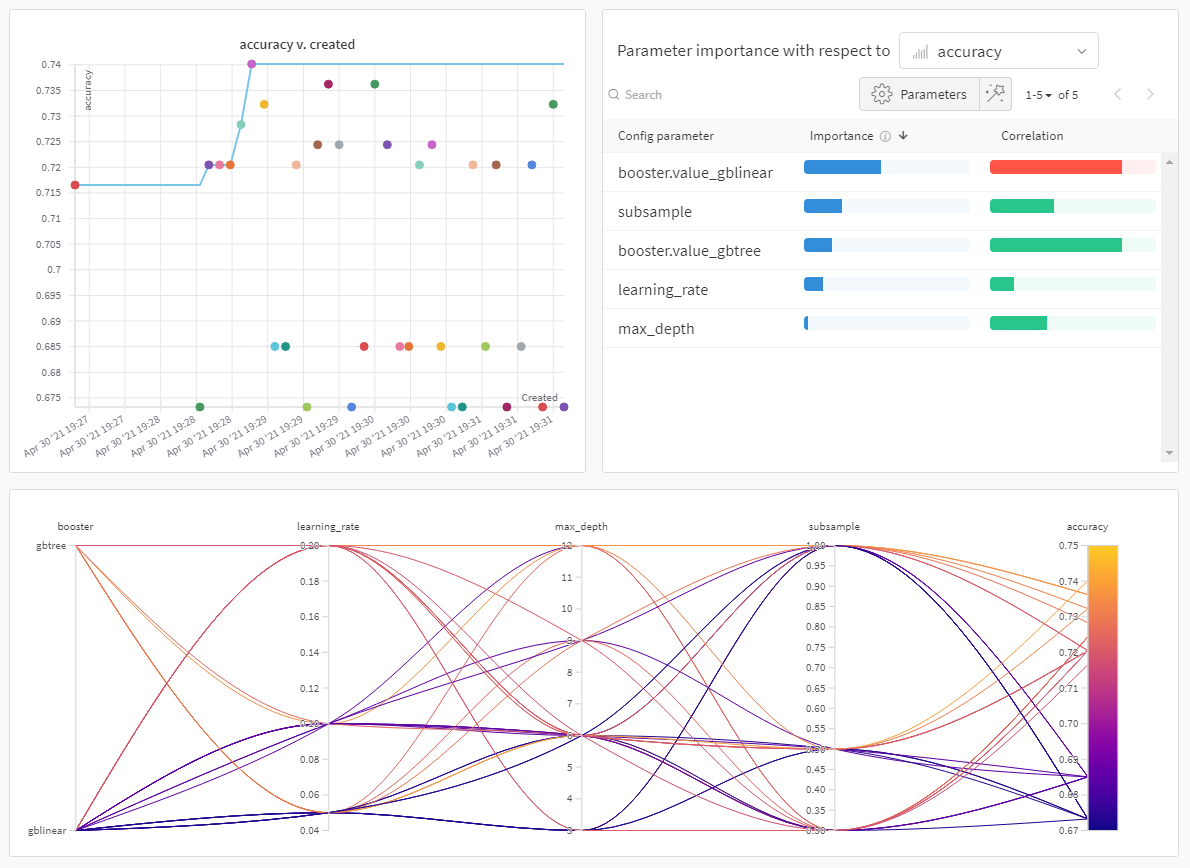

ハイパーパラメーター を チューニング する

ライブラリで W&B ハイパーパラメーター チューニング 、W&B Sweeps を活用したい場合は、ライブラリに追加することもできます。

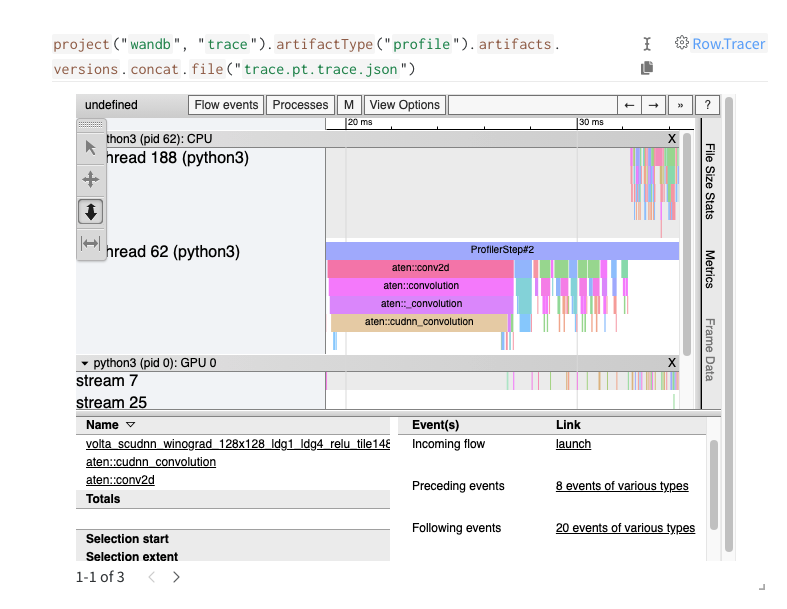

高度な インテグレーション

高度な W&B インテグレーション がどのようなものかについては、次の インテグレーション を参照してください。ほとんどの インテグレーション はこれほど複雑ではありません。

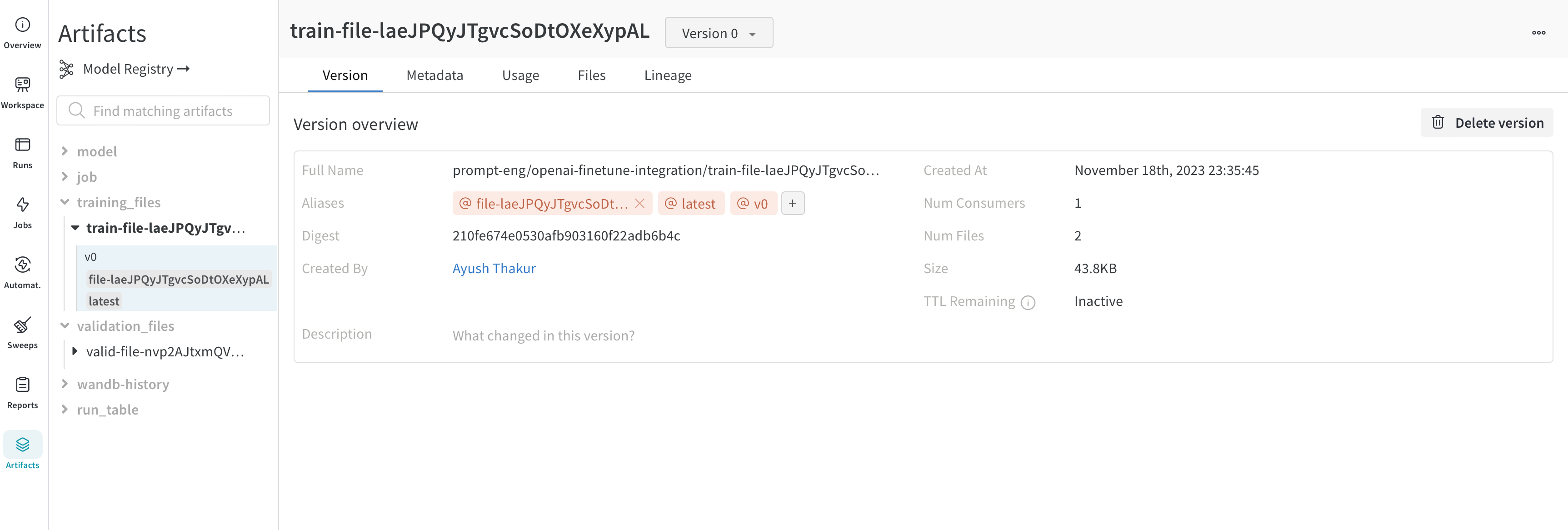

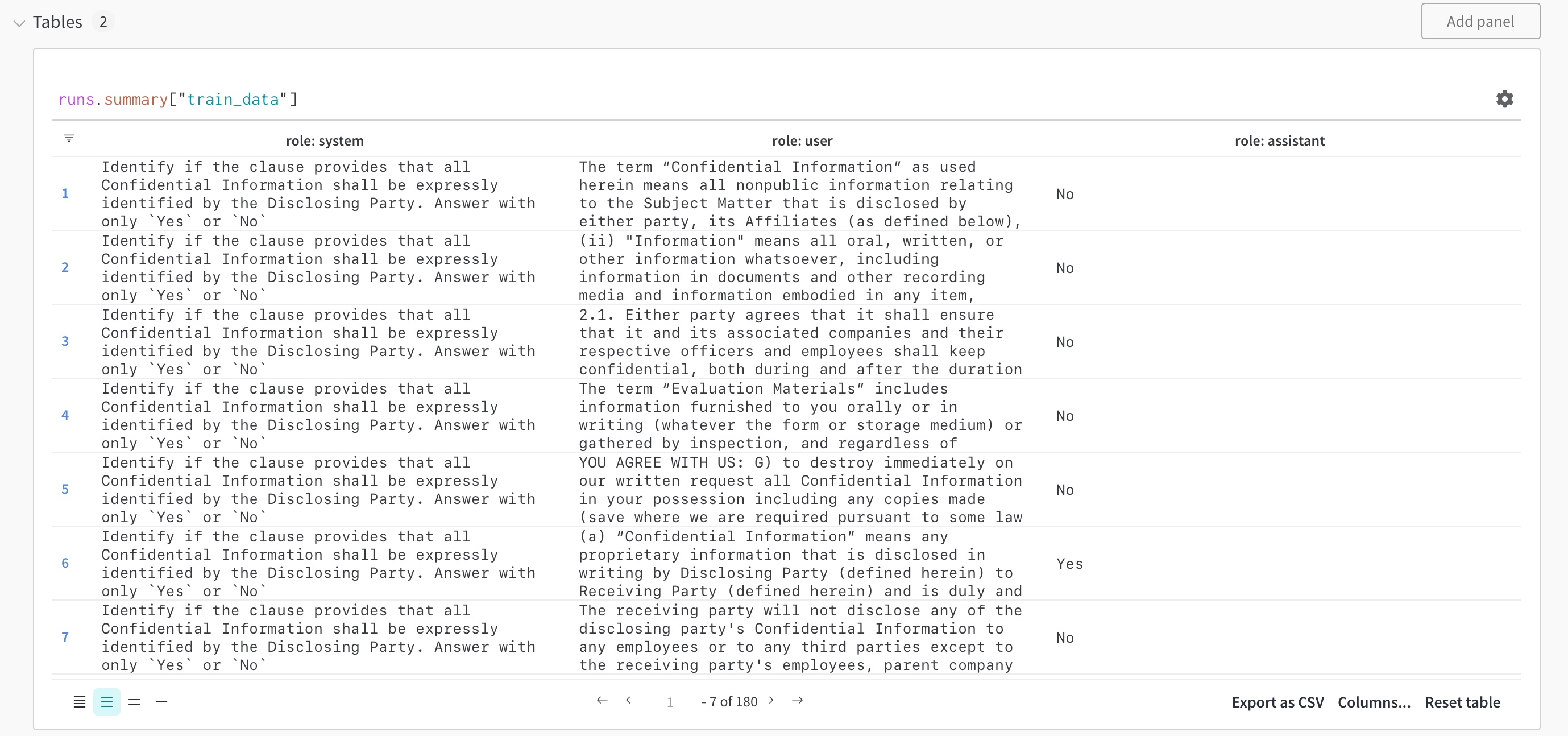

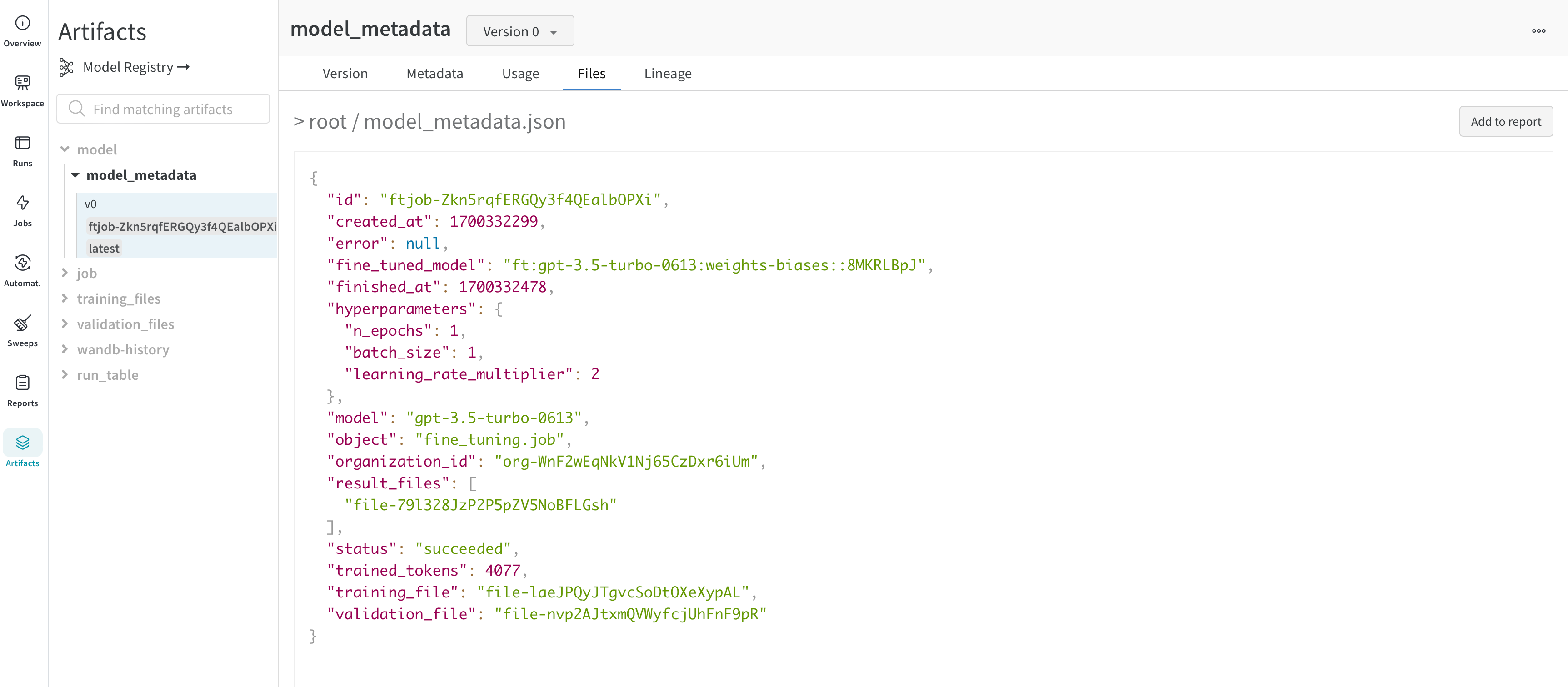

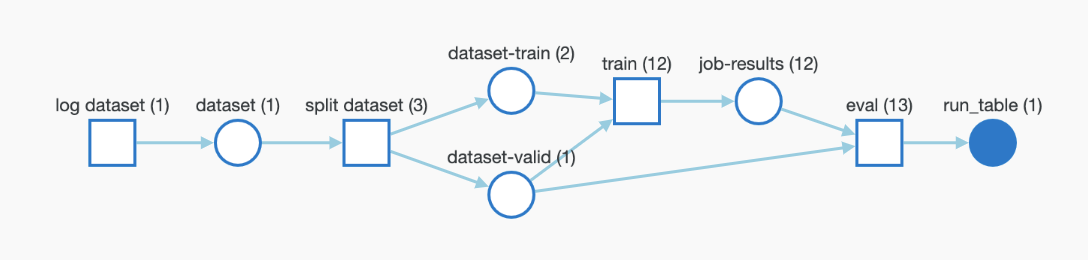

2 - Azure OpenAI Fine-Tuning

W&B を使用して Azure OpenAI モデルを ファインチューン する方法。

イントロダクション

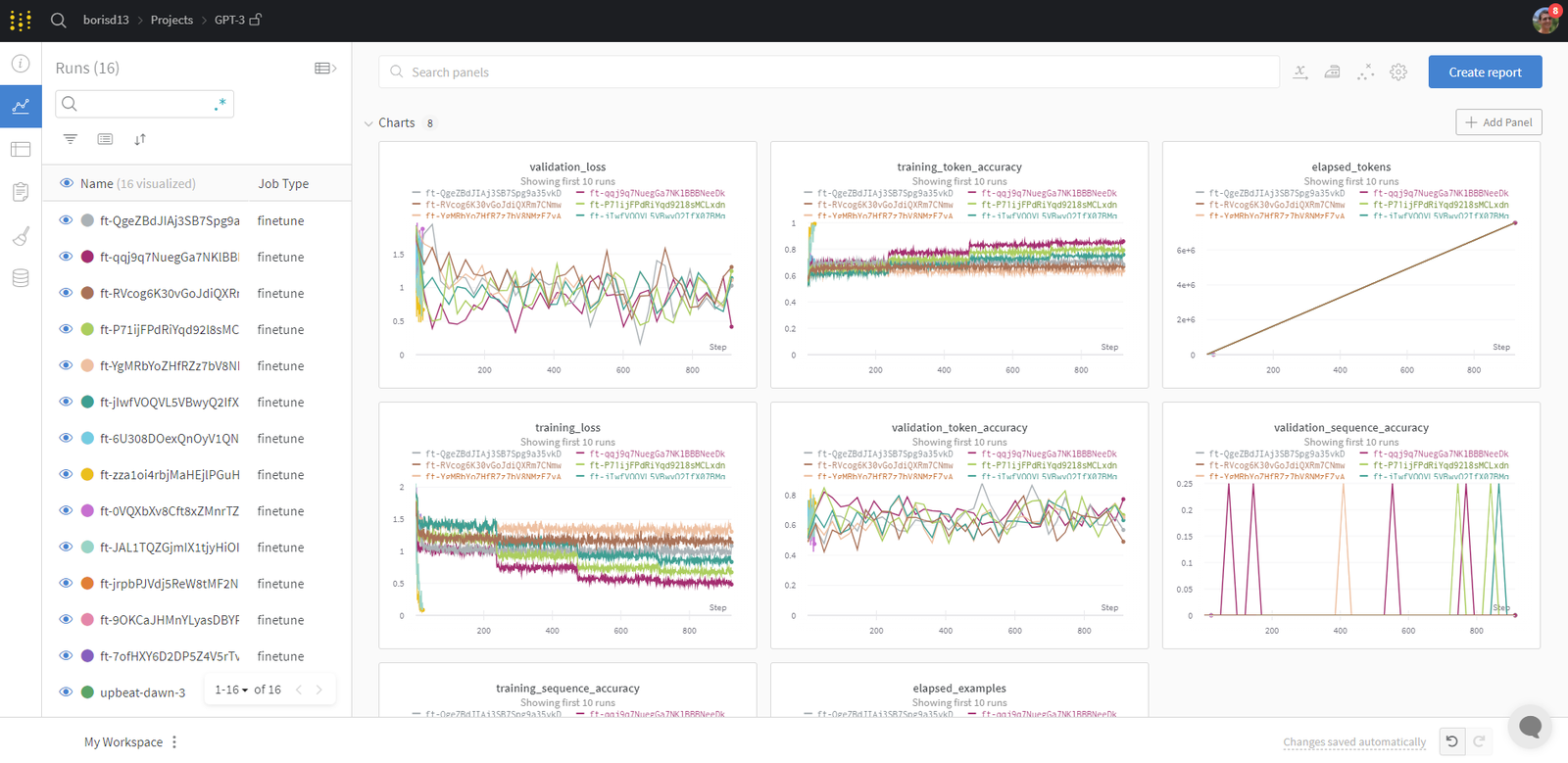

Microsoft Azure 上で GPT-3.5 または GPT-4 モデルをファインチューニングする際、W&B を使用することで、メトリクスの自動的なキャプチャや W&B の 実験管理 および評価 ツールによる体系的な評価が促進され、モデルのパフォーマンスを追跡、分析、改善できます。

前提条件

ワークフローの概要

1. ファインチューニングのセットアップ

Azure OpenAI の要件に従ってトレーニングデータを準備します。

Azure OpenAI でファインチューニングジョブを設定します。

W&B は、ファインチューニングプロセスを自動的に追跡し、メトリクスとハイパーパラメータをログに記録します。

2. 実験管理

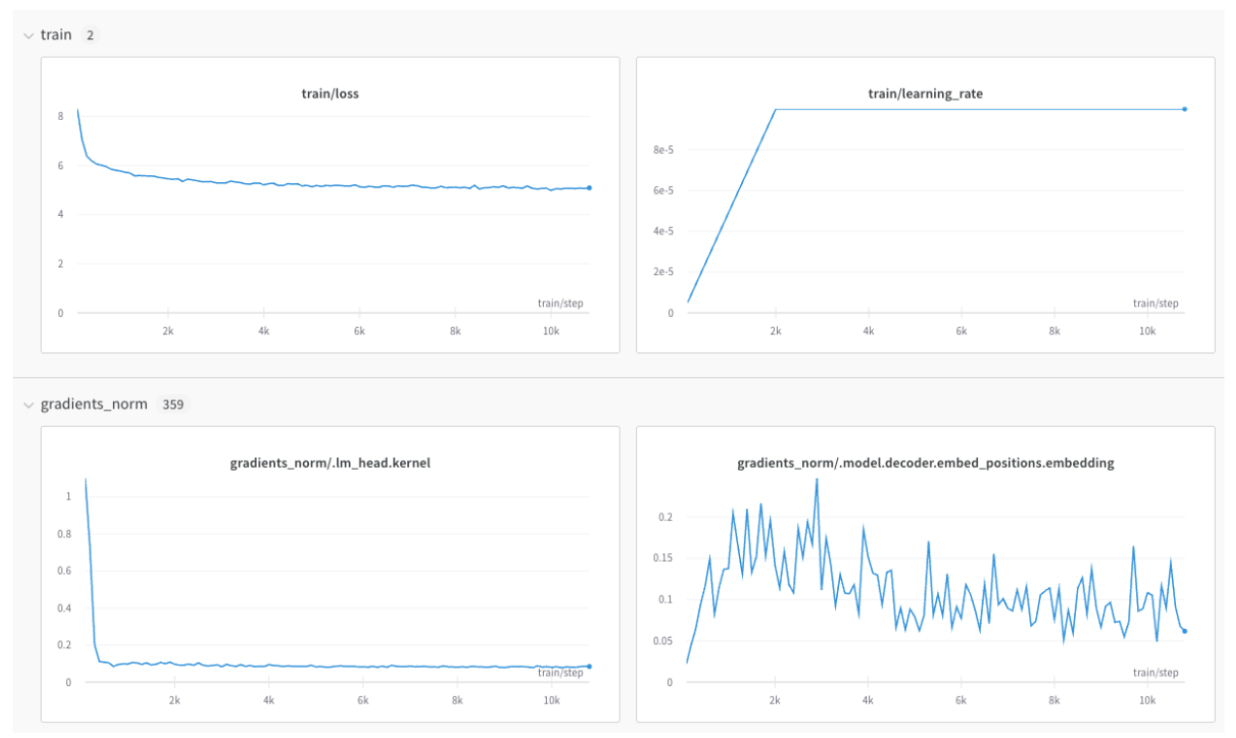

ファインチューニング中、W&B は以下をキャプチャします。

トレーニング および 検証メトリクス

モデル ハイパーパラメータ

リソース使用率

トレーニング Artifacts

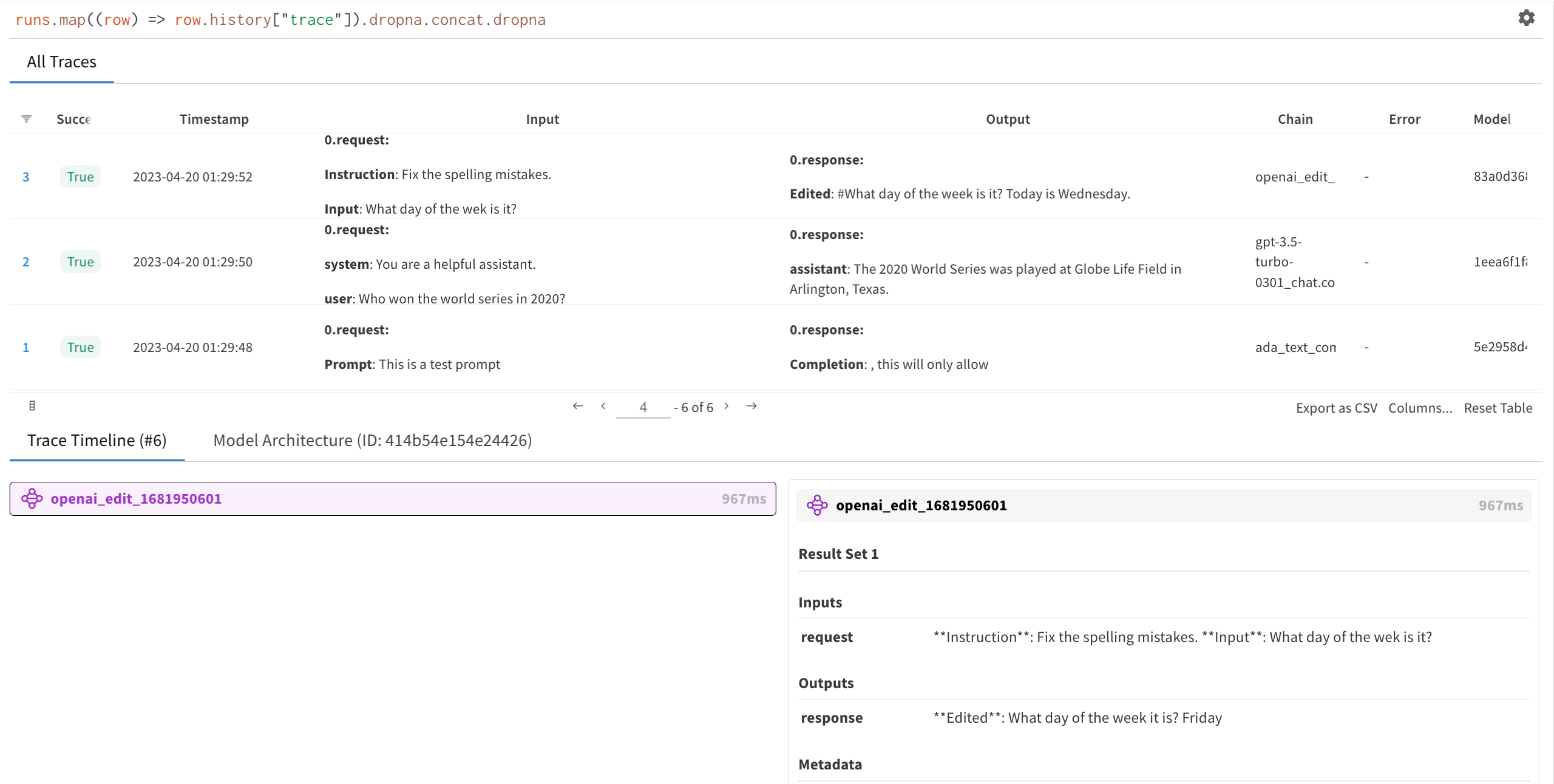

3. モデルの評価

ファインチューニング後、W&B Weave を使用して以下を行います。

参照データセットに対するモデル出力を評価します

異なるファインチューニング Runs 全体のパフォーマンスを比較します

特定のテストケースにおけるモデルの 振る舞い を分析します

データに基づいたモデル選択の意思決定を行います

実際の例

追加リソース

3 - Catalyst

Pytorch のフレームワークである Catalyst に W&B を統合する方法。

Catalyst は、再現性 、迅速な実験 、およびコードベースの再利用に重点を置いたディープラーニング のR&D用 PyTorch フレームワーク で、新しいものを創造できます。

Catalyst には、 パラメータ 、 メトリクス 、画像、およびその他の Artifacts を ログ 記録するための W&B インテグレーション が含まれています。

Python と Hydra を使用した例を含む、インテグレーション のドキュメント を確認してください。

インタラクティブな例

Catalyst と W&B の インテグレーション の動作を確認するには、example colab を実行してください。

4 - Cohere fine-tuning

W&B を使用して Cohere モデル を ファインチューン する方法。

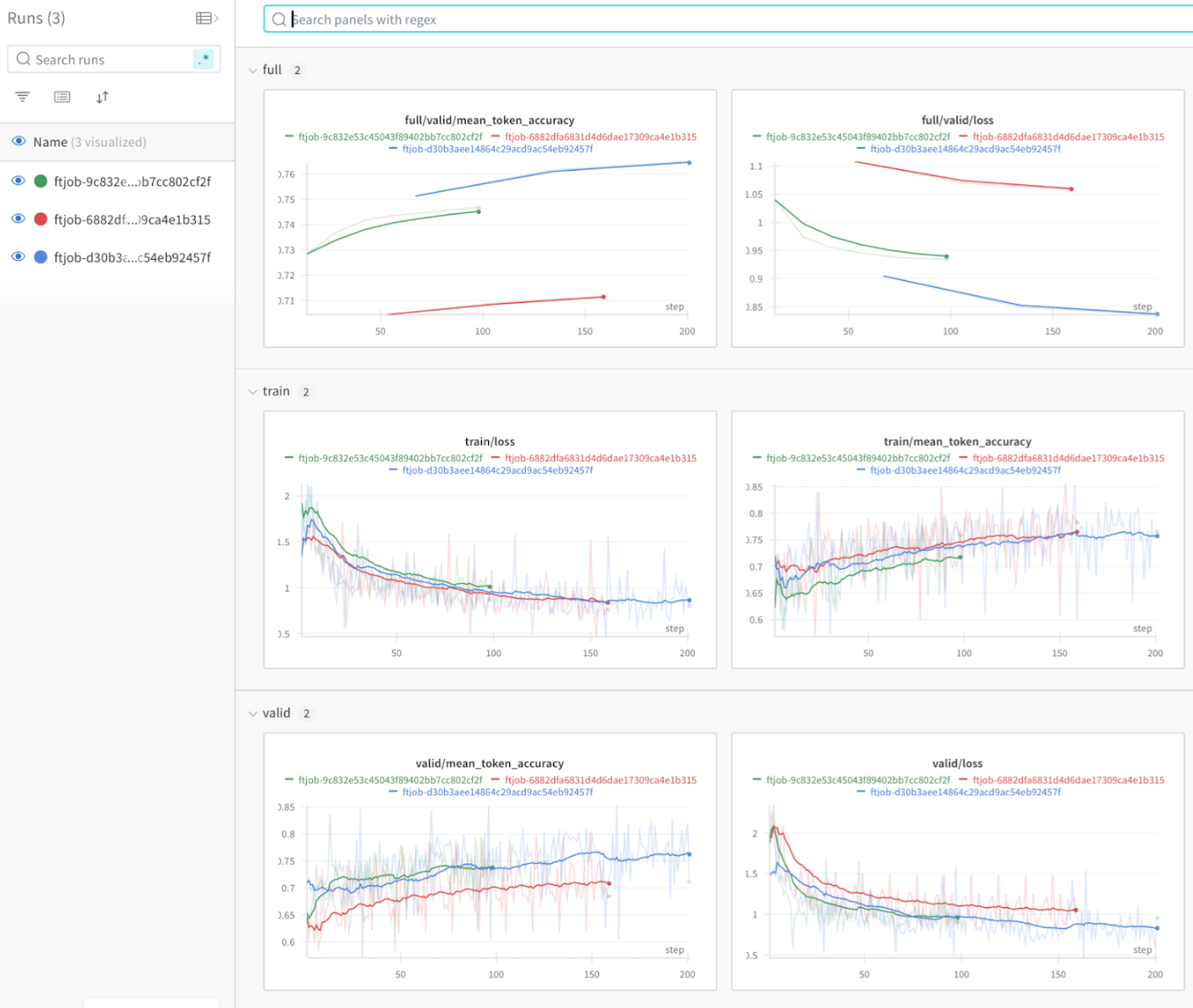

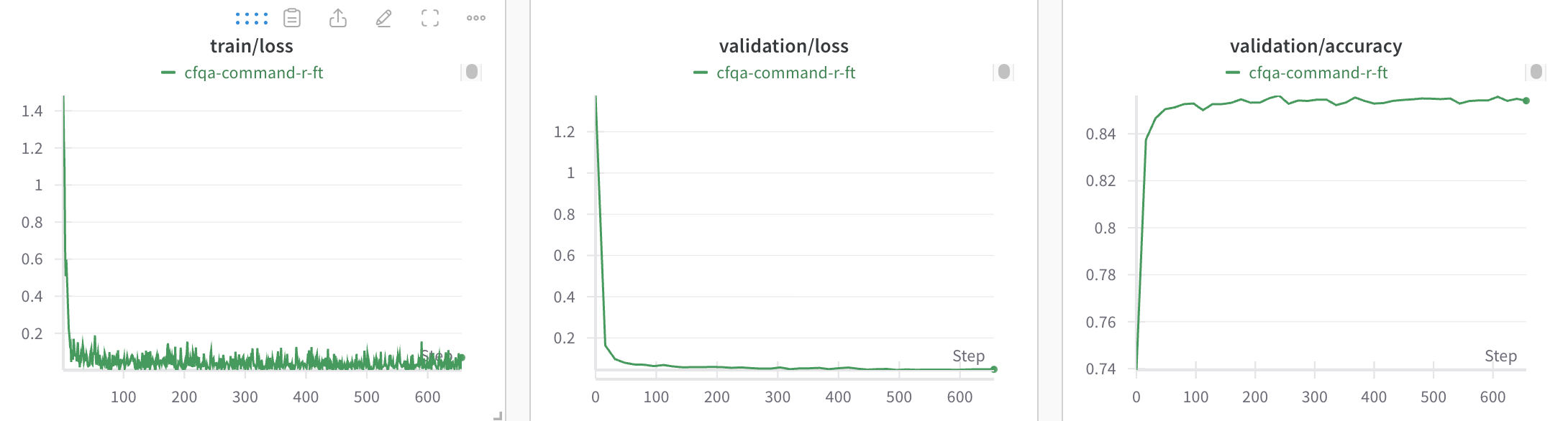

Weights & Biases を使用すると、Cohere モデルのファイン チューニング メトリクスと設定をログに記録して、モデルのパフォーマンスを分析および理解し、同僚と結果を共有できます。

この Cohere のガイド には、ファイン チューニング run を開始する方法の完全な例が記載されています。また、Cohere API ドキュメントはこちら にあります。

Cohere のファイン チューニング result をログに記録する

Cohere のファイン チューニング ログを W&B Workspace に追加するには:

W&B API キー、W&B entity、および project 名を使用して WandbConfig を作成します。W&B API キーは、https://wandb.ai/authorize で確認できます。

この設定を、モデル名、データセット、ハイパー パラメーターとともに FinetunedModel オブジェクトに渡して、ファイン チューニング run を開始します。

from cohere.finetuning import WandbConfig, FinetunedModel

# W&B の詳細を含む config を作成する

wandb_ft_config = WandbConfig(

api_key= "<wandb_api_key>" ,

entity= "my-entity" , # 提供された API キーに関連付けられている有効な entity である必要があります

project= "cohere-ft" ,

)

... # データセットとハイパー パラメーターを設定する

# cohere でファイン チューニング run を開始する

cmd_r_finetune = co. finetuning. create_finetuned_model(

request= FinetunedModel(

name= "command-r-ft" ,

settings= Settings(

base_model=...

dataset_id=...

hyperparameters=...

wandb= wandb_ft_config # ここに W&B config を渡す

),

),

)

作成した W&B project で、モデルのファイン チューニング トレーニング、検証メトリクス、およびハイパー パラメーターを表示します。

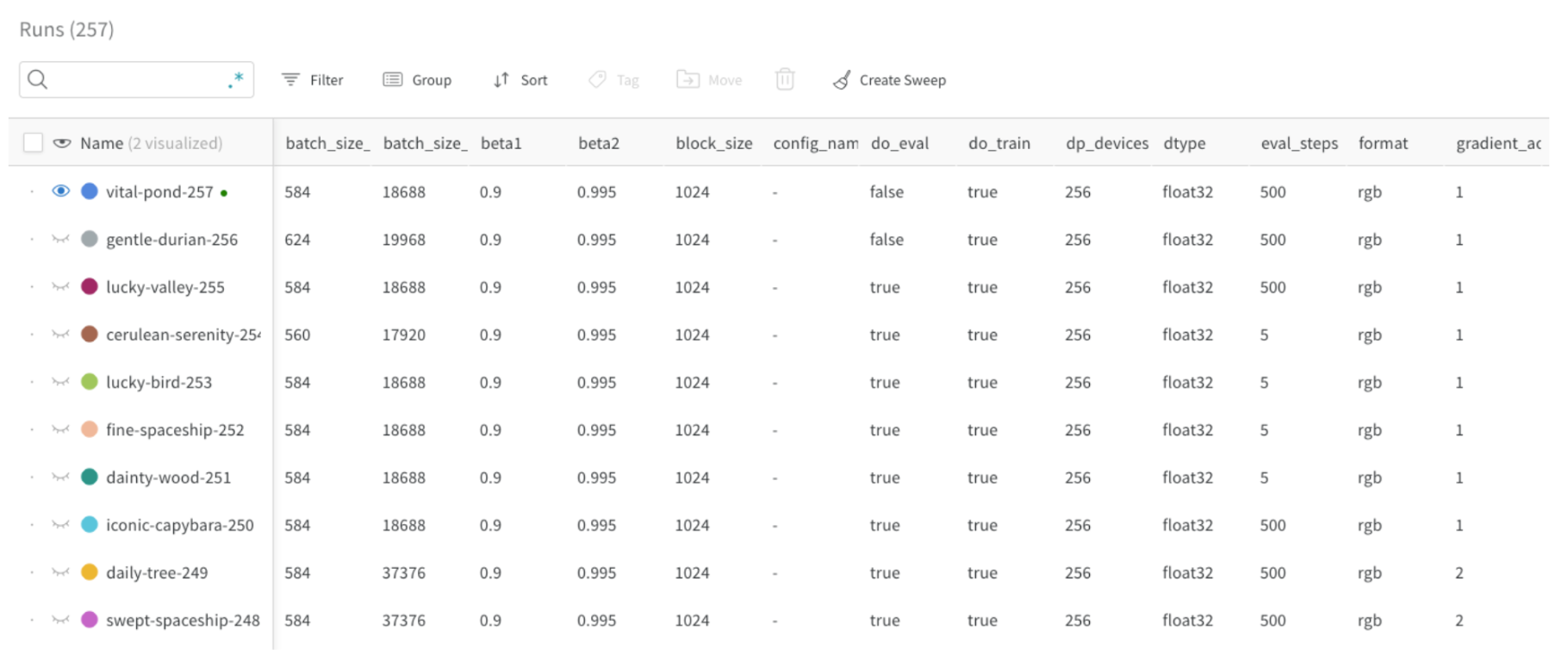

Runs を整理する

W&B の Runs は自動的に整理され、ジョブタイプ、ベース model、学習率、その他のハイパー パラメーターなどの任意の設定 parameter に基づいてフィルタリング/ソートできます。

さらに、Runs の名前を変更したり、メモを追加したり、タグを作成してグループ化したりできます。

リソース

5 - Databricks

W&B と Databricks を統合する方法。

W&B は、Databricks 環境で W&B Jupyter notebook のエクスペリエンスをカスタマイズすることにより、Databricks と統合されます。

Databricks の設定

クラスターに wandb をインストールする

クラスターの設定に移動し、クラスターを選択して、ライブラリ をクリックします。新規インストール をクリックし、PyPI を選択して、パッケージ wandb を追加します。

認証の設定

W&B アカウントを認証するには、notebook がクエリできる Databricks シークレットを追加します。

# databricks cli をインストールする

pip install databricks-cli

# databricks UI からトークンを生成する

databricks configure --token

# 次の 2 つのコマンドのいずれかを使用してスコープを作成します (Databricks でセキュリティ機能が有効になっているかどうかによって異なります)。

# セキュリティ アドオンを使用する場合

databricks secrets create-scope --scope wandb

# セキュリティ アドオンを使用しない場合

databricks secrets create-scope --scope wandb --initial-manage-principal users

# https://app.wandb.ai/authorize から api_key を追加します

databricks secrets put --scope wandb --key api_key

例

簡単な例

import os

import wandb

api_key = dbutils. secrets. get("wandb" , "api_key" )

wandb. login(key= api_key)

wandb. init()

wandb. log({"foo" : 1 })

Sweeps

wandb.sweep() または wandb.agent() を使用しようとする notebook に必要なセットアップ (一時的):

import os

# これらは将来的には不要になります

os. environ["WANDB_ENTITY" ] = "my-entity"

os. environ["WANDB_PROJECT" ] = "my-project-that-exists"

6 - DeepChecks

DeepChecks と W&B の統合方法。

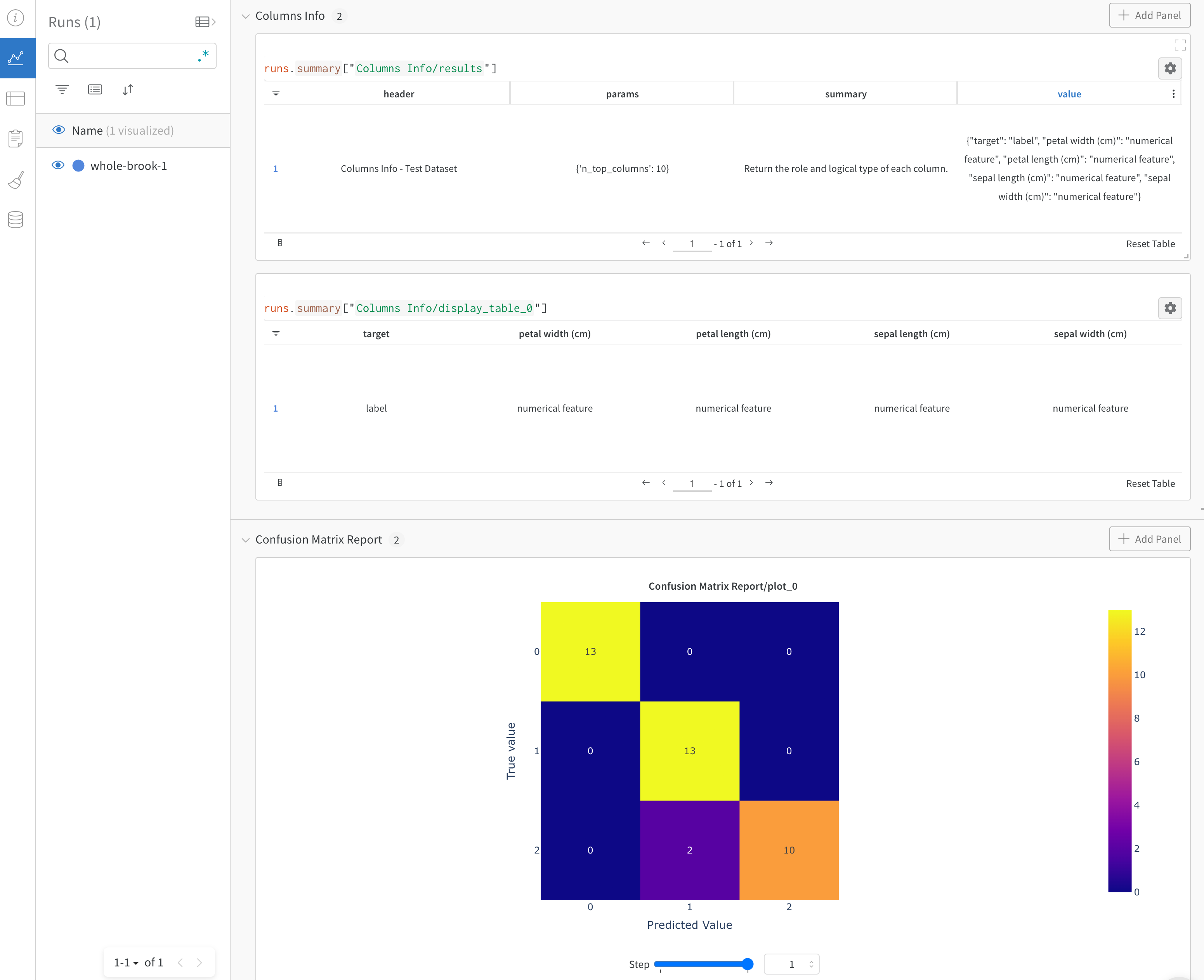

DeepChecks は、機械学習 モデル と データの検証を支援します。たとえば、データの整合性の検証、分布の検査、データ分割の検証、モデル の評価、異なる モデル 間の比較などを、最小限の労力で行うことができます。

DeepChecks と wandb の インテグレーション についてもっと読む ->

はじめに

DeepChecks を Weights & Biases とともに使用するには、まず Weights & Biases アカウント にサインアップする 必要があります こちら 。DeepChecks の Weights & Biases の インテグレーション を使用すると、次のよう にすぐに開始できます。

import wandb

wandb. login()

# deepchecks から チェック をインポートします

from deepchecks.checks import ModelErrorAnalysis

# チェック を実行します

result = ModelErrorAnalysis()

# その 結果 を wandb にプッシュします

result. to_wandb()

DeepChecks テストスイート 全体 を Weights & Biases に ログ することもできます

import wandb

wandb. login()

# deepchecks から full_suite テスト をインポートします

from deepchecks.suites import full_suite

# DeepChecks テストスイート を作成して実行します

suite_result = full_suite(). run(... )

# thes の 結果 を wandb にプッシュします

# ここでは、必要な wandb.init の config と 引数 を渡すことができます

suite_result. to_wandb(project= "my-suite-project" , config= {"suite-name" : "full-suite" })

例

``この レポート

この Weights & Biases の インテグレーション に関する質問や問題がありますか? DeepChecks github repository で issue をオープンしてください。私たちがキャッチして回答します :)

7 - DeepChem

DeepChem ライブラリと W&B を統合する方法。

DeepChem library は、創薬、材料科学、化学、生物学における深層学習の利用を民主化するオープンソースのツールを提供します。この W&B の インテグレーション により、DeepChem を使用してモデルを トレーニング する際に、シンプルで使いやすい 実験管理 とモデルの チェックポイント が追加されます。

3 行のコードで DeepChem のログを記録

logger = WandbLogger(… )

model = TorchModel(… , wandb_logger= logger)

model. fit(… )

Report と Google Colab

W&B with DeepChem: Molecular Graph Convolutional Networks の記事で、W&B DeepChem インテグレーション を使用して生成されたチャートの例をご覧ください。

すぐにコードを試したい場合は、こちらの Google Colab

Experiments の追跡

KerasModel または TorchModel タイプの DeepChem モデル用に W&B をセットアップします。

サインアップして API キー を作成する

API キー は、W&B へのマシンの認証を行います。API キー は、 ユーザー プロフィールから生成できます。

右上隅にある ユーザー プロフィール アイコンをクリックします。

[User Settings ] を選択し、[API Keys ] セクションまでスクロールします。

[Reveal ] をクリックします。表示された API キー をコピーします。API キー を非表示にするには、ページをリロードします。

wandb ライブラリ をインストールしてログインするwandb ライブラリ をローカルにインストールしてログインするには:

Command Line

Python

Python notebook

WANDB_API_KEY 環境変数 を API キー に設定します。

export WANDB_API_KEY= <your_api_key>

wandb ライブラリ をインストールしてログインします。

pip install wandb

wandb login

import wandb

wandb. login()

!pip install wandb

import wandb

wandb.login()

トレーニング および 評価 データ を W&B に ログ 記録する

トレーニング 損失と 評価 メトリクス は、自動的に W&B に ログ 記録できます。オプションの 評価 は、DeepChem ValidationCallback を使用して有効にできます。WandbLogger は ValidationCallback コールバックを検出し、生成された メトリクス を ログ 記録します。

from deepchem.models import TorchModel, ValidationCallback

vc = ValidationCallback(… ) # optional

model = TorchModel(… , wandb_logger= logger)

model. fit(… , callbacks= [vc])

logger. finish()

from deepchem.models import KerasModel, ValidationCallback

vc = ValidationCallback(… ) # optional

model = KerasModel(… , wandb_logger= logger)

model. fit(… , callbacks= [vc])

logger. finish()

8 - Docker

W&B と Docker を統合する方法。

Docker インテグレーション

W&B は、 コード が実行された Docker イメージ へのポインターを保存できます。これにより、以前の 実験 を実行された環境に正確に復元できます。 wandb ライブラリ は、この状態を永続化するために WANDB_DOCKER 環境変数 を探します。この状態を自動的に設定するいくつかのヘルパーを提供します。

ローカル開発

wandb docker は、 dockerコンテナ を起動し、 wandb 環境変数 を渡し、 コード をマウントし、 wandb がインストールされていることを確認する コマンド です。デフォルトでは、この コマンド は TensorFlow、PyTorch、Keras、Jupyter がインストールされた Docker イメージ を使用します。同じ コマンド を使用して、独自の Docker イメージ を起動できます: wandb docker my/image:latest。この コマンド は、現在の ディレクトリー を コンテナ の “/app” ディレクトリー にマウントします。これは “–dir” フラグで変更できます。

本番環境

wandb docker-run コマンド は、 本番環境 の ワークロード 用に提供されています。これは nvidia-docker のドロップイン代替となることを意図しています。これは docker run コマンド へのシンプルなラッパーで、 認証情報 と WANDB_DOCKER 環境変数 を呼び出しに追加します。 “–runtime” フラグを渡さず、 nvidia-docker がマシンで利用可能な場合、これにより ランタイム が nvidia に設定されます。

Kubernetes

Kubernetes で トレーニング の ワークロード を実行し、 k8s API が pod に公開されている場合(デフォルトの場合)。 wandb は、 Docker イメージ のダイジェストについて API にクエリを実行し、 WANDB_DOCKER 環境変数 を自動的に設定します。

復元

run が WANDB_DOCKER 環境変数 で計測されている場合、 wandb restore username/project:run_id を呼び出すと、 コード を復元する新しいブランチをチェックアウトし、 トレーニング に使用された正確な Docker イメージ を元の コマンド で事前に設定して 起動 します。

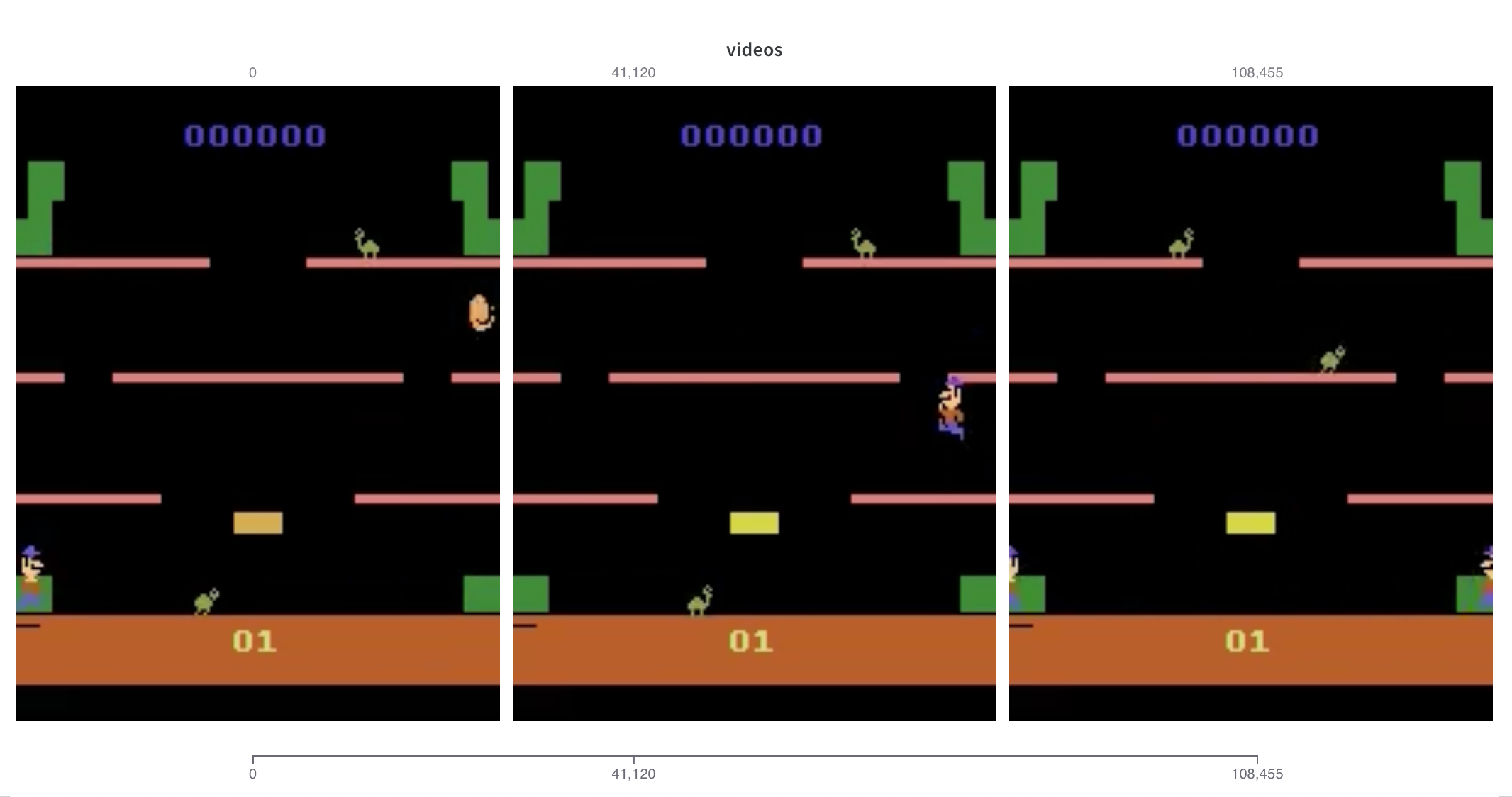

9 - Farama Gymnasium

Farama Gymnasium と W&B を統合する方法。

Farama Gymnasium を使用している場合、gymnasium.wrappers.Monitor で生成された環境の動画が自動的にログに記録されます。monitor_gym キーワード 引数 を wandb.initTrue に設定するだけです。

当社の Gymnasium インテグレーション は非常に軽量です。 gymnasium からログに記録されている 動画ファイルの名前を確認 し、その名前を付けます。一致するものが見つからない場合は、"videos" にフォールバックします。より詳細な制御が必要な場合は、いつでも手動で 動画をログに記録 できます。

CleanRL ライブラリ で Gymnasium を使用する方法の詳細については、こちらの Reports をご覧ください。

10 - fastai

fastai を使用してモデルをトレーニングする場合、W&B には WandbCallback を使用した簡単なインテグレーションがあります。インタラクティブなドキュメントと例はこちら →

サインアップして API キーを作成する

API キーは、W&B に対してお客様のマシンを認証します。API キーは、ユーザー プロフィールから生成できます。

右上隅にあるユーザー プロフィール アイコンをクリックします。

ユーザー設定 を選択し、API キー セクションまでスクロールします。表示 をクリックします。表示された API キーをコピーします。API キーを非表示にするには、ページをリロードします。

wandb ライブラリをインストールしてログインするwandb ライブラリをローカルにインストールしてログインするには:

コマンドライン

Python

Python notebook

WANDB_API_KEY 環境変数 を API キーに設定します。

export WANDB_API_KEY= <your_api_key>

wandb ライブラリをインストールしてログインします。

pip install wandb

wandb login

import wandb

wandb. login()

!pip install wandb

import wandb

wandb.login()

learner または fit メソッドに WandbCallback を追加するimport wandb

from fastai.callback.wandb import *

# start logging a wandb run

wandb. init(project= "my_project" )

# To log only during one training phase

learn. fit(... , cbs= WandbCallback())

# To log continuously for all training phases

learn = learner(... , cbs= WandbCallback())

WandbCallback 引数

WandbCallback は、次の引数を受け入れます。

Args

Description

log

モデルのログを記録するかどうか: gradients 、parameters、all または None (デフォルト)。損失とメトリクスは常にログに記録されます。

log_preds

予測サンプルをログに記録するかどうか (デフォルトは True)。

log_preds_every_epoch

エポックごとに予測をログに記録するか、最後にログに記録するか (デフォルトは False)

log_model

モデルをログに記録するかどうか (デフォルトは False)。これには SaveModelCallback も必要です

model_name

保存する file の名前。SaveModelCallback をオーバーライドします

log_dataset

False (デフォルト)True は、learn.dls.path で参照されるフォルダーをログに記録します。パスを明示的に定義して、ログに記録するフォルダーを参照できます。 注: サブフォルダー “models” は常に無視されます。

dataset_name

ログに記録されたデータセットの名前 (デフォルトは folder name)。

valid_dl

予測サンプルに使用されるアイテムを含む DataLoaders (デフォルトは learn.dls.valid からのランダムなアイテム。

n_preds

ログに記録された予測の数 (デフォルトは 36)。

seed

ランダム サンプルを定義するために使用されます。

カスタム ワークフローでは、データセットとモデルを手動でログに記録できます。

log_dataset(path, name=None, metadata={})log_model(path, name=None, metadata={})

注: サブフォルダー “models” はすべて無視されます。

分散トレーニング

fastai は、コンテキスト マネージャー distrib_ctx を使用して分散トレーニングをサポートします。W&B はこれを自動的にサポートし、すぐに使える Multi-GPU の Experiments を追跡できるようにします。

この最小限の例を確認してください。

import wandb

from fastai.vision.all import *

from fastai.distributed import *

from fastai.callback.wandb import WandbCallback

wandb. require(experiment= "service" )

path = rank0_first(lambda : untar_data(URLs. PETS) / "images" )

def train ():

dls = ImageDataLoaders. from_name_func(

path,

get_image_files(path),

valid_pct= 0.2 ,

label_func= lambda x: x[0 ]. isupper(),

item_tfms= Resize(224 ),

)

wandb. init("fastai_ddp" , entity= "capecape" )

cb = WandbCallback()

learn = vision_learner(dls, resnet34, metrics= error_rate, cbs= cb). to_fp16()

with learn. distrib_ctx(sync_bn= False ):

learn. fit(1 )

if __name__ == "__main__" :

train()

次に、ターミナルで次を実行します。

$ torchrun --nproc_per_node 2 train.py

この場合、マシンには 2 つの GPU があります。

ノートブック内で分散トレーニングを直接実行できるようになりました。

import wandb

from fastai.vision.all import *

from accelerate import notebook_launcher

from fastai.distributed import *

from fastai.callback.wandb import WandbCallback

wandb. require(experiment= "service" )

path = untar_data(URLs. PETS) / "images"

def train ():

dls = ImageDataLoaders. from_name_func(

path,

get_image_files(path),

valid_pct= 0.2 ,

label_func= lambda x: x[0 ]. isupper(),

item_tfms= Resize(224 ),

)

wandb. init("fastai_ddp" , entity= "capecape" )

cb = WandbCallback()

learn = vision_learner(dls, resnet34, metrics= error_rate, cbs= cb). to_fp16()

with learn. distrib_ctx(in_notebook= True , sync_bn= False ):

learn. fit(1 )

notebook_launcher(train, num_processes= 2 )

メイン プロセスでのみログを記録する

上記の例では、wandb はプロセスごとに 1 つの run を起動します。トレーニングの最後に、2 つの run が作成されます。これは混乱を招く可能性があるため、メイン プロセスでのみログに記録したい場合があります。そのためには、どのプロセスに手動でいるかを検出し、他のすべてのプロセスで run を作成 ( wandb.init を呼び出す) しないようにする必要があります。

import wandb

from fastai.vision.all import *

from fastai.distributed import *

from fastai.callback.wandb import WandbCallback

wandb. require(experiment= "service" )

path = rank0_first(lambda : untar_data(URLs. PETS) / "images" )

def train ():

cb = []

dls = ImageDataLoaders. from_name_func(

path,

get_image_files(path),

valid_pct= 0.2 ,

label_func= lambda x: x[0 ]. isupper(),

item_tfms= Resize(224 ),

)

if rank_distrib() == 0 :

run = wandb. init("fastai_ddp" , entity= "capecape" )

cb = WandbCallback()

learn = vision_learner(dls, resnet34, metrics= error_rate, cbs= cb). to_fp16()

with learn. distrib_ctx(sync_bn= False ):

learn. fit(1 )

if __name__ == "__main__" :

train()

ターミナルで次を呼び出します。

$ torchrun --nproc_per_node 2 train.py

import wandb

from fastai.vision.all import *

from accelerate import notebook_launcher

from fastai.distributed import *

from fastai.callback.wandb import WandbCallback

wandb. require(experiment= "service" )

path = untar_data(URLs. PETS) / "images"

def train ():

cb = []

dls = ImageDataLoaders. from_name_func(

path,

get_image_files(path),

valid_pct= 0.2 ,

label_func= lambda x: x[0 ]. isupper(),

item_tfms= Resize(224 ),

)

if rank_distrib() == 0 :

run = wandb. init("fastai_ddp" , entity= "capecape" )

cb = WandbCallback()

learn = vision_learner(dls, resnet34, metrics= error_rate, cbs= cb). to_fp16()

with learn. distrib_ctx(in_notebook= True , sync_bn= False ):

learn. fit(1 )

notebook_launcher(train, num_processes= 2 )

例

10.1 - fastai v1

このドキュメントは fastai v1 用です。

現在のバージョンの fastai を使用している場合は、

fastai のページ を参照してください。

fastai v1 を使用するスクリプトの場合、モデルのトポロジー、損失、メトリクス、重み、勾配、サンプル予測、および最高のトレーニング済みモデルを自動的にログに記録できる コールバック があります。

import wandb

from wandb.fastai import WandbCallback

wandb. init()

learn = cnn_learner(data, model, callback_fns= WandbCallback)

learn. fit(epochs)

リクエストされたログデータは、 コールバック コンストラクターを通じて設定可能です。

from functools import partial

learn = cnn_learner(

data, model, callback_fns= partial(WandbCallback, input_type= "images" )

)

トレーニング の開始時にのみ WandbCallback を使用することも可能です。この場合、インスタンス化する必要があります。

learn. fit(epochs, callbacks= WandbCallback(learn))

カスタム パラメータ は、その段階で指定することもできます。

learn. fit(epochs, callbacks= WandbCallback(learn, input_type= "images" ))

コード 例

この インテグレーション の動作を確認するためのいくつかの例を作成しました。

Fastai v1

オプション

WandbCallback() クラス は、多数のオプションをサポートしています。

キーワード 引数

デフォルト

説明

learn

N/A

フック する fast.ai の学習器。

save_model

True

各ステップで改善された場合、モデルを保存します。トレーニング の最後に最高のモデルもロードします。

mode

auto

min、max、または auto: monitor で指定された トレーニング メトリクス をステップ間で比較する方法。

monitor

None

最高のモデルを保存するためにパフォーマンスを測定するために使用される トレーニング メトリクス。None は、検証損失をデフォルトにします。

log

gradients

gradients、parameters、all、または None。損失と メトリクス は常にログに記録されます。

input_type

None

images または None。サンプル予測を表示するために使用されます。

validation_data

None

input_type が設定されている場合、サンプル予測に使用されるデータ。

predictions

36

input_type が設定され、validation_data が None の場合に行う予測の数。

seed

12345

input_type が設定され、validation_data が None の場合、サンプル予測のために乱数ジェネレーターを初期化します。

11 - Hugging Face Transformers

Hugging Face Transformers ライブラリを使用すると、BERTのような最先端の NLP モデルや、混合精度や勾配チェックポイントなどのトレーニング手法を簡単に使用できます。W&B integration は、使いやすさを損なうことなく、インタラクティブな集中ダッシュボードに、豊富で柔軟な実験管理とモデルの バージョン管理を追加します。

わずか数行で次世代のロギング

os. environ["WANDB_PROJECT" ] = "<my-amazing-project>" # W&B プロジェクトに名前を付ける

os. environ["WANDB_LOG_MODEL" ] = "checkpoint" # すべてのモデルチェックポイントをログに記録

from transformers import TrainingArguments, Trainer

args = TrainingArguments(... , report_to= "wandb" ) # W&B ロギングをオンにする

trainer = Trainer(... , args= args)

はじめに: 実験の トラッキング

サインアップして API キーを作成する

API キーは、お使いのマシンを W&B に対して認証します。API キーは、ユーザープロフィールから生成できます。

右上隅にあるユーザープロフィールアイコンをクリックします。

[User Settings ]を選択し、[API Keys ]セクションまでスクロールします。

[Reveal ]をクリックします。表示された API キーをコピーします。API キーを非表示にするには、ページをリロードします。

wandb ライブラリをインストールしてログインするwandb ライブラリをローカルにインストールしてログインするには:

Command Line

Python

Python notebook

WANDB_API_KEY 環境変数 を API キーに設定します。

export WANDB_API_KEY= <your_api_key>

wandb ライブラリをインストールしてログインします。

pip install wandb

wandb login

import wandb

wandb. login()

!pip install wandb

import wandb

wandb.login()

W&B を初めて使用する場合は、クイックスタート

プロジェクトに名前を付ける

W&B の Project とは、関連する run からログに記録されたすべてのチャート、データ、およびモデルが保存される場所です。プロジェクトに名前を付けると、作業を整理し、単一のプロジェクトに関するすべての情報を 1 か所にまとめて管理できます。

run をプロジェクトに追加するには、WANDB_PROJECT 環境変数をプロジェクト名に設定するだけです。WandbCallback は、このプロジェクト名の環境変数を取得し、run の設定時に使用します。

Command Line

Python

Python notebook

WANDB_PROJECT= amazon_sentiment_analysis

import os

os. environ["WANDB_PROJECT" ]= "amazon_sentiment_analysis"

%env WANDB_PROJECT=amazon_sentiment_analysis

Trainer を初期化する 前に 、必ずプロジェクト名を設定してください。

プロジェクト名が指定されていない場合、プロジェクト名はデフォルトで huggingface になります。

トレーニングの run を W&B に記録する

コード内またはコマンドラインで Trainer のトレーニング引数を定義する際に 最も重要なステップ は、W&B でのロギングを有効にするために、report_to を "wandb" に設定することです。

TrainingArguments の logging_steps 引数は、トレーニング中にトレーニングメトリクスが W&B にプッシュされる頻度を制御します。run_name 引数を使用して、W&B のトレーニング run に名前を付けることもできます。

これで完了です。モデルは、トレーニング中に損失、評価メトリクス、モデルトポロジー、および勾配を W&B に記録します。

python run_glue.py \ # Python スクリプトを実行する

--report_to wandb \ # W&B へのロギングを有効にする

--run_name bert-base-high-lr \ # W&B run の名前 (オプション)

# その他のコマンドライン引数

from transformers import TrainingArguments, Trainer

args = TrainingArguments(

# その他の args と kwargs

report_to= "wandb" , # W&B へのロギングを有効にする

run_name= "bert-base-high-lr" , # W&B run の名前 (オプション)

logging_steps= 1 , # W&B へのロギング頻度

)

trainer = Trainer(

# その他の args と kwargs

args= args, # トレーニングの引数

)

trainer. train() # トレーニングを開始して W&B にログを記録する

TensorFlow を使用していますか?PyTorch Trainer を TensorFlow TFTrainer に交換するだけです。

モデルチェックポイントをオンにする

Artifacts を使用すると、最大 100GB のモデルとデータセットを無料で保存し、Weights & Biases Registry を使用できます。Registry を使用すると、モデルを登録して探索および評価したり、ステージングの準備をしたり、本番環境にデプロイしたりできます。

Hugging Face モデルチェックポイントを Artifacts に記録するには、WANDB_LOG_MODEL 環境変数を次の いずれか に設定します。

checkpointTrainingArgumentsargs.save_steps ごとにチェックポイントをアップロードします。endload_best_model_at_end も設定されている場合は、トレーニングの最後にモデルをアップロードします。false

Command Line

Python

Python notebook

WANDB_LOG_MODEL= "checkpoint"

import os

os. environ["WANDB_LOG_MODEL" ] = "checkpoint"

%env WANDB_LOG_MODEL="checkpoint"

これから初期化する Transformers Trainer はすべて、モデルを W&B プロジェクトにアップロードします。ログに記録したモデルチェックポイントは、Artifacts UI で表示でき、完全なモデルリネージが含まれています (UI のモデルチェックポイントの例は こちら を参照してください)。

デフォルトでは、

WANDB_LOG_MODEL が

end に設定されている場合は

model-{run_id} として、

WANDB_LOG_MODEL が

checkpoint に設定されている場合は

checkpoint-{run_id} として、モデルは W&B Artifacts に保存されます。

ただし、

TrainingArguments で

run_name を渡すと、モデルは

model-{run_name} または

checkpoint-{run_name} として保存されます。

W&B Registry

チェックポイントを Artifacts に記録したら、最高のモデルチェックポイントを登録し、Registry 自動化 したりできます。

モデル Artifact をリンクするには、Registry を参照してください。

トレーニング中に評価出力を可視化する

トレーニング中または評価中にモデル出力を可視化することは、モデルのトレーニング方法を実際に理解するために不可欠なことがよくあります。

Transformers Trainer のコールバックシステムを使用すると、モデルのテキスト生成出力やその他の予測などの追加の役立つデータを W&B Tables に W&B に記録できます。

トレーニング中に評価出力を記録して、次のような W&B Table に記録する方法の詳細については、以下の カスタムロギングセクション

W&B Run を終了する (ノートブックのみ)

トレーニングが Python スクリプトにカプセル化されている場合、スクリプトが終了すると W&B run は終了します。

Jupyter または Google Colab ノートブックを使用している場合は、wandb.finish() を呼び出して、トレーニングが完了したことを伝える必要があります。

trainer. train() # トレーニングを開始して W&B にログを記録する

# トレーニング後の分析、テスト、その他のログに記録されたコード

wandb. finish()

結果を可視化する

トレーニング結果をログに記録したら、W&B Dashboard で結果を動的に調べることができます。柔軟でインタラクティブな可視化により、多数の run を一度に比較したり、興味深い発見を拡大したり、複雑なデータから洞察を引き出したりするのが簡単です。

高度な機能と FAQ

最適なモデルを保存するにはどうすればよいですか?

load_best_model_at_end=True で TrainingArguments を Trainer に渡すと、W&B は最適なパフォーマンスのモデルチェックポイントを Artifacts に保存します。

モデルチェックポイントを Artifacts として保存する場合は、Registry に昇格させることができます。Registry では、次のことができます。

ML タスクごとに最適なモデルバージョンを整理します。

モデルを一元化してチームと共有します。

本番環境用にモデルをステージングするか、詳細な評価のためにブックマークします。

ダウンストリーム CI/CD プロセスをトリガーします。

保存されたモデルをロードするにはどうすればよいですか?

WANDB_LOG_MODEL を使用してモデルを W&B Artifacts に保存した場合は、追加のトレーニングまたは推論を実行するためにモデルの重みをダウンロードできます。以前に使用したのと同じ Hugging Face アーキテクチャにロードするだけです。

# 新しい run を作成する

with wandb. init(project= "amazon_sentiment_analysis" ) as run:

# Artifact の名前とバージョンを渡す

my_model_name = "model-bert-base-high-lr:latest"

my_model_artifact = run. use_artifact(my_model_name)

# モデルの重みをフォルダーにダウンロードしてパスを返す

model_dir = my_model_artifact. download()

# 同じモデルクラスを使用して、そのフォルダーから Hugging Face モデルをロードする

model = AutoModelForSequenceClassification. from_pretrained(

model_dir, num_labels= num_labels

)

# 追加のトレーニングを実行するか、推論を実行する

チェックポイントからトレーニングを再開するにはどうすればよいですか?

WANDB_LOG_MODEL='checkpoint' を設定した場合は、model_dir を TrainingArguments の model_name_or_path 引数として使用し、resume_from_checkpoint=True を Trainer に渡すことで、トレーニングを再開することもできます。

last_run_id = "xxxxxxxx" # wandb ワークスペースから run_id を取得する

# run_id から wandb run を再開する

with wandb. init(

project= os. environ["WANDB_PROJECT" ],

id= last_run_id,

resume= "must" ,

) as run:

# Artifact を run に接続する

my_checkpoint_name = f "checkpoint- { last_run_id} :latest"

my_checkpoint_artifact = run. use_artifact(my_model_name)

# チェックポイントをフォルダーにダウンロードしてパスを返す

checkpoint_dir = my_checkpoint_artifact. download()

# モデルとトレーナーを再初期化する

model = AutoModelForSequenceClassification. from_pretrained(

"<model_name>" , num_labels= num_labels

)

# ここに素晴らしいトレーニング引数を記述する。

training_args = TrainingArguments()

trainer = Trainer(model= model, args= training_args)

# チェックポイントディレクトリを使用して、チェックポイントからトレーニングを再開する

trainer. train(resume_from_checkpoint= checkpoint_dir)

トレーニング中に評価サンプルを記録して表示するにはどうすればよいですか?

Transformers Trainer を介した W&B へのロギングは、Transformers ライブラリの WandbCallbackWandbCallback をサブクラス化し、Trainer クラスの追加メソッドを活用する追加機能を追加して、このコールバックを変更できます。

以下は、この新しいコールバックを HF Trainer に追加する一般的なパターンであり、さらに下には、評価出力を W&B Table に記録するコード完全な例があります。

# Trainer を通常どおりインスタンス化する

trainer = Trainer()

# 新しいロギングコールバックをインスタンス化し、Trainer オブジェクトを渡す

evals_callback = WandbEvalsCallback(trainer, tokenizer, ... )

# コールバックを Trainer に追加する

trainer. add_callback(evals_callback)

# 通常どおり Trainer トレーニングを開始する

trainer. train()

トレーニング中に評価サンプルを表示する

次のセクションでは、WandbCallback をカスタマイズして、モデルの予測を実行し、トレーニング中に評価サンプルを W&B Table に記録する方法について説明します。Trainer コールバックの on_evaluate メソッドを使用して、すべての eval_steps を実行します。

ここでは、tokenizer を使用してモデル出力から予測とラベルをデコードする decode_predictions 関数を作成しました。

次に、予測とラベルから pandas DataFrame を作成し、DataFrame に epoch 列を追加します。

最後に、DataFrame から wandb.Table を作成し、wandb に記録します。

さらに、予測を freq エポックごとに記録することで、ロギングの頻度を制御できます。

注 : 通常の WandbCallback とは異なり、このカスタムコールバックは、Trainer の初期化中ではなく、Trainer がインスタンス化された後 にトレーナーに追加する必要があります。

これは、Trainer インスタンスが初期化中にコールバックに渡されるためです。

from transformers.integrations import WandbCallback

import pandas as pd

def decode_predictions (tokenizer, predictions):

labels = tokenizer. batch_decode(predictions. label_ids)

logits = predictions. predictions. argmax(axis=- 1 )

prediction_text = tokenizer. batch_decode(logits)

return {"labels" : labels, "predictions" : prediction_text}

class WandbPredictionProgressCallback (WandbCallback):

"""Custom WandbCallback to log model predictions during training.

This callback logs model predictions and labels to a wandb.Table at each

logging step during training. It allows to visualize the

model predictions as the training progresses.

Attributes:

trainer (Trainer): The Hugging Face Trainer instance.

tokenizer (AutoTokenizer): The tokenizer associated with the model.

sample_dataset (Dataset): A subset of the validation dataset

for generating predictions.

num_samples (int, optional): Number of samples to select from

the validation dataset for generating predictions. Defaults to 100.

freq (int, optional): Frequency of logging. Defaults to 2.

"""

def __init__(self, trainer, tokenizer, val_dataset, num_samples= 100 , freq= 2 ):

"""Initializes the WandbPredictionProgressCallback instance.

Args:

trainer (Trainer): The Hugging Face Trainer instance.

tokenizer (AutoTokenizer): The tokenizer associated

with the model.

val_dataset (Dataset): The validation dataset.

num_samples (int, optional): Number of samples to select from

the validation dataset for generating predictions.

Defaults to 100.

freq (int, optional): Frequency of logging. Defaults to 2.

"""

super(). __init__()

self. trainer = trainer

self. tokenizer = tokenizer

self. sample_dataset = val_dataset. select(range(num_samples))

self. freq = freq

def on_evaluate (self, args, state, control, ** kwargs):

super(). on_evaluate(args, state, control, ** kwargs)

# control the frequency of logging by logging the predictions

# every `freq` epochs

if state. epoch % self. freq == 0 :

# generate predictions

predictions = self. trainer. predict(self. sample_dataset)

# decode predictions and labels

predictions = decode_predictions(self. tokenizer, predictions)

# add predictions to a wandb.Table

predictions_df = pd. DataFrame(predictions)

predictions_df["epoch" ] = state. epoch

records_table = self. _wandb. Table(dataframe= predictions_df)

# log the table to wandb

self. _wandb. log({"sample_predictions" : records_table})

# まず、Trainer をインスタンス化する

trainer = Trainer(

model= model,

args= training_args,

train_dataset= lm_datasets["train" ],

eval_dataset= lm_datasets["validation" ],

)

# WandbPredictionProgressCallback をインスタンス化する

progress_callback = WandbPredictionProgressCallback(

trainer= trainer,

tokenizer= tokenizer,

val_dataset= lm_dataset["validation" ],

num_samples= 10 ,

freq= 2 ,

)

# コールバックをトレーナーに追加する

trainer. add_callback(progress_callback)

詳細な例については、こちらの colab を参照してください。

その他の W&B 設定はありますか?

環境変数を設定することで、Trainer でログに記録される内容をさらに構成できます。W&B 環境変数の完全なリストは、こちら にあります。

環境変数

使用法

WANDB_PROJECTプロジェクトに名前を付けます (デフォルトでは huggingface)

WANDB_LOG_MODELモデルチェックポイントを W&B Artifact として記録します (デフォルトでは false)

false (デフォルト): モデルチェックポイントなしcheckpoint: チェックポイントは args.save_steps ごとにアップロードされます (Trainer の TrainingArguments で設定)。end: 最終的なモデルチェックポイントはトレーニングの最後にアップロードされます。

WANDB_WATCHモデルの勾配、パラメーター、またはそのどちらもログに記録するかどうかを設定します

false (デフォルト): 勾配またはパラメーターのロギングなしgradients: 勾配のヒストグラムをログに記録しますall: 勾配とパラメーターのヒストグラムをログに記録します

WANDB_DISABLEDロギングを完全にオフにするには true に設定します (デフォルトでは false)

WANDB_SILENTwandb によって出力される出力を抑制するには true に設定します (デフォルトでは false)

WANDB_WATCH= all

WANDB_SILENT= true

%env WANDB_WATCH=all

%env WANDB_SILENT=true

wandb.init をカスタマイズするにはどうすればよいですか?Trainer が使用する WandbCallback は、Trainer が初期化されるときに内部で wandb.init を呼び出します。Trainer が初期化される前に wandb.init を呼び出すことで、run を手動で設定することもできます。これにより、W&B run の構成を完全に制御できます。

init に渡したい可能性のあるものの例を以下に示します。wandb.init の使用方法の詳細については、リファレンスドキュメントをご確認ください 。

wandb. init(

project= "amazon_sentiment_analysis" ,

name= "bert-base-high-lr" ,

tags= ["baseline" , "high-lr" ],

group= "bert" ,

)

その他のリソース

以下は、Transformer と W&B に関連する 6 つの記事です。

Hugging Face Transformers のハイパーパラメーター最適化

Hugging Face Transformers のハイパーパラメーター最適化のための 3 つの戦略 (グリッド検索、ベイズ最適化、Population Based Training) が比較されます。

Hugging Face transformers から標準的な uncased BERT モデルを使用し、SuperGLUE ベンチマークから RTE データセットでファインチューニングしたいと考えています。

結果は、Population Based Training が Hugging Face transformer モデルのハイパーパラメーター最適化に最も効果的なアプローチであることを示しています。

完全なレポートは こちら をお読みください。

Hugging Tweets: ツイートを生成するモデルをトレーニングする

この記事では、著者は、誰かのツイートで学習済みの GPT2 HuggingFace Transformer モデルを 5 分でファインチューニングする方法を示しています。

このモデルは、ツイートのダウンロード、データセットの最適化、初期実験、ユーザー間の損失の比較、モデルのファインチューニングというパイプラインを使用しています。

完全なレポートは こちら をお読みください。

Hugging Face BERT および WB を使用した文分類

この記事では、自然言語処理における最近の画期的な進歩の力を活用して、文分類子を作成します。ここでは、NLP への転移学習の応用例に焦点を当てます。

単一文分類には、言語的許容度 (CoLA) データセットを使用します。これは、2018 年 5 月に初めて公開された、文法的に正しいか正しくないかというラベルが付けられた文のセットです。

Google の BERT を使用して、さまざまな NLP タスクで最小限の労力で高性能モデルを作成します。

完全なレポートは こちら をお読みください。

Hugging Face モデルのパフォーマンスを追跡するためのステップバイステップガイド

W&B と Hugging Face transformers を使用して、GLUE ベンチマークで DistilBERT (BERT より 40% 小さいが、BERT の精度の 97% を保持する Transformer) をトレーニングします。

GLUE ベンチマークは、NLP モデルをトレーニングするための 9 つのデータセットとタスクのコレクションです。

完全なレポートは こちら をお読みください。

HuggingFace での早期停止の例

早期停止の正規化を使用して Hugging Face Transformer をファインチューニングは、PyTorch または TensorFlow でネイティブに行うことができます。

TensorFlow での EarlyStopping コールバックの使用は、tf.keras.callbacks.EarlyStopping コールバックを使用すると簡単です。

PyTorch では、既製の早期停止メソッドはありませんが、GitHub Gist で利用できる作業中の早期停止フックがあります。

完全なレポートは こちら をお読みください。

カスタムデータセットで Hugging Face Transformers をファインチューンする方法

カスタム IMDB データセットでセンチメント分析 (バイナリ分類) 用に DistilBERT transformer をファインチューンします。

完全なレポートは こちら をお読みください。

ヘルプの入手または機能のリクエスト

Hugging Face W&B integration に関する問題、質問、または機能のリクエストについては、Hugging Face フォーラムのこのスレッド に投稿するか、Hugging Face Transformers GitHub repo で issue をオープンしてください。

12 - Hugging Face Diffusers

Hugging Face Diffusers は、画像、音声、さらには分子の3D構造を生成するための、最先端の学習済み拡散モデルのための頼りになるライブラリです。Weights & Biases のインテグレーションは、その使いやすさを損なうことなく、インタラクティブな集中 ダッシュボードに、豊富で柔軟な 実験管理、メディアの 可視化、パイプライン アーキテクチャ、および 設定管理を追加します。

たった2行で次世代のログ記録

わずか2行のコードを含めるだけで、プロンプト、ネガティブプロンプト、生成されたメディア、および 実験 に関連付けられた config をすべて記録します。以下は、ログ記録を開始するための2行のコードです。

# import the autolog function

from wandb.integration.diffusers import autolog

# call the autolog before calling the pipeline

autolog(init= dict(project= "diffusers_logging" ))

実験 の 結果 がどのように記録されるかの例。

はじめに

diffusers、transformers、accelerate、および wandb をインストールします。

コマンドライン:

pip install --upgrade diffusers transformers accelerate wandb

ノートブック:

!pip install --upgrade diffusers transformers accelerate wandb

autolog を使用して Weights & Biases の run を初期化し、サポートされているすべての パイプライン 呼び出し からの入力と出力を自動的に追跡します。

wandb.init()init パラメータ を使用して、autolog() 関数を呼び出すことができます。

autolog() を呼び出すと、Weights & Biases の run が初期化され、サポートされているすべての パイプライン 呼び出し からの入力と出力が自動的に追跡されます。

各 パイプライン 呼び出しは、ワークスペース 内の独自の テーブル に追跡され、パイプライン 呼び出しに関連付けられた config は、その run の config 内の ワークフロー のリストに追加されます。

プロンプト、ネガティブプロンプト、および生成されたメディアは、wandb.Table

シードや パイプライン アーキテクチャ を含む、実験 に関連付けられたその他すべての config は、run の config セクションに保存されます。

各 パイプライン 呼び出しで生成されたメディアは、run の メディア パネル にも記録されます。

サポートされている パイプライン 呼び出しのリストは、[こちら](https://github.com/wandb/wandb/blob/main/wandb/integration/diffusers/autologger.py#L12-L72)にあります。このインテグレーションの新しい機能をリクエストしたり、それに関連するバグを報告したりする場合は、[https://github.com/wandb/wandb/issues](https://github.com/wandb/wandb/issues) で issue をオープンしてください。

例

Autologging

以下は、動作中の autolog の簡単な エンドツーエンド の例です。

import torch

from diffusers import DiffusionPipeline

# import the autolog function

from wandb.integration.diffusers import autolog

# call the autolog before calling the pipeline

autolog(init= dict(project= "diffusers_logging" ))

# Initialize the diffusion pipeline

pipeline = DiffusionPipeline. from_pretrained(

"stabilityai/stable-diffusion-2-1" , torch_dtype= torch. float16

). to("cuda" )

# Define the prompts, negative prompts, and seed.

prompt = ["a photograph of an astronaut riding a horse" , "a photograph of a dragon" ]

negative_prompt = ["ugly, deformed" , "ugly, deformed" ]

generator = torch. Generator(device= "cpu" ). manual_seed(10 )

# call the pipeline to generate the images

images = pipeline(

prompt,

negative_prompt= negative_prompt,

num_images_per_prompt= 2 ,

generator= generator,

)

import torch

from diffusers import DiffusionPipeline

import wandb

# import the autolog function

from wandb.integration.diffusers import autolog

# call the autolog before calling the pipeline

autolog(init= dict(project= "diffusers_logging" ))

# Initialize the diffusion pipeline

pipeline = DiffusionPipeline. from_pretrained(

"stabilityai/stable-diffusion-2-1" , torch_dtype= torch. float16

). to("cuda" )

# Define the prompts, negative prompts, and seed.

prompt = ["a photograph of an astronaut riding a horse" , "a photograph of a dragon" ]

negative_prompt = ["ugly, deformed" , "ugly, deformed" ]

generator = torch. Generator(device= "cpu" ). manual_seed(10 )

# call the pipeline to generate the images

images = pipeline(

prompt,

negative_prompt= negative_prompt,

num_images_per_prompt= 2 ,

generator= generator,

)

# Finish the experiment

wandb. finish()

単一の 実験 の結果:

複数の 実験 の結果:

実験 の config:

パイプライン を呼び出した後、IPython ノートブック 環境でコードを実行する場合は、

wandb.finish()を明示的に呼び出す必要があります。これは、Python スクリプトを実行する場合は必要ありません。

複数 パイプライン ワークフロー の追跡

このセクションでは、StableDiffusionXLPipelineStable Diffusion XL + Refiner ワークフロー での autolog を示します。

import torch

from diffusers import StableDiffusionXLImg2ImgPipeline, StableDiffusionXLPipeline

from wandb.integration.diffusers import autolog

# initialize the SDXL base pipeline

base_pipeline = StableDiffusionXLPipeline. from_pretrained(

"stabilityai/stable-diffusion-xl-base-1.0" ,

torch_dtype= torch. float16,

variant= "fp16" ,

use_safetensors= True ,

)

base_pipeline. enable_model_cpu_offload()

# initialize the SDXL refiner pipeline

refiner_pipeline = StableDiffusionXLImg2ImgPipeline. from_pretrained(

"stabilityai/stable-diffusion-xl-refiner-1.0" ,

text_encoder_2= base_pipeline. text_encoder_2,

vae= base_pipeline. vae,

torch_dtype= torch. float16,

use_safetensors= True ,

variant= "fp16" ,

)

refiner_pipeline. enable_model_cpu_offload()

prompt = "a photo of an astronaut riding a horse on mars"

negative_prompt = "static, frame, painting, illustration, sd character, low quality, low resolution, greyscale, monochrome, nose, cropped, lowres, jpeg artifacts, deformed iris, deformed pupils, bad eyes, semi-realistic worst quality, bad lips, deformed mouth, deformed face, deformed fingers, deformed toes standing still, posing"

# Make the experiment reproducible by controlling randomness.

# The seed would be automatically logged to WandB.

seed = 42

generator_base = torch. Generator(device= "cuda" ). manual_seed(seed)

generator_refiner = torch. Generator(device= "cuda" ). manual_seed(seed)

# Call WandB Autolog for Diffusers. This would automatically log

# the prompts, generated images, pipeline architecture and all

# associated experiment configs to Weights & Biases, thus making your

# image generation experiments easy to reproduce, share and analyze.

autolog(init= dict(project= "sdxl" ))

# Call the base pipeline to generate the latents

image = base_pipeline(

prompt= prompt,

negative_prompt= negative_prompt,

output_type= "latent" ,

generator= generator_base,

). images[0 ]

# Call the refiner pipeline to generate the refined image

image = refiner_pipeline(

prompt= prompt,

negative_prompt= negative_prompt,

image= image[None , :],

generator= generator_refiner,

). images[0 ]

import torch

from diffusers import StableDiffusionXLImg2ImgPipeline, StableDiffusionXLPipeline

import wandb

from wandb.integration.diffusers import autolog

# initialize the SDXL base pipeline

base_pipeline = StableDiffusionXLPipeline. from_pretrained(

"stabilityai/stable-diffusion-xl-base-1.0" ,

torch_dtype= torch. float16,

variant= "fp16" ,

use_safetensors= True ,

)

base_pipeline. enable_model_cpu_offload()

# initialize the SDXL refiner pipeline

refiner_pipeline = StableDiffusionXLImg2ImgPipeline. from_pretrained(

"stabilityai/stable-diffusion-xl-refiner-1.0" ,

text_encoder_2= base_pipeline. text_encoder_2,

vae= base_pipeline. vae,

torch_dtype= torch. float16,

use_safetensors= True ,

variant= "fp16" ,

)

refiner_pipeline. enable_model_cpu_offload()

prompt = "a photo of an astronaut riding a horse on mars"

negative_prompt = "static, frame, painting, illustration, sd character, low quality, low resolution, greyscale, monochrome, nose, cropped, lowres, jpeg artifacts, deformed iris, deformed pupils, bad eyes, semi-realistic worst quality, bad lips, deformed mouth, deformed face, deformed fingers, deformed toes standing still, posing"

# Make the experiment reproducible by controlling randomness.

# The seed would be automatically logged to WandB.

seed = 42

generator_base = torch. Generator(device= "cuda" ). manual_seed(seed)

generator_refiner = torch. Generator(device= "cuda" ). manual_seed(seed)

# Call WandB Autolog for Diffusers. This would automatically log

# the prompts, generated images, pipeline architecture and all

# associated experiment configs to Weights & Biases, thus making your

# image generation experiments easy to reproduce, share and analyze.

autolog(init= dict(project= "sdxl" ))

# Call the base pipeline to generate the latents

image = base_pipeline(

prompt= prompt,

negative_prompt= negative_prompt,

output_type= "latent" ,

generator= generator_base,

). images[0 ]

# Call the refiner pipeline to generate the refined image

image = refiner_pipeline(

prompt= prompt,

negative_prompt= negative_prompt,

image= image[None , :],

generator= generator_refiner,

). images[0 ]

# Finish the experiment

wandb. finish()

Stable Diffisuion XL + Refiner の 実験 の例:

その他のリソース

13 - Hugging Face AutoTrain

Hugging Face AutoTrain は、自然言語処理(NLP)タスク、コンピュータビジョン(CV)タスク、音声タスク、さらには表形式タスクのために、最先端のモデルをトレーニングするためのノーコード ツールです。

Weights & Biases は Hugging Face AutoTrain に直接統合されており、実験管理と構成管理を提供します。これは、実験の CLI コマンドで単一の パラメータ を使用するのと同じくらい簡単です。

前提条件のインストール

autotrain-advanced と wandb をインストールします。

pip install --upgrade autotrain-advanced wandb

!pip install --upgrade autotrain-advanced wandb

これらの変更を示すために、このページでは、GSM8k Benchmarks で pass@1 の SoTA 結果を達成するために、数学 データセット で LLM を微調整します。

データセット を準備する

Hugging Face AutoTrain は、適切に機能するために、CSV カスタム データセット が特定の形式になっていることを想定しています。

トレーニング ファイルには、トレーニングで使用する text 列が含まれている必要があります。最良の結果を得るには、text 列のデータが ### Human: Question?### Assistant: Answer. 形式に準拠している必要があります。timdettmers/openassistant-guanaco

ただし、MetaMathQA dataset には、query、response、および type 列が含まれています。最初に、この データセット を前処理します。type 列を削除し、query 列と response 列の内容を ### Human: Query?### Assistant: Response. 形式の新しい text 列に結合します。トレーニングでは、結果の データセット rishiraj/guanaco-style-metamath

autotrain を使用してトレーニングするコマンドラインまたは ノートブック から autotrain advanced を使用してトレーニングを開始できます。--log 引数を使用するか、--log wandb を使用して、W&B run に 結果 を ログ します。

autotrain llm \

\

\

\

\

\

\

\

4 \

3 \

1024 \

\

16 \

32 \

\

\

4 \

10 \

\

\

\

\

\

\

# ハイパーパラメータ を設定する

learning_rate = 2e-5

num_epochs = 3

batch_size = 4

block_size = 1024

trainer = "sft"

warmup_ratio = 0.03

weight_decay = 0.

gradient_accumulation = 4

lora_r = 16

lora_alpha = 32

lora_dropout = 0.05

logging_steps = 10

# トレーニングを実行する

!autotrain llm \

--train \

--model "HuggingFaceH4/zephyr-7b-alpha" \

--project-name "zephyr-math" \

--log "wandb" \

--data-path data/ \

--text-column text \

--lr str(learning_rate) \

--batch-size str(batch_size) \

--epochs str(num_epochs) \

--block-size str(block_size) \

--warmup-ratio str(warmup_ratio) \

--lora-r str(lora_r) \

--lora-alpha str(lora_alpha) \

--lora-dropout str(lora_dropout) \

--weight-decay str(weight_decay) \

--gradient-accumulation str(gradient_accumulation) \

--logging-steps str(logging_steps) \

--fp16 \

--use-peft \

--use-int4 \

--merge-adapter \

--push-to-hub \

--token str(hf_token) \

--repo-id "rishiraj/zephyr-math"

その他のリソース

14 - Hugging Face Accelerate

大規模なトレーニングと推論を、シンプル、効率的、かつ適応的に

Hugging Face Accelerate は、あらゆる分散設定で同じ PyTorch コードを実行できるようにし、大規模なモデルトレーニングと推論を簡素化するライブラリです。

Accelerate には、以下に示す Weights & Biases Tracker が含まれています。Accelerate Trackers の詳細については、[こちら (https://huggingface.co/docs/accelerate/main/en/usage_guides/tracking) のドキュメント] を参照してください。

Accelerate でログ記録を開始する

Accelerate と Weights & Biases を使い始めるには、以下の疑似コードに従ってください。

from accelerate import Accelerator

# Tell the Accelerator object to log with wandb

accelerator = Accelerator(log_with= "wandb" )

# Initialise your wandb run, passing wandb parameters and any config information

accelerator. init_trackers(

project_name= "my_project" ,

config= {"dropout" : 0.1 , "learning_rate" : 1e-2 }

init_kwargs= {"wandb" : {"entity" : "my-wandb-team" }}

)

...

# Log to wandb by calling `accelerator.log`, `step` is optional

accelerator. log({"train_loss" : 1.12 , "valid_loss" : 0.8 }, step= global_step)

# Make sure that the wandb tracker finishes correctly

accelerator. end_training()

さらに詳しく説明すると、次のことが必要です。

Accelerator クラスを初期化するときに log_with="wandb" を渡します。

init_trackers

project_name を介したプロジェクト名ネストされた dict を介して wandb.initinit_kwargs

config を介して、wandb の run に記録するその他の実験設定情報

.log メソッドを使用して Weigths & Biases にログを記録します。step 引数はオプションです。トレーニングが終了したら、.end_training を呼び出します。

W&B tracker へのアクセス

W&B tracker にアクセスするには、Accelerator.get_tracker() メソッドを使用します。tracker の .name 属性に対応する文字列を渡すと、main プロセスの tracker が返されます。

wandb_tracker = accelerator. get_tracker("wandb" )

そこから、通常どおり wandb の run オブジェクトを操作できます。

wandb_tracker. log_artifact(some_artifact_to_log)

Accelerate に組み込まれた Trackers は、正しいプロセスで自動的に実行されるため、Tracker がメインプロセスでのみ実行されるように設計されている場合、自動的に実行されます。

Accelerate のラッピングを完全に削除したい場合は、次の方法で同じ結果を得ることができます。

wandb_tracker = accelerator. get_tracker("wandb" , unwrap= True )

with accelerator. on_main_process:

wandb_tracker. log_artifact(some_artifact_to_log)

Accelerate の記事

以下は、楽しめるかもしれない Accelerate の記事です。

Weights & Biases でスーパーチャージされた HuggingFace Accelerate

この記事では、HuggingFace Accelerate が提供するものと、結果を Weights & Biases に記録しながら、分散トレーニングと評価をどれだけ簡単に行えるかを見ていきます。

完全なレポートは こちら をお読みください。

15 - Hydra

W&B と Hydra を統合する方法。

Hydra は、 研究 および他の複雑な アプリケーション の開発を簡素化するオープンソースの Python フレームワーク です。主な機能は、構成ファイルと コマンドライン を介して、構成を構成してオーバーライドすることにより、階層的な構成を動的に作成できることです。

W&B のパワーを利用しながら、構成管理に Hydra を引き続き使用できます。

メトリクス の 追跡

wandb.init と wandb.log を使用して、通常どおりに メトリクス を 追跡 します。ここでは、 wandb.entity と wandb.project は hydra 構成ファイル内で定義されています。

import wandb

@hydra.main (config_path= "configs/" , config_name= "defaults" )

def run_experiment (cfg):

run = wandb. init(entity= cfg. wandb. entity, project= cfg. wandb. project)

wandb. log({"loss" : loss})

ハイパーパラメーター の 追跡

Hydra は、構成 辞書 とのインターフェースをとるためのデフォルトの方法として omegaconf を使用します。 OmegaConf の 辞書 は、プリミティブ 辞書 のサブクラスではないため、Hydra の Config を wandb.config に直接渡すと、 ダッシュボード で予期しない結果が生じます。 omegaconf.DictConfig をプリミティブな dict 型に変換してから wandb.config に渡す必要があります。

@hydra.main (config_path= "configs/" , config_name= "defaults" )

def run_experiment (cfg):

wandb. config = omegaconf. OmegaConf. to_container(

cfg, resolve= True , throw_on_missing= True

)

wandb. init(entity= cfg. wandb. entity, project= cfg. wandb. project)

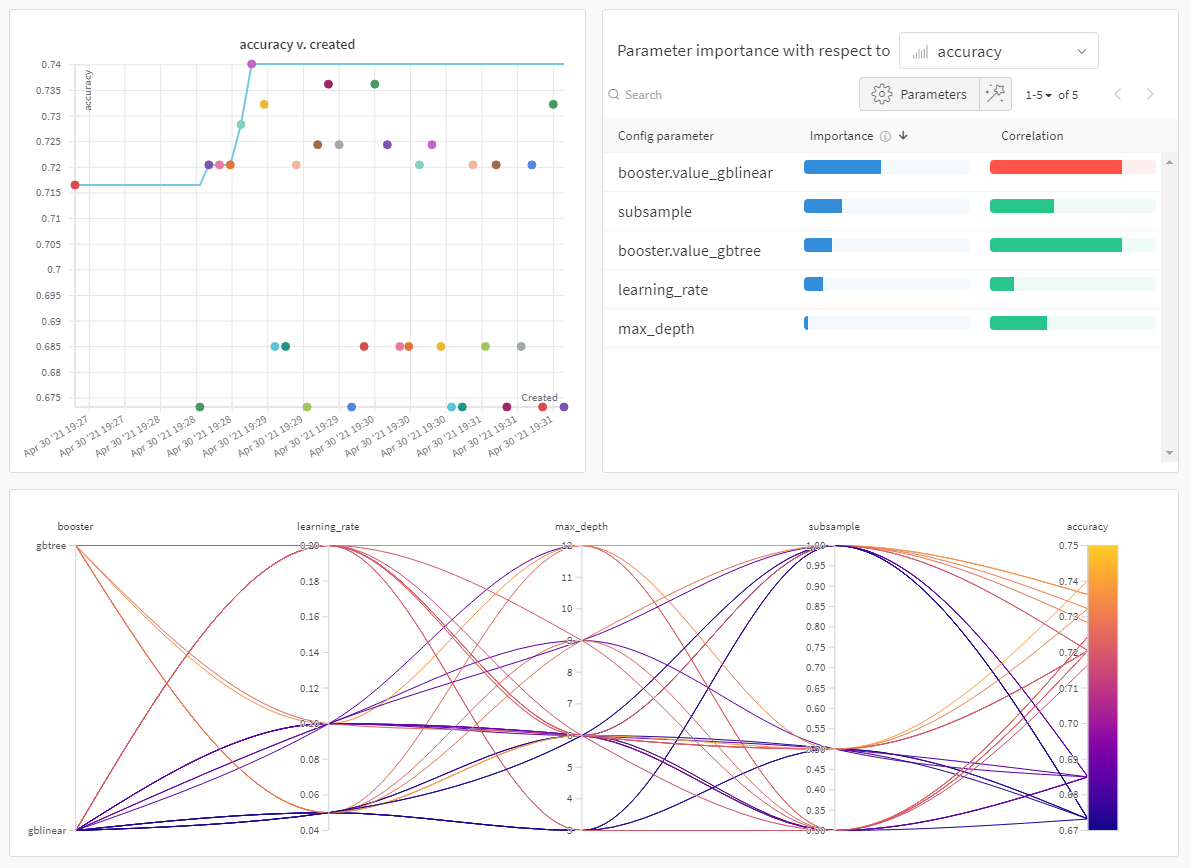

wandb. log({"loss" : loss})

model = Model(** wandb. config. model. configs)

マルチプロセッシング の トラブルシューティング

開始時に プロセス がハングする場合は、この既知の問題 が原因である可能性があります。これを解決するには、次のいずれかとして、wandb.init に追加の settings パラメータ を追加して、wandb の マルチプロセッシング プロトコル を変更してみてください。

wandb. init(settings= wandb. Settings(start_method= "thread" ))

または、シェルから グローバル 環境変数 を設定します。

$ export WANDB_START_METHOD= thread

ハイパーパラメーター の 最適化

W&B Sweeps は、高度にスケーラブルな ハイパーパラメーター 検索 プラットフォーム であり、最小限の要件コードで W&B の 実験 に関する興味深い洞察と 可視化 を提供します。 Sweeps は、コーディング要件なしで Hydra プロジェクト とシームレスに統合されます。必要なのは、通常どおりにスイープするさまざまな パラメータ を記述した構成ファイルだけです。

簡単な sweep.yaml ファイルの例を次に示します。

program : main.py

method : bayes

metric :

goal : maximize

name : test/accuracy

parameters :

dataset :

values : [mnist, cifar10]

command :

- ${env}

- python

- ${program}

- ${args_no_hyphens}

sweep を呼び出します。

wandb sweep sweep.yaml` \

W&B は プロジェクト 内に sweep を自動的に作成し、sweep を実行する各マシンで実行する wandb agent コマンド を返します。

Hydra の デフォルト に存在しない パラメータ を渡す

Hydra は、 コマンド の前に + を使用して、デフォルト の構成ファイルに存在しない追加の パラメータ を コマンドライン から渡すことをサポートしています。たとえば、次のように呼び出すだけで、いくつかの 値 を持つ追加の パラメータ を渡すことができます。

$ python program.py +experiment= some_experiment

Hydra Experiments を構成するときと同様に、このような + 構成を スイープ することはできません。これを回避するには、デフォルト の空のファイルで experiment パラメータ を初期化し、W&B Sweep を使用して、呼び出しごとにこれらの空の構成をオーバーライドします。詳細については、この W&B Report

16 - Keras

Keras コールバック

W&B には Keras 用の 3 つのコールバックがあり、wandb v0.13.4 から利用できます。従来の WandbCallback については、下にスクロールしてください。

WandbMetricsLogger実験管理 には、このコールバックを使用します。トレーニングと検証のメトリクスをシステムメトリクスとともに Weights & Biases に記録します。

WandbModelCheckpointArtifacts に記録するには、このコールバックを使用します。

WandbEvalCallbackTables に記録して、インタラクティブな可視化を実現します。

これらの新しいコールバック:

Keras の設計理念に準拠しています。

すべてに単一のコールバック(WandbCallback)を使用することによる認知負荷を軽減します。

Keras ユーザーがコールバックをサブクラス化してニッチなユースケースをサポートすることで、コールバックを簡単に変更できるようにします。

WandbMetricsLogger で実験を追跡するWandbMetricsLogger は、on_epoch_end、on_batch_end などのコールバックメソッドが引数として受け取る Keras の logs 辞書を自動的に記録します。

これにより、以下が追跡されます。

model.compile で定義されたトレーニングおよび検証のメトリクス。システム (CPU/GPU/TPU) メトリクス。

学習率 (固定値と学習率スケジューラの両方)。

import wandb

from wandb.integration.keras import WandbMetricsLogger

# 新しい W&B の run を初期化します。

wandb. init(config= {"bs" : 12 })

# WandbMetricsLogger を model.fit に渡します。

model. fit(

X_train, y_train, validation_data= (X_test, y_test), callbacks= [WandbMetricsLogger()]

)

WandbMetricsLogger リファレンス

パラメータ

説明

log_freq(epoch、batch、または int): epoch の場合、各エポックの最後にメトリクスを記録します。batch の場合、各バッチの最後にメトリクスを記録します。int の場合、その数のバッチの最後にメトリクスを記録します。デフォルトは epoch です。

initial_global_step(int): 学習率スケジューラを使用している場合に、いくつかの initial_epoch からトレーニングを再開するときに学習率を正しく記録するには、この引数を使用します。これは step_size * initial_step として計算できます。デフォルトは 0 です。

WandbModelCheckpoint を使用してモデルをチェックポイントするWandbModelCheckpoint コールバックを使用して、Keras モデル (SavedModel 形式) またはモデルの重みを定期的に保存し、モデルの バージョン管理 用の wandb.Artifact として W&B にアップロードします。

このコールバックは tf.keras.callbacks.ModelCheckpoint

このコールバックは以下を保存します。

モニターに基づいて最高のパフォーマンスを達成したモデル。

パフォーマンスに関係なく、すべてのエポックの終わりにモデル。

エポックの終わり、または固定数のトレーニングバッチの後。

モデルの重みのみ、またはモデル全体。

SavedModel 形式または .h5 形式のいずれかでモデル。

このコールバックを WandbMetricsLogger と組み合わせて使用します。

import wandb

from wandb.integration.keras import WandbMetricsLogger, WandbModelCheckpoint

# 新しい W&B の run を初期化します。

wandb. init(config= {"bs" : 12 })

# WandbModelCheckpoint を model.fit に渡します。

model. fit(

X_train,

y_train,

validation_data= (X_test, y_test),

callbacks= [

WandbMetricsLogger(),

WandbModelCheckpoint("models" ),

],

)

WandbModelCheckpoint リファレンス

パラメータ

説明

filepath(str): モードファイルを保存するパス。

monitor(str): 監視するメトリック名。

verbose(int): 詳細モード、0 または 1。モード 0 はサイレントで、モード 1 はコールバックがアクションを実行するときにメッセージを表示します。

save_best_only(Boolean): save_best_only=True の場合、最新のモデル、または monitor および mode 属性で定義されている、最良と見なされるモデルのみを保存します。

save_weights_only(Boolean): True の場合、モデルの重みのみを保存します。

mode(auto、min、または max): val_acc の場合は max に、val_loss の場合は min に設定します。

save_freq(“epoch” または int): 「epoch」を使用する場合、コールバックは各エポックの後にモデルを保存します。整数を使用する場合、コールバックはこの数のバッチの終わりにモデルを保存します。val_acc や val_loss などの検証メトリクスを監視する場合、これらのメトリクスはエポックの最後にのみ使用できるため、save_freq を “epoch” に設定する必要があることに注意してください。

options(str): save_weights_only が true の場合はオプションの tf.train.CheckpointOptions オブジェクト、save_weights_only が false の場合はオプションの tf.saved_model.SaveOptions オブジェクト。

initial_value_threshold(float): 監視するメトリックの浮動小数点初期「最良」値。

N エポック後にチェックポイントを記録する

デフォルト (save_freq="epoch") では、コールバックは各エポックの後にチェックポイントを作成し、アーティファクトとしてアップロードします。特定の数のバッチの後にチェックポイントを作成するには、save_freq を整数に設定します。N エポック後にチェックポイントを作成するには、train データローダーのカーディナリティを計算し、それを save_freq に渡します。

WandbModelCheckpoint(

filepath= "models/" ,

save_freq= int((trainloader. cardinality()* N). numpy())

)

TPU アーキテクチャでチェックポイントを効率的に記録する

TPU でチェックポイントを作成しているときに、UnimplementedError: File system scheme '[local]' not implemented エラーメッセージが表示される場合があります。これは、モデルディレクトリー (filepath) がクラウドストレージバケットパス (gs://bucket-name/...) を使用する必要があり、このバケットが TPU サーバーからアクセスできる必要があるために発生します。ただし、チェックポイント作成にはローカルパスを使用できます。これは Artifacts としてアップロードされます。

checkpoint_options = tf. saved_model. SaveOptions(experimental_io_device= "/job:localhost" )

WandbModelCheckpoint(

filepath= "models/,

options= checkpoint_options,

)

WandbEvalCallback を使用してモデルの予測を可視化するWandbEvalCallback は、主にモデルの予測、次にデータセットの可視化のための Keras コールバックを構築するための抽象ベースクラスです。

この抽象コールバックは、データセットとタスクに関して不可知論的です。これを使用するには、このベースの WandbEvalCallback コールバッククラスから継承し、add_ground_truth メソッドと add_model_prediction メソッドを実装します。

WandbEvalCallback は、次のメソッドを提供するユーティリティクラスです。

データと予測の wandb.Table インスタンスを作成します。

データと予測の Tables を wandb.Artifact として記録します。

データテーブル on_train_begin を記録します。

予測テーブル on_epoch_end を記録します。

次の例では、画像分類タスクに WandbClfEvalCallback を使用しています。この例のコールバックは、検証データ (data_table) を W&B に記録し、推論を実行し、すべてのエポックの終わりに予測 (pred_table) を W&B に記録します。

import wandb

from wandb.integration.keras import WandbMetricsLogger, WandbEvalCallback

# モデル予測の可視化コールバックを実装します。

class WandbClfEvalCallback (WandbEvalCallback):

def __init__(

self, validation_data, data_table_columns, pred_table_columns, num_samples= 100

):

super(). __init__(data_table_columns, pred_table_columns)

self. x = validation_data[0 ]

self. y = validation_data[1 ]

def add_ground_truth (self, logs= None ):

for idx, (image, label) in enumerate(zip(self. x, self. y)):

self. data_table. add_data(idx, wandb. Image(image), label)

def add_model_predictions (self, epoch, logs= None ):

preds = self. model. predict(self. x, verbose= 0 )

preds = tf. argmax(preds, axis=- 1 )

table_idxs = self. data_table_ref. get_index()

for idx in table_idxs:

pred = preds[idx]

self. pred_table. add_data(

epoch,

self. data_table_ref. data[idx][0 ],

self. data_table_ref. data[idx][1 ],

self. data_table_ref. data[idx][2 ],

pred,

)

# ...

# 新しい W&B の run を初期化します。

wandb. init(config= {"hyper" : "parameter" })

# コールバックを Model.fit に追加します。

model. fit(

X_train,

y_train,

validation_data= (X_test, y_test),

callbacks= [

WandbMetricsLogger(),

WandbClfEvalCallback(

validation_data= (X_test, y_test),

data_table_columns= ["idx" , "image" , "label" ],

pred_table_columns= ["epoch" , "idx" , "image" , "label" , "pred" ],

),

],

)

WandbEvalCallback リファレンス

パラメータ

説明

data_table_columns(list) data_table の列名のリスト

pred_table_columns(list) pred_table の列名のリスト

メモリフットプリントの詳細

on_train_begin メソッドが呼び出されると、data_table を W&B に記録します。W&B Artifact としてアップロードされると、data_table_ref クラス変数を使用してアクセスできるこのテーブルへの参照を取得します。data_table_ref は、self.data_table_ref[idx][n] のようにインデックスを付けることができる 2D リストです。ここで、idx は行番号で、n は列番号です。以下の例で使用法を見てみましょう。

コールバックをカスタマイズする

on_train_begin メソッドまたは on_epoch_end メソッドをオーバーライドして、よりきめ細かい制御を行うことができます。N バッチ後にサンプルを記録する場合は、on_train_batch_end メソッドを実装できます。

💡

WandbEvalCallback を継承してモデル予測の可視化のためのコールバックを実装していて、明確にする必要がある場合や修正する必要がある場合は、

issue を開いてお知らせください。

WandbCallback [レガシー]W&B ライブラリの WandbCallbackmodel.fit で追跡されるすべてのメトリクスと損失値を自動的に保存します。

import wandb

from wandb.integration.keras import WandbCallback

wandb. init(config= {"hyper" : "parameter" })

... # Keras でモデルをセットアップするコード

# コールバックを model.fit に渡します。

model. fit(

X_train, y_train, validation_data= (X_test, y_test), callbacks= [WandbCallback()]

)

短いビデオ 1 分以内に Keras と Weights & Biases を使い始める をご覧ください。

より詳細なビデオについては、Weights & Biases と Keras を統合する をご覧ください。Colab Jupyter Notebook を確認できます。

WandbCallback クラスは、監視するメトリックの指定、重みと勾配の追跡、training_data と validation_data での予測の記録など、さまざまなログ構成オプションをサポートしています。

詳細については、keras.WandbCallback のリファレンスドキュメント

WandbCallback

Keras によって収集されたメトリクスから履歴データを自動的に記録します: 損失と keras_model.compile() に渡されたもの。

monitor および mode 属性で定義されているように、「最良」のトレーニングステップに関連付けられた run の概要メトリクスを設定します。これはデフォルトで、最小の val_loss を持つエポックになります。WandbCallback はデフォルトで、最良の epoch に関連付けられたモデルを保存します。オプションで勾配とパラメーターのヒストグラムを記録します。

オプションで、wandb が可視化するためにトレーニングデータと検証データを保存します。

WandbCallback リファレンス

引数

monitor(str) 監視するメトリックの名前。デフォルトは val_loss。

mode(str) {auto、min、max} のいずれか。min - モニターが最小化されたときにモデルを保存します max - モニターが最大化されたときにモデルを保存します auto - モデルを保存するタイミングを推測しようとします (デフォルト)。

save_modelTrue - モニターが以前のエポックをすべて上回ったときにモデルを保存します False - モデルを保存しません

save_graph(boolean) True の場合、モデルグラフを wandb に保存します (デフォルトは True)。

save_weights_only(boolean) True の場合、モデルの重みのみを保存します (model.save_weights(filepath))。それ以外の場合は、完全なモデルを保存します)。

log_weights(boolean) True の場合、モデルのレイヤーの重みのヒストグラムを保存します。

log_gradients(boolean) True の場合、トレーニング勾配のヒストグラムを記録します

training_data(tuple) model.fit に渡されるのと同じ形式 (X,y)。これは勾配を計算するために必要です。log_gradients が True の場合は必須です。

validation_data(tuple) model.fit に渡されるのと同じ形式 (X,y)。wandb が可視化するためのデータのセット。このフィールドを設定すると、すべてのエポックで、wandb は少数の予測を行い、後で可視化するために結果を保存します。

generator(generator) wandb が可視化するための検証データを返すジェネレーター。このジェネレーターはタプル (X,y) を返す必要があります。wandb が特定のデータ例を可視化するには、validate_data またはジェネレーターのいずれかを設定する必要があります。

validation_steps(validation_data がジェネレーターの場合、完全な検証セットに対してジェネレーターを実行するステップ数 (int)。

labels(list) wandb でデータを可視化している場合、このラベルのリストは、複数のクラスを持つ分類子を構築している場合に、数値出力を理解可能な文字列に変換します。バイナリ分類子の場合、2 つのラベルのリスト [false のラベル、true のラベル] を渡すことができます。validate_data と generator の両方が false の場合、これは何も行いません。

predictions(int) 可視化のために各エポックで行う予測の数。最大は 100 です。

input_type(string) 可視化を支援するモデル入力のタイプ。(image、images、segmentation_mask) のいずれかになります。

output_type(string) モデル出力のタイプを可視化するのに役立ちます。(image、images、segmentation_mask) のいずれかになります。

log_evaluation(boolean) True の場合、各エポックで検証データとモデルの予測を含む Table を保存します。詳細については、validation_indexes、validation_row_processor、および output_row_processor を参照してください。

class_colors([float, float, float]) 入力または出力がセグメンテーションマスクの場合、各クラスの rgb タプル (範囲 0 ~ 1) を含む配列。

log_batch_frequency(integer) None の場合、コールバックはすべてのエポックを記録します。整数に設定すると、コールバックは log_batch_frequency バッチごとにトレーニングメトリクスを記録します。

log_best_prefix(string) None の場合、追加の概要メトリクスは保存されません。文字列に設定すると、監視対象のメトリックとエポックにプレフィックスを付加し、結果を概要メトリクスとして保存します。

validation_indexes([wandb.data_types._TableLinkMixin]) 各検証例に関連付けるインデックスキーの順序付きリスト。log_evaluation が True で、validation_indexes を提供する場合、検証データの Table は作成されません。代わりに、各予測を TableLinkMixin で表される行に関連付けます。行キーのリストを取得するには、Table.get_index() を使用します。

validation_row_processor(Callable) 検証データに適用する関数。通常はデータを可視化するために使用されます。この関数は、ndx (int) と row (dict) を受け取ります。モデルに単一の入力がある場合、row["input"] には行の入力データが含まれます。それ以外の場合は、入力スロットの名前が含まれます。適合関数が単一のターゲットを受け取る場合、row["target"] には行のターゲットデータが含まれます。それ以外の場合は、出力スロットの名前が含まれます。たとえば、入力データが単一の配列である場合、データを画像として可視化するには、プロセッサとして lambda ndx, row: {"img": wandb.Image(row["input"])} を指定します。log_evaluation が False であるか、validation_indexes が存在する場合は無視されます。

output_row_processor(Callable) validation_row_processor と同じですが、モデルの出力に適用されます。row["output"] には、モデル出力の結果が含まれます。

infer_missing_processors(Boolean) validation_row_processor と output_row_processor が欠落している場合に、推論するかどうかを決定します。デフォルトは True です。labels を指定すると、W&B は必要に応じて分類タイプのプロセッサを推論しようとします。

log_evaluation_frequency(int) 評価結果を記録する頻度を決定します。デフォルトは 0 で、トレーニングの最後にのみ記録します。すべてのエポックで記録するには 1 に、他のすべてのエポックで記録するには 2 に設定します。log_evaluation が False の場合は効果がありません。

よくある質問

Keras マルチプロセッシングを wandb で使用するにはどうすればよいですか?use_multiprocessing=True を設定すると、次のエラーが発生する可能性があります。

Error("You must call wandb.init() before wandb.config.batch_size" )

これを回避するには:

Sequence クラスの構築で、wandb.init(group='...') を追加します。main で、if __name__ == "__main__": を使用していることを確認し、残りのスクリプト ロジックをその中に入れます。

17 - Kubeflow Pipelines (kfp)

W&B と Kubeflow Pipelines を統合する方法。

Kubeflow Pipelines (kfp) は、Docker コンテナに基づいて、移植可能でスケーラブルな 機械学習 (ML) ワークフローを構築およびデプロイするためのプラットフォームです。

このインテグレーションにより、ユーザーはデコレーターを kfp python 関数コンポーネントに適用して、 パラメータと Artifacts を W&B に自動的に記録できます。

この機能は wandb==0.12.11 で有効になり、kfp<2.0.0 が必要です。

サインアップして API キーを作成する

API キーは、お使いのマシンを W&B に対して認証します。API キーは、ユーザープロファイルから生成できます。

右上隅にあるユーザープロファイルアイコンをクリックします。

[User Settings ] を選択し、[API Keys ] セクションまでスクロールします。

[Reveal ] をクリックします。表示された API キーをコピーします。API キーを非表示にするには、ページをリロードします。

wandb ライブラリをインストールしてログインするwandb ライブラリをローカルにインストールしてログインするには:

コマンドライン

Python

Python notebook

API キーに WANDB_API_KEY 環境変数 を設定します。

export WANDB_API_KEY= <your_api_key>

wandb ライブラリをインストールしてログインします。

pip install wandb

wandb login

import wandb

wandb. login()

!pip install wandb

import wandb

wandb.login()

コンポーネントをデコレートする

@wandb_log デコレーターを追加し、通常どおりにコンポーネントを作成します。これにより、パイプラインを実行するたびに、入力/出力 パラメータ と Artifacts が自動的に W&B に記録されます。

from kfp import components

from wandb.integration.kfp import wandb_log

@wandb_log

def add (a: float, b: float) -> float:

return a + b

add = components. create_component_from_func(add)

環境変数をコンテナに渡す

環境変数 をコンテナに明示的に渡す必要がある場合があります。双方向のリンクを行うには、環境変数 WANDB_KUBEFLOW_URL を Kubeflow Pipelines インスタンスのベース URL に設定する必要があります。たとえば、https://kubeflow.mysite.com です。

import os

from kubernetes.client.models import V1EnvVar

def add_wandb_env_variables (op):

env = {

"WANDB_API_KEY" : os. getenv("WANDB_API_KEY" ),

"WANDB_BASE_URL" : os. getenv("WANDB_BASE_URL" ),

}

for name, value in env. items():

op = op. add_env_variable(V1EnvVar(name, value))

return op

@dsl.pipeline (name= "example-pipeline" )

def example_pipeline (param1: str, param2: int):

conf = dsl. get_pipeline_conf()

conf. add_op_transformer(add_wandb_env_variables)

プログラムでデータにアクセスする

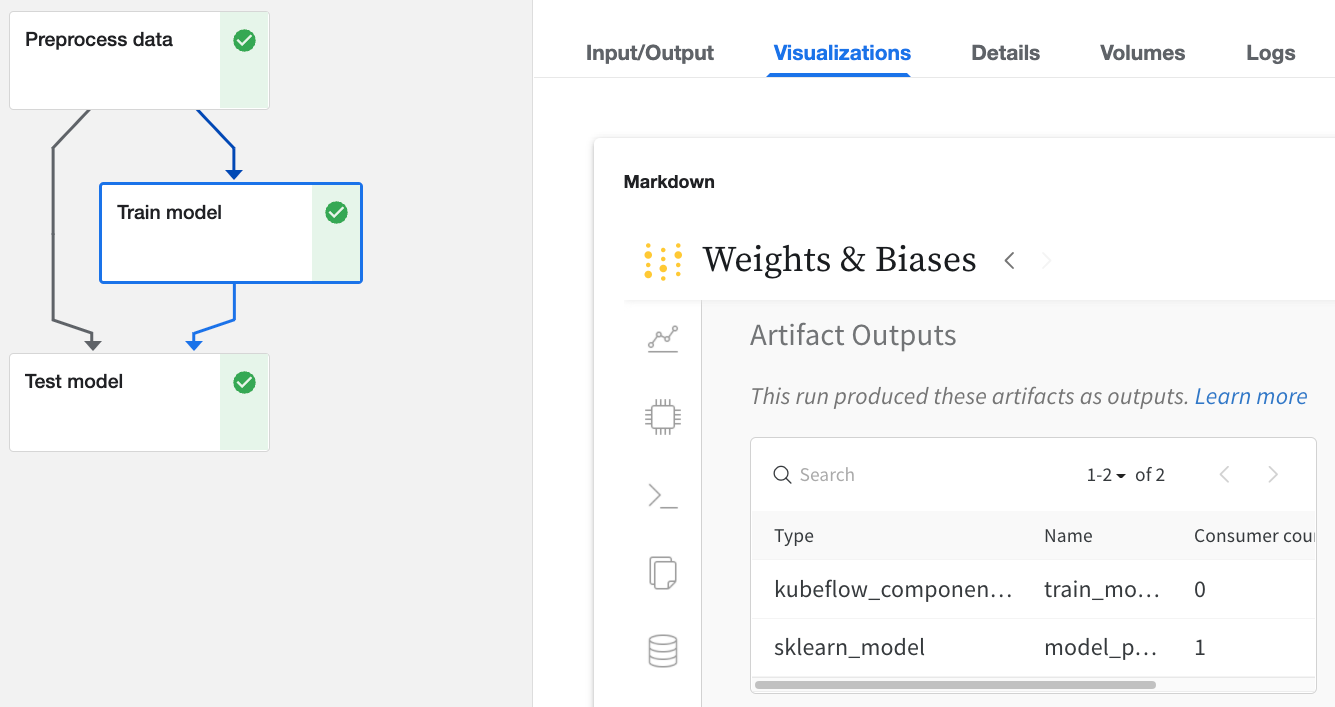

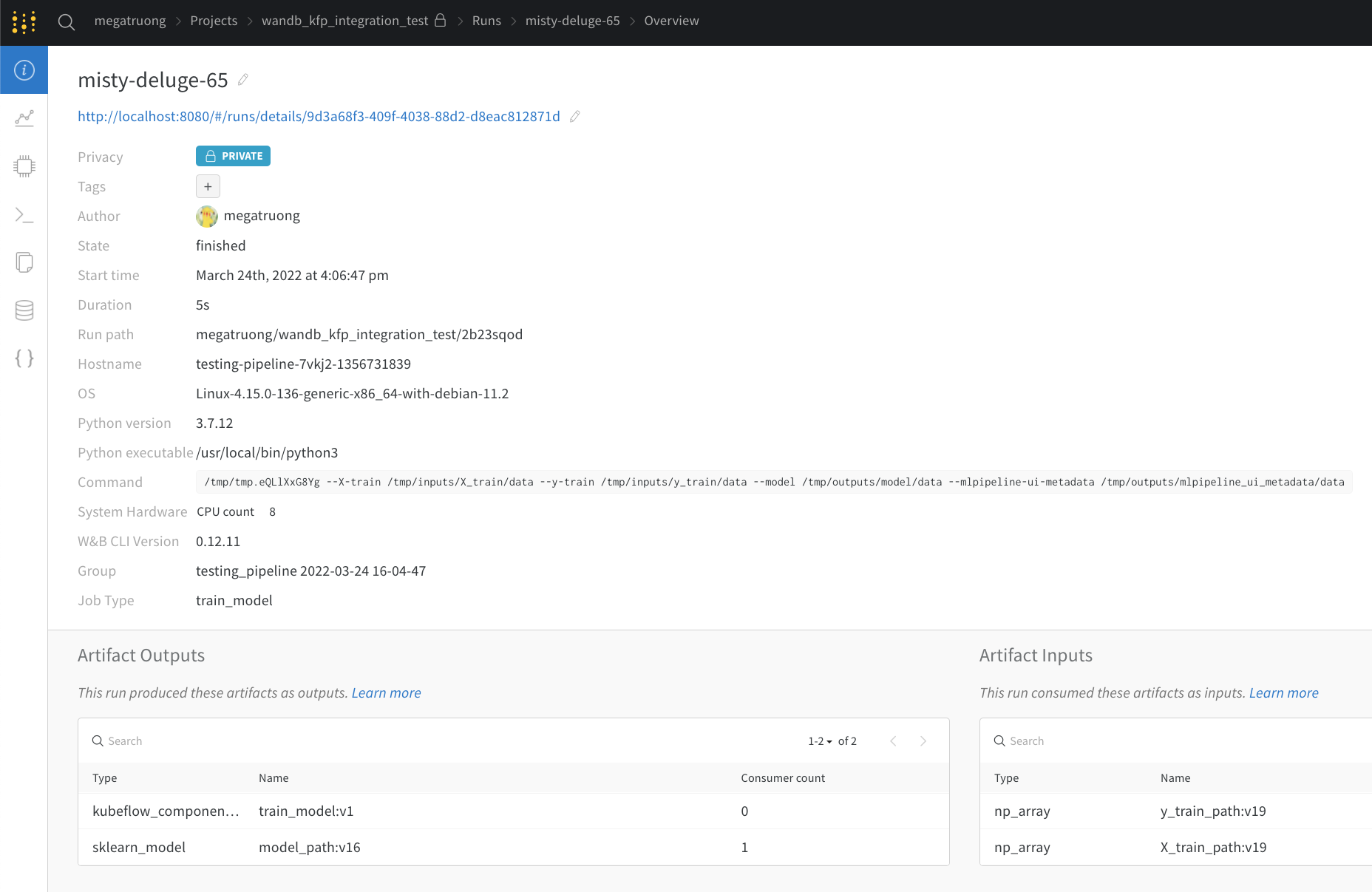

Kubeflow Pipelines UI 経由

W&B でログに記録された Kubeflow Pipelines UI の Run をクリックします。

[ Input/Output ] タブと [ ML Metadata ] タブで、入力と出力に関する詳細を確認します。

[ Visualizations ] タブから W&B Web アプリを表示します。

Web アプリ UI 経由

Web アプリ UI には、Kubeflow Pipelines の [ Visualizations ] タブと同じコンテンツがありますが、より広いスペースがあります。Web アプリ UI の詳細はこちら をご覧ください。

パブリック API 経由 (プログラムによるアクセス)

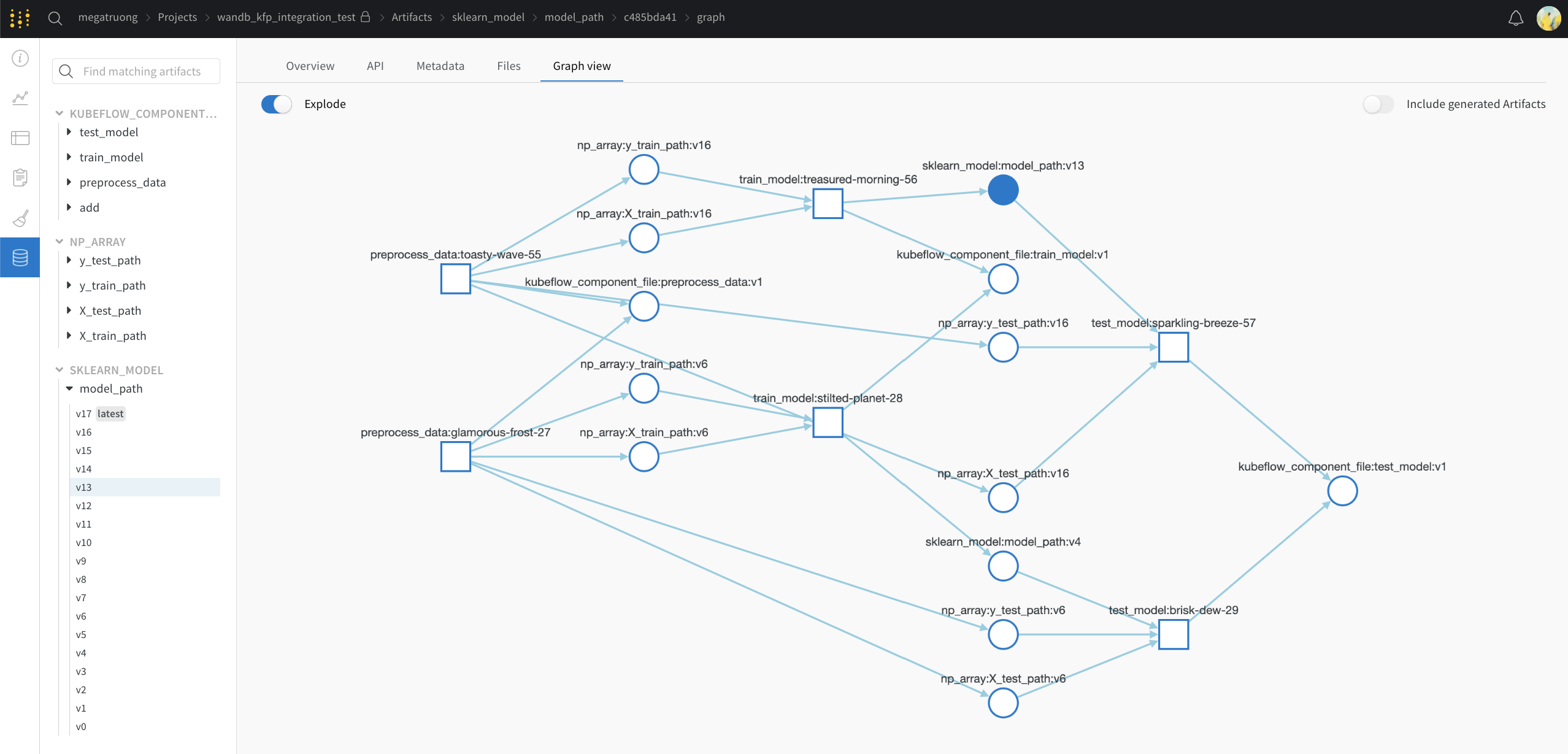

Kubeflow Pipelines から W&B へのコンセプトマッピング

Kubeflow Pipelines のコンセプトから W&B へのマッピングを次に示します。

きめ細かいロギング

ロギングをより細かく制御したい場合は、コンポーネントに wandb.log および wandb.log_artifact 呼び出しを追加できます。

明示的な wandb.log_artifacts 呼び出しを使用

以下の例では、モデルをトレーニングしています。@wandb_log デコレーターは、関連する入力と出力を自動的に追跡します。トレーニングプロセスをログに記録する場合は、次のように明示的にロギングを追加できます。

@wandb_log

def train_model (

train_dataloader_path: components. InputPath("dataloader" ),

test_dataloader_path: components. InputPath("dataloader" ),

model_path: components. OutputPath("pytorch_model" ),

):

...

for epoch in epochs:

for batch_idx, (data, target) in enumerate(train_dataloader):

...

if batch_idx % log_interval == 0 :

wandb. log(

{"epoch" : epoch, "step" : batch_idx * len(data), "loss" : loss. item()}

)

...

wandb. log_artifact(model_artifact)

暗黙的な wandb インテグレーションを使用

サポートするフレームワーク インテグレーション を使用している場合は、コールバックを直接渡すこともできます。

@wandb_log

def train_model (

train_dataloader_path: components. InputPath("dataloader" ),

test_dataloader_path: components. InputPath("dataloader" ),

model_path: components. OutputPath("pytorch_model" ),

):

from pytorch_lightning.loggers import WandbLogger

from pytorch_lightning import Trainer

trainer = Trainer(logger= WandbLogger())

... # do training

18 - LightGBM

W&B で ツリー を追跡しましょう。

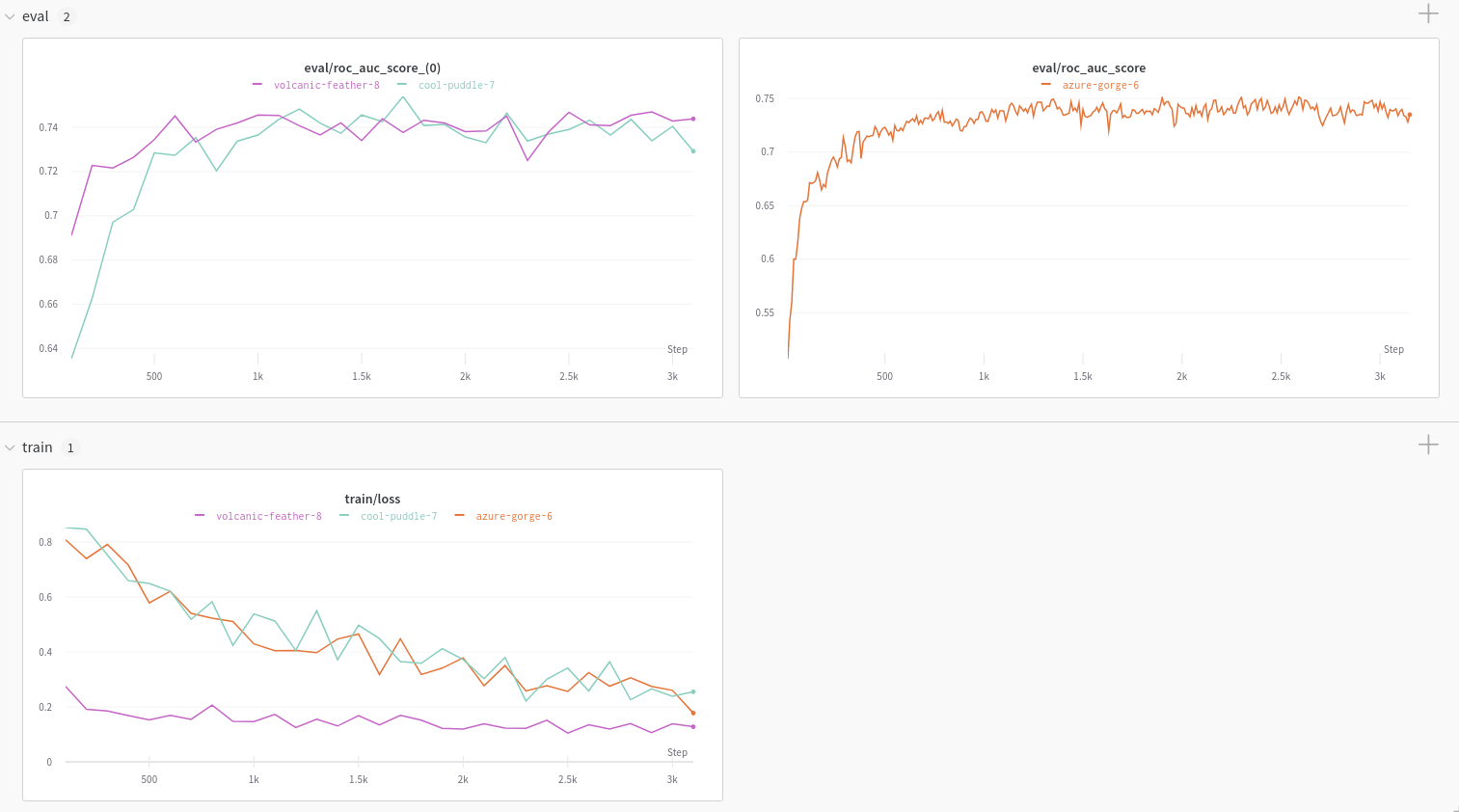

wandb ライブラリには、 LightGBM 用の特別な コールバック が含まれています。また、 Weights & Biases の汎用的な ログ 機能を使用すると、 ハイパーパラメーター 探索 のような大規模な 実験 を簡単に追跡できます。

from wandb.integration.lightgbm import wandb_callback, log_summary

import lightgbm as lgb

# メトリクス を W&B に ログ 記録

gbm = lgb. train(... , callbacks= [wandb_callback()])

# 特徴量の インポータンスプロット を ログ 記録し、 モデル の チェックポイント を W&B にアップロード

log_summary(gbm, save_model_checkpoint= True )

Sweeps を使用した ハイパーパラメーター の調整

モデル のパフォーマンスを最大限に引き出すには、 ツリー の深さや学習率などの ハイパーパラメーター を調整する必要があります。Weights & Biases には、大規模な ハイパーパラメーター のテスト 実験 を構成、編成、分析するための強力な ツールキットである Sweeps が含まれています。

これらの ツール の詳細と、XGBoost で Sweeps を使用する方法の例については、このインタラクティブな Colab ノートブック をご覧ください。

19 - Metaflow

Metaflow と W&B を統合する方法。

概要

Metaflow は、ML ワークフローを作成および実行するために Netflix によって作成されたフレームワークです。

このインテグレーションを使用すると、Metaflow の ステップとフロー にデコレータを適用して、パラメータと Artifacts を自動的に W&B にログ記録できます。

ステップをデコレートすると、そのステップ内の特定の種類に対するログ記録をオフまたはオンにします。

フローをデコレートすると、フロー内のすべてのステップに対するログ記録をオフまたはオンにします。

クイックスタート

サインアップして APIキー を作成する

APIキー は、お使いのマシンを W&B に対して認証します。APIキー は、ユーザープロファイルから生成できます。

右上隅にあるユーザープロファイルアイコンをクリックします。

[User Settings ] を選択し、[API Keys ] セクションまでスクロールします。

[Reveal ] をクリックします。表示された APIキー をコピーします。APIキー を非表示にするには、ページをリロードします。

wandb ライブラリをインストールしてログインするwandb ライブラリをローカルにインストールしてログインするには:

コマンドライン

Python

Python notebook

WANDB_API_KEY 環境変数 を APIキー に設定します。

export WANDB_API_KEY= <your_api_key>

wandb ライブラリをインストールしてログインします。

pip install -Uqqq metaflow fastcore wandb

wandb login

pip install -Uqqq metaflow fastcore wandb

import wandb

wandb. login()

!pip install -Uqqq metaflow fastcore wandb

import wandb

wandb.login()

フローとステップをデコレートする

ステップをデコレートすると、そのステップ内の特定の種類に対するログ記録をオフまたはオンにします。

この例では、start 内のすべての Datasets と Models がログ記録されます。

from wandb.integration.metaflow import wandb_log

class WandbExampleFlow (FlowSpec):

@wandb_log (datasets= True , models= True , settings= wandb. Settings(... ))

@step

def start (self):

self. raw_df = pd. read_csv(... ). # pd.DataFrame -> upload as dataset

self. model_file = torch. load(... ) # nn.Module -> upload as model

self. next(self. transform)

フローをデコレートすることは、すべての構成ステップをデフォルトでデコレートすることと同じです。

この場合、WandbExampleFlow のすべてのステップは、Datasets と Models をデフォルトでログ記録します。これは、各ステップを @wandb_log(datasets=True, models=True) でデコレートするのと同じです。

from wandb.integration.metaflow import wandb_log

@wandb_log (datasets= True , models= True ) # decorate all @step

class WandbExampleFlow (FlowSpec):

@step

def start (self):

self. raw_df = pd. read_csv(... ). # pd.DataFrame -> upload as dataset

self. model_file = torch. load(... ) # nn.Module -> upload as model

self. next(self. transform)

フローをデコレートすることは、すべてのステップをデフォルトでデコレートすることと同じです。つまり、後で別の @wandb_log でステップをデコレートすると、フローレベルのデコレーションがオーバーライドされます。

この例では:

start と mid は Datasets と Models の両方をログ記録します。end は Datasets も Models もログ記録しません。

from wandb.integration.metaflow import wandb_log

@wandb_log (datasets= True , models= True ) # same as decorating start and mid

class WandbExampleFlow (FlowSpec):

# this step will log datasets and models

@step

def start (self):

self. raw_df = pd. read_csv(... ). # pd.DataFrame -> upload as dataset

self. model_file = torch. load(... ) # nn.Module -> upload as model

self. next(self. mid)

# this step will also log datasets and models

@step

def mid (self):

self. raw_df = pd. read_csv(... ). # pd.DataFrame -> upload as dataset

self. model_file = torch. load(... ) # nn.Module -> upload as model

self. next(self. end)

# this step is overwritten and will NOT log datasets OR models

@wandb_log (datasets= False , models= False )

@step

def end (self):

self. raw_df = pd. read_csv(... ).

self. model_file = torch. load(... )

プログラムでデータにアクセスする

キャプチャした情報には、次の 3 つの方法でアクセスできます。wandb クライアントライブラリweb アプリ UI を使用、または Public API を使用してプログラムでアクセスできます。Parameter は W&B の configOverview タブ にあります。datasets、models、および others は W&B Artifacts に保存され、Artifacts タブ にあります。Base python タイプは W&B の summaryPublic API のガイド を参照してください。

クイックリファレンス

データ

クライアントライブラリ

UI

Parameter(...)wandb.configOverview タブ, Config

datasets、models、otherswandb.use_artifact("{var_name}:latest")Artifacts タブ

Base Python タイプ (dict、list、str など)

wandb.summaryOverview タブ, Summary

wandb_log kwargs

kwarg

オプション

datasetsTrue: データセットであるインスタンス変数をログに記録しますFalse

modelsTrue: モデルであるインスタンス変数をログに記録しますFalse

othersTrue: シリアル化可能なものをピクルとしてログに記録しますFalse

settingswandb.Settings(…): このステップまたはフローに独自の wandb 設定を指定しますNone: wandb.Settings() を渡すのと同じですデフォルトでは、以下の場合:

settings.run_group が None の場合、{flow_name}/{run_id} に設定されますsettings.run_job_type が None の場合、{run_job_type}/{step_name} に設定されます

よくある質問

実際に何をログに記録しますか?すべてのインスタンス変数とローカル変数をログに記録しますか?

wandb_log はインスタンス変数のみをログに記録します。ローカル変数は決してログに記録されません。これは、不要なデータのログ記録を回避するのに役立ちます。

どのデータ型がログに記録されますか?

現在、これらのタイプをサポートしています。

ログ設定

タイプ

デフォルト (常にオン)

dict, list, set, str, int, float, bool

datasets

modelsnn.Modulesklearn.base.BaseEstimator

others

ログ記録の振る舞いを構成するにはどうすればよいですか?

変数の種類

振る舞い

例

データ型

インスタンス

自動ログ記録

self.accuracyfloat

インスタンス

datasets=True の場合にログ記録self.dfpd.DataFrame

インスタンス

datasets=False の場合はログ記録されませんself.dfpd.DataFrame

ローカル

決してログ記録されない

accuracyfloat

ローカル

決してログ記録されない

dfpd.DataFrame

Artifacts のリネージは追跡されますか?

はい。Artifact がステップ A の出力であり、ステップ B の入力である場合、リネージ DAG が自動的に構築されます。

この振る舞いの例については、この notebook と対応する W&B Artifacts ページ を参照してください。

20 - MMEngine

MMEngine は OpenMMLab によって開発された、PyTorch をベースとした ディープラーニング モデルのトレーニングを行うための基盤 ライブラリです。MMEngine は OpenMMLab アルゴリズム ライブラリの次世代トレーニング アーキテクチャーを実装し、OpenMMLab 内の 30 以上のアルゴリズム ライブラリに統一された実行基盤を提供します。そのコア コンポーネントには、トレーニング エンジン、評価エンジン、およびモジュール管理が含まれます。

Weights and Biases は、専用の WandbVisBackend

トレーニング および 評価 メトリクスを ログに記録する。

実験 の config を ログに記録および管理する。

グラフ、画像、スカラーなどの追加レコードを ログに記録する。

はじめに

openmim と wandb をインストールします。

pip install -q -U openmim wandb

!pip install -q -U openmim wandb

次に、mim を使用して mmengine と mmcv をインストールします。

mim install -q mmengine mmcv

!mim install -q mmengine mmcv

WandbVisBackend を MMEngine Runner で使用するこのセクションでは、mmengine.runner.RunnerWandbVisBackend を使用する典型的な ワークフロー を示します。

可視化 config から visualizer を定義します。

from mmengine.visualization import Visualizer

# 可視化 config を定義します

visualization_cfg = dict(

name= "wandb_visualizer" ,

vis_backends= [

dict(

type= 'WandbVisBackend' ,

init_kwargs= dict(project= "mmengine" ),

)

],

save_dir= "runs/wandb"

)

# 可視化 config から visualizer を取得します

visualizer = Visualizer. get_instance(** visualization_cfg)

[W&B run 初期化](/ja/ref/python/init/) の入力 パラメータ に、 引数 の 辞書 を `init_kwargs` に渡します。

visualizer で runner を初期化し、runner.train() を呼び出します。

from mmengine.runner import Runner

# PyTorch のトレーニング ヘルパーである mmengine Runner を構築します

runner = Runner(

model,

work_dir= 'runs/gan/' ,