Create an experiment

W&B 실험 만들기.

2 minute read

몇 줄의 코드로 기계 학습 Experiments 를 추적하세요. 그런 다음 대화형 대시보드에서 결과를 검토하거나, Public API를 사용하여 프로그래밍 방식으로 엑세스할 수 있도록 데이터를 Python으로 내보낼 수 있습니다.

PyTorch, Keras, 또는 Scikit과 같은 널리 사용되는 프레임워크를 사용하는 경우 W&B Integrations 를 활용하세요. W&B 를 코드에 추가하는 방법에 대한 정보 및 전체 인테그레이션 목록은 Integration 가이드를 참조하세요.

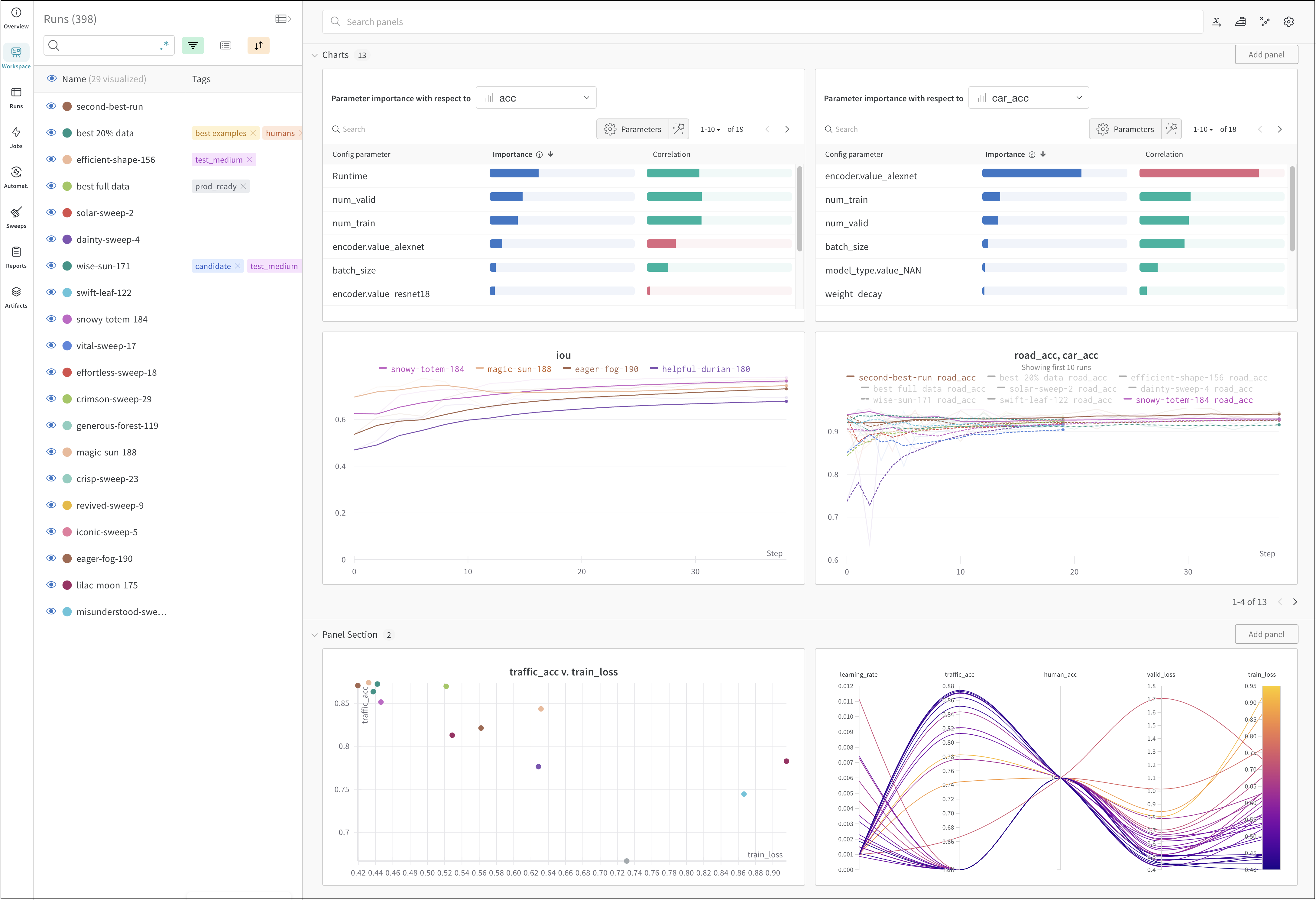

위의 이미지는 여러 runs에서 메트릭을 보고 비교할 수 있는 대시보드 의 예시를 보여줍니다.

몇 줄의 코드로 기계 학습 experiment 를 추적합니다.

run.config)에 저장합니다.run.log())을 기록합니다.다음 코드는 일반적인 W&B experiment 추적 워크플로우를 보여줍니다.

# Start a run.

#

# When this block exits, it waits for logged data to finish uploading.

# If an exception is raised, the run is marked failed.

with wandb.init(entity="", project="my-project-name") as run:

# Save mode inputs and hyperparameters.

run.config.learning_rate = 0.01

# Run your experiment code.

for epoch in range(num_epochs):

# Do some training...

# Log metrics over time to visualize model performance.

run.log({"loss": loss})

# Upload model outputs as artifacts.

run.log_artifact(model)

유스 케이스에 따라 다음 리소스를 탐색하여 W&B Experiments 를 시작하세요.

Experiments 및 로깅에 대한 모범 사례 및 팁은 Best Practices: Experiments and Logging 를 참조하세요.

W&B 실험 만들기.

사전 과 유사한 오브젝트를 사용하여 실험 설정을 저장합니다.

모델의 버전을 비교하고, 임시 워크스페이스에서 결과를 탐색하고, 발견한 내용을 리포트로 내보내 노

트와 시각화를 저장하세요.

대화형 시각화로 run 데이터를 탐색할 수 있는 플레이그라운드

W&B의 기본 구성 요소인 Runs에 대해 알아보세요.

메트릭, 비디오, 사용자 정의 플롯 등을 추적하세요.

Jupyter 와 W&B를 함께 사용하여 노트북을 벗어나지 않고도 대화형 시각화 를 얻으세요.

제안된 범위 내에서 로깅하여 W&B에서 페이지를 더 빠르고 반응적으로 유지하세요.

MLFlow에서 데이터를 가져오고, W&B에 저장한 데이터를 내보내거나 업데이트합니다.

W&B 환경 변수를 설정하세요.

Was this page helpful?

Glad to hear it! Please tell us how we can improve.

Sorry to hear that. Please tell us how we can improve.